ICML 2024 | 梯度检查点太慢?不降速、省显存,LowMemoryBP大幅提升反向传播显存效率

ICML 2024 | 梯度检查点太慢?不降速、省显存,LowMemoryBP大幅提升反向传播显存效率自从大型 Transformer 模型逐渐成为各个领域的统一架构,微调就成为了将预训练大模型应用到下游任务的重要手段

来自主题: AI技术研报

10917 点击 2024-07-12 17:47

自从大型 Transformer 模型逐渐成为各个领域的统一架构,微调就成为了将预训练大模型应用到下游任务的重要手段

给大模型加上第三种记忆格式,把宝贵的参数从死记硬背知识中解放出来!

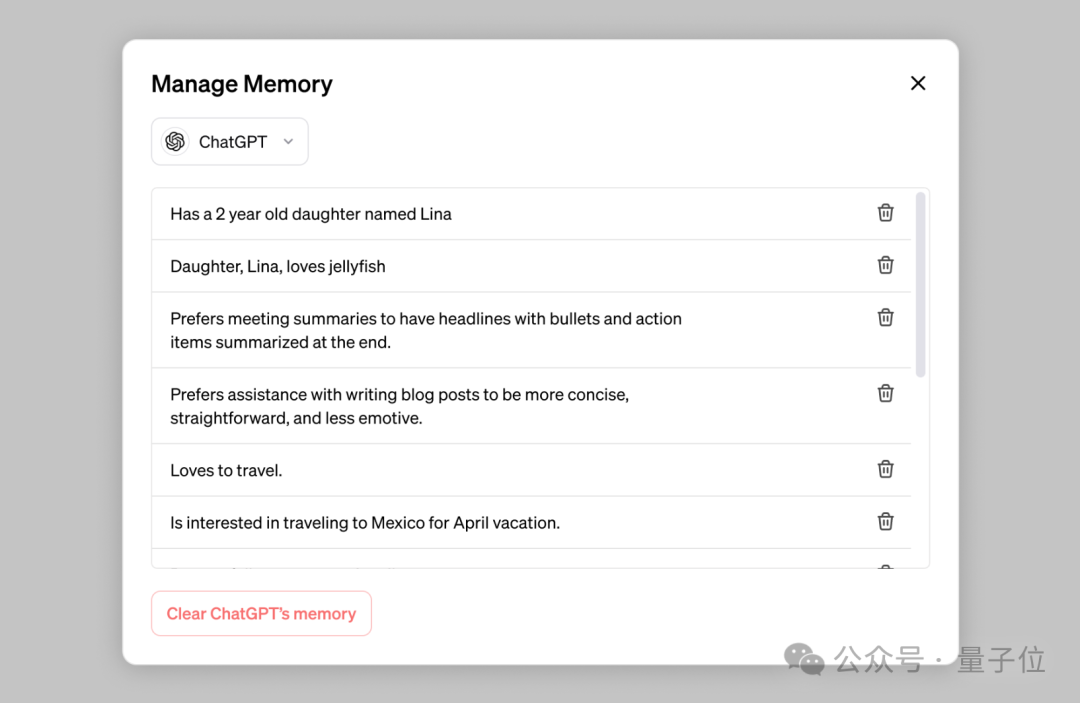

工具使用(Tool Use)和个性化记忆(Personalization Memory)是目前AI Agent最重要的基础设施

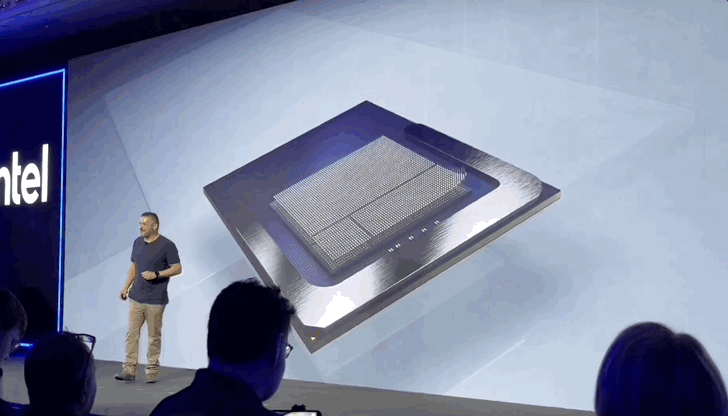

英特尔为了AI,再次做出重大架构变革: 像手机一样搞起SoC(系统级芯片),你的下一台笔记本不会再有独立内存条。 刚刚推出的新一代AI PC低功耗移动平台架构Lunar Lake,采用全新MoP(Memory on Package)封装,片上集成16或32GB的LPDDR5X内存,无法再额外连接更多RAM。

它通过将压缩记忆(compressive memory)整合到线性注意力机制中,用来处理无限长上下文

ChatGPT又要推出新功能了,这次名叫“记忆”(Memory)。如其名,作用就是让AI记住用户此前的对话内容。