Adam的稳+Muon的快?华为诺亚开源ROOT破解大模型训练「既要又要」的两难困境

Adam的稳+Muon的快?华为诺亚开源ROOT破解大模型训练「既要又要」的两难困境在 LLM 优化领域,有两个响亮的名字:Adam(及其变体 AdamW)和 Muon。

来自主题: AI技术研报

9901 点击 2025-11-27 14:37

在 LLM 优化领域,有两个响亮的名字:Adam(及其变体 AdamW)和 Muon。

2025年前盛行的闭源+重资本范式正被DeepSeek-R1与月之暗面Kimi K2 Thinking改写,二者以数百万美元成本、开源权重,凭MoE与MuonClip等优化,在SWE-Bench与BrowseComp等基准追平或超越GPT-5,并以更低API价格与本地部署撬动市场预期,促使行业从砸钱堆料转向以架构创新与稳定训练为核心的高效路线。

未中顶会,没有发表arXiv,一篇博客却成为OpenAI速通票。天才科学家Keller Jordan仅凭Muon优化器博客加入OpenAI。甚至,它可能被用于训练下一代超级模型GPT-5。

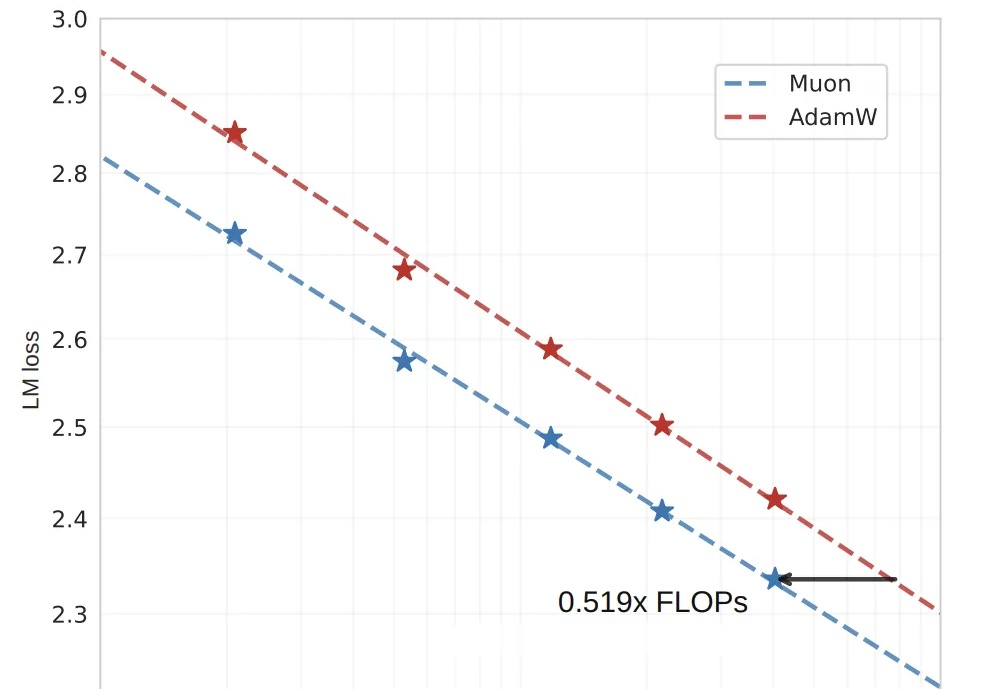

省一半算力跑出2倍效果,月之暗面开源优化器Muon,同预算下全面领先。

算力需求比AdamW直降48%,OpenAI技术人员提出的训练优化算法Muon,被月之暗面团队又推进了一步!