突破具身智能任务规划边界,刷新具身大脑多榜单SOTA,中兴EmbodiedBrain模型让具身大脑学会「复杂规划」

突破具身智能任务规划边界,刷新具身大脑多榜单SOTA,中兴EmbodiedBrain模型让具身大脑学会「复杂规划」在人工通用智能(AGI)的探索征程中,具身智能 Agents 作为连接数字认知与物理世界的关键载体,其核心价值在于能够在真实物理环境中实现稳健的空间感知、高效的任务规划与自适应的执行闭环。

在人工通用智能(AGI)的探索征程中,具身智能 Agents 作为连接数字认知与物理世界的关键载体,其核心价值在于能够在真实物理环境中实现稳健的空间感知、高效的任务规划与自适应的执行闭环。

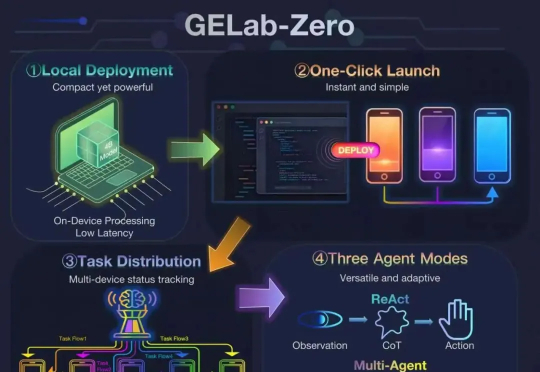

首次将GUI Agent模型与完整配套基建同步开放,支持手搓党一键部署!这就是阶跃星辰刚刚开源的GELab-Zero。其中4B版本的GUI Agent模型在手机端、电脑端等多个GUI榜单上全面刷新同尺寸模型性能纪录,取得SOTA成绩。

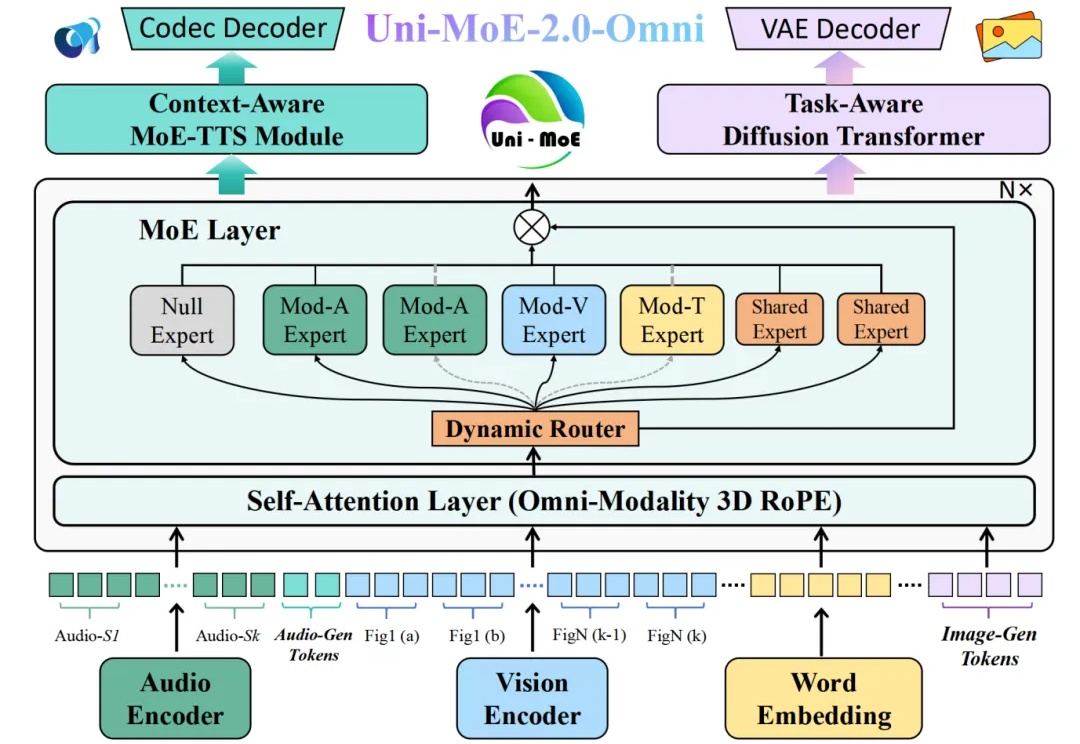

全模态大模型(Omnimodal Large Models, OLMs)能够理解、生成、处理并关联真实世界多种数据类型,从而实现更丰富的理解以及与复杂世界的深度交互。人工智能向全模态大模型的演进,标志着其从「专才」走向「通才」,从「工具」走向「伙伴」的关键点。

扩散概率生成模型(Diffusion Models)已成为AIGC时代的重要基础,但其推理速度慢、训练与推理之间的差异大,以及优化困难,始终是制约其广泛应用的关键问题。近日,被NeurIPS 2025接收的一篇重磅论文EVODiff给出了全新解法:来自华南理工大学曾德炉教授「统计推断,数据科学与人工智能」研究团队跳出了传统的数值求解思维,首次从信息感知的推理视角,将去噪过程重构为实时熵减优化问题。

模型也要学会取长补短。

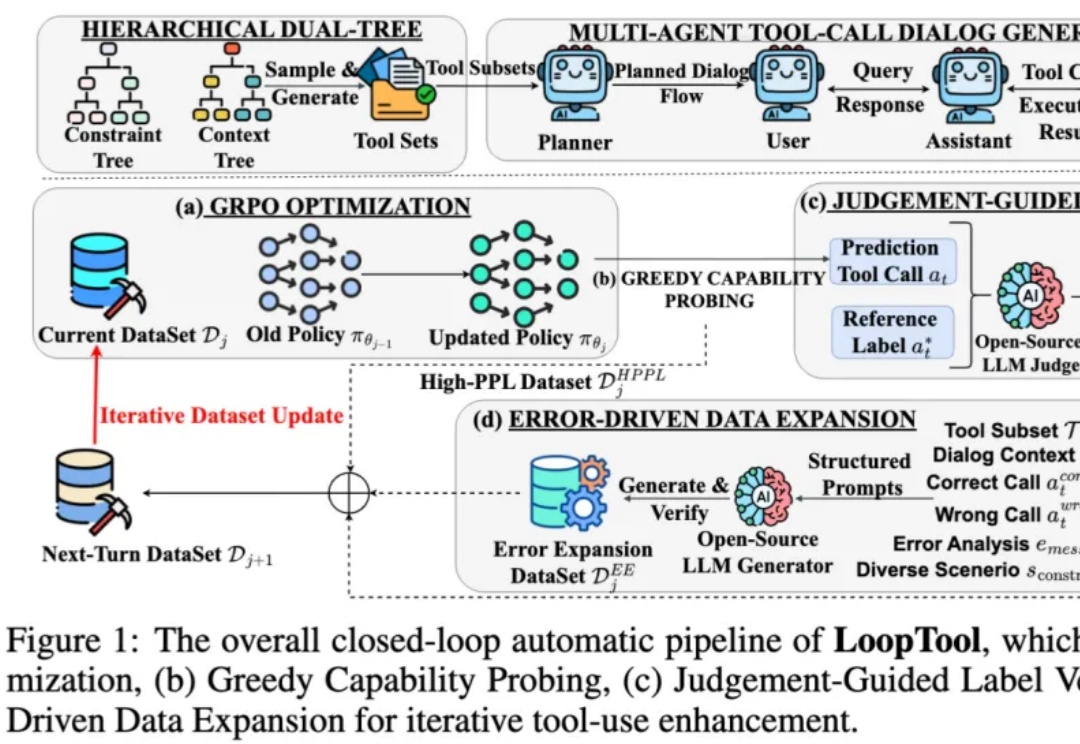

在过去两年,大语言模型 (LLM) + 外部工具的能力,已成为推动 AI 从 “会说” 走向 “会做” 的关键机制 —— 尤其在 API 调用、多轮任务规划、知识检索、代码执行等场景中,大模型要想精准调用工具,不仅要求模型本身具备推理能力,还需要借助海量高质量、针对性强的函数调用训练数据。

如果一个AI,像人类一样看屏幕、敲键鼠、自己练级变强,这种游戏搭子,你愿意拥有吗?可能不久将来,类似王者荣耀、DOTA 2这样的游戏就可以选择和AI组队,而不是和人组队了!

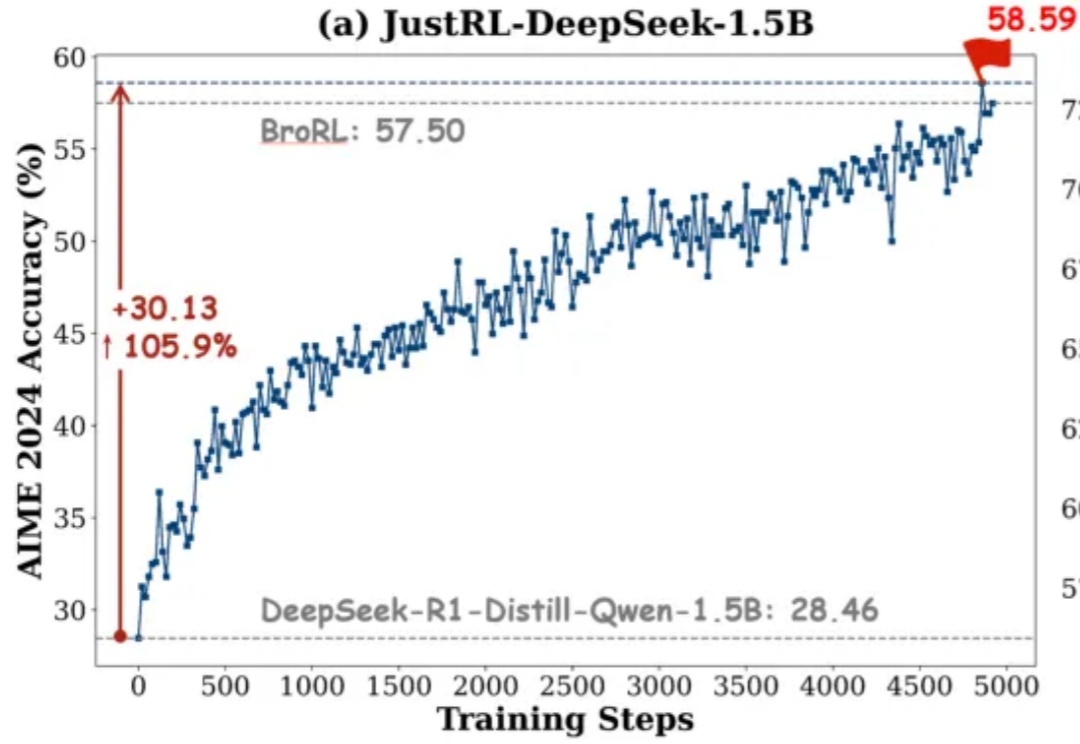

如果有人告诉你:不用分阶段做强化学习、不搞课程学习、不动态调参,只用最基础的 RL 配方就能达到小模型数学推理能力 SOTA,你信吗?

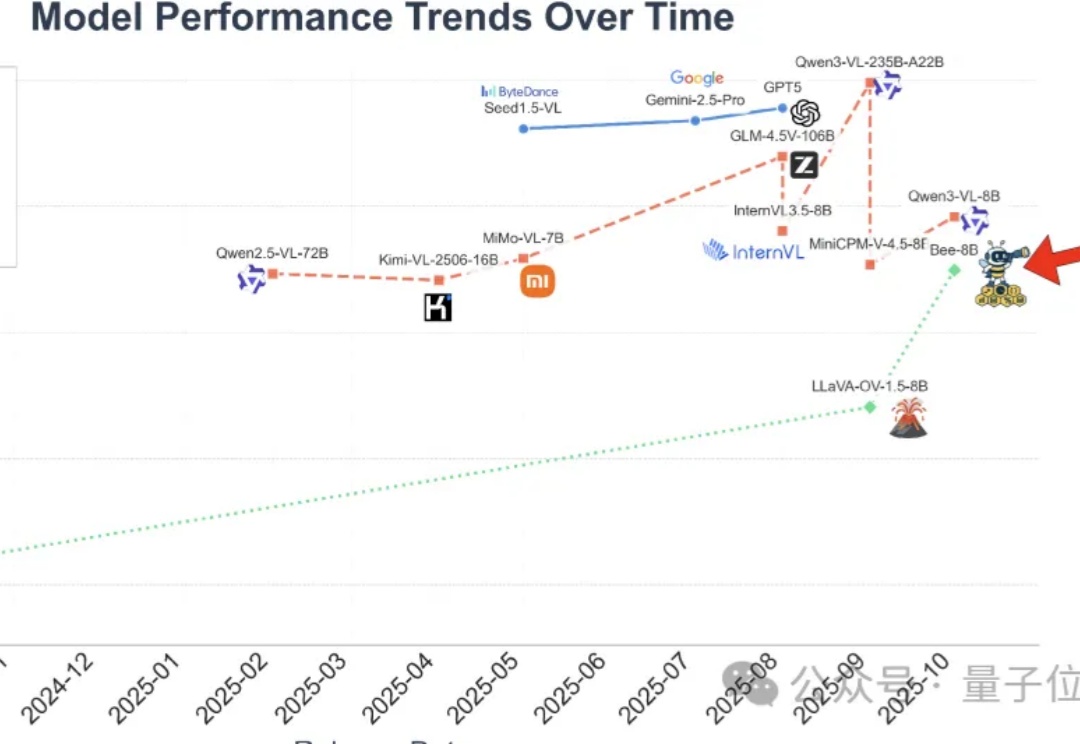

全开源多模态大模型(MLLM)的性能,长期被闭源和半开源模型“卡脖子”。

这周一,一张神秘海报在科技圈引发热议。