GLM-5深夜官宣:Pony Alpha身份揭晓,编程能力逼近Claude Opus

GLM-5深夜官宣:Pony Alpha身份揭晓,编程能力逼近Claude Opus2月11日深夜,智谱AI官宣新一代旗舰大模型GLM-5。之前在OpenRouter上神秘出现的"Pony Alpha",身份终于揭晓。据DoNews报道:Pony Alpha就是GLM-5的低调测试版。

2月11日深夜,智谱AI官宣新一代旗舰大模型GLM-5。之前在OpenRouter上神秘出现的"Pony Alpha",身份终于揭晓。据DoNews报道:Pony Alpha就是GLM-5的低调测试版。

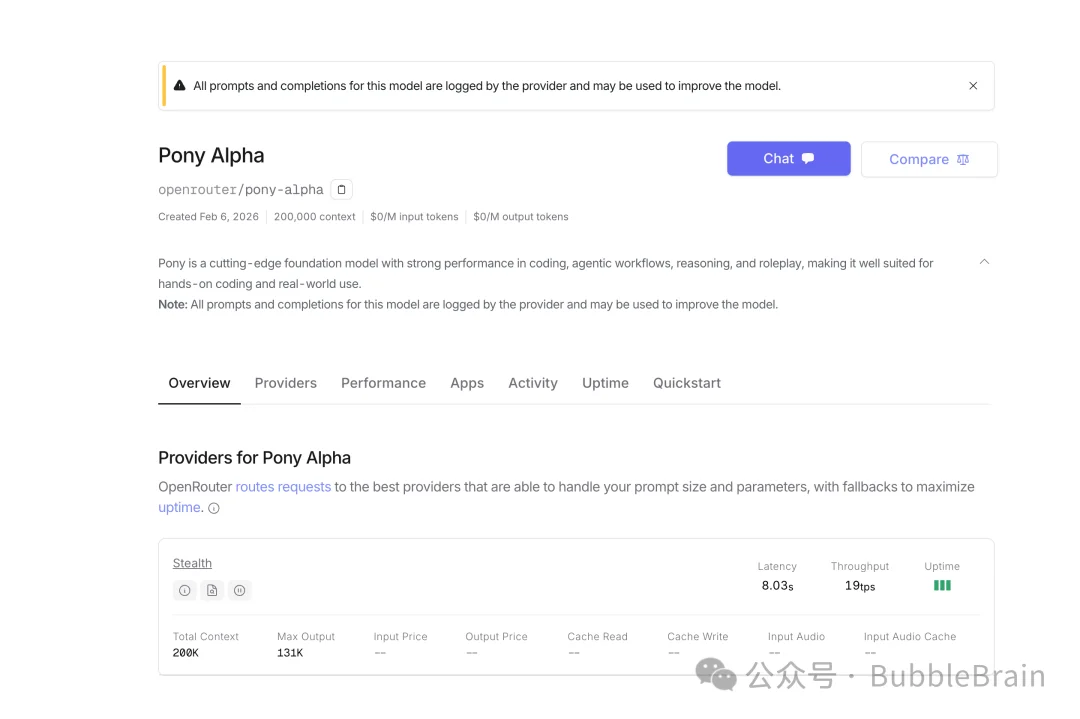

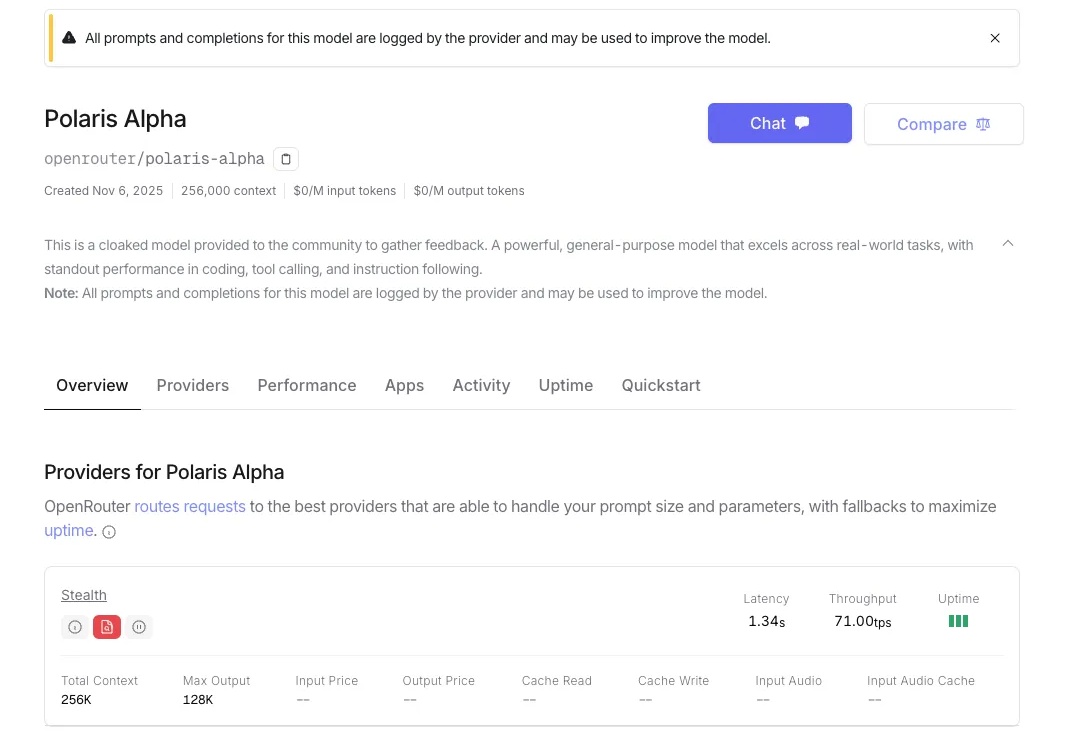

这周真的特别期待,应该可以看到各路厂商神仙打架。这股战火,从周末就开始了。 除了字节发布的Seedance2.0以外,还有个神秘的模型Pony Alpha 也上线到OpenRouter了,已经看到很多网友们纷纷猜测到底是谁家的模型。

外网都在好奇: 全球模型服务平台 OpenRouter 上这个搜索第一的神秘模型是哪家的? 这个匿名模型叫做「Pony Alpha」。根据 OpenRouter 官方的说法,它是新一代的通用大模型,在编程、逻辑推理和角色扮演方面表现突出,并针对 Agent 工作流进行了优化,具有极高的工具调用准确率。

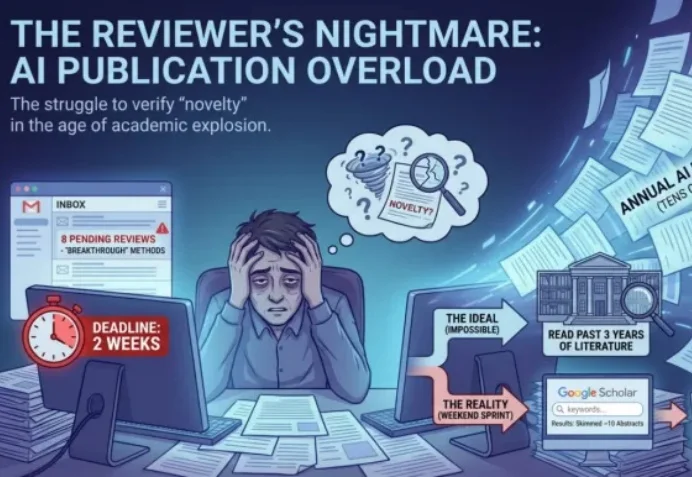

ICLR 2026 的 Rebuttal 结束了。当 OpenReview 上的喧嚣散去,我们发现,作者与审稿人之间漫长的拉锯战,最终往往只剩下一个核心分歧:「这个想法,以前真的没人做过吗?」

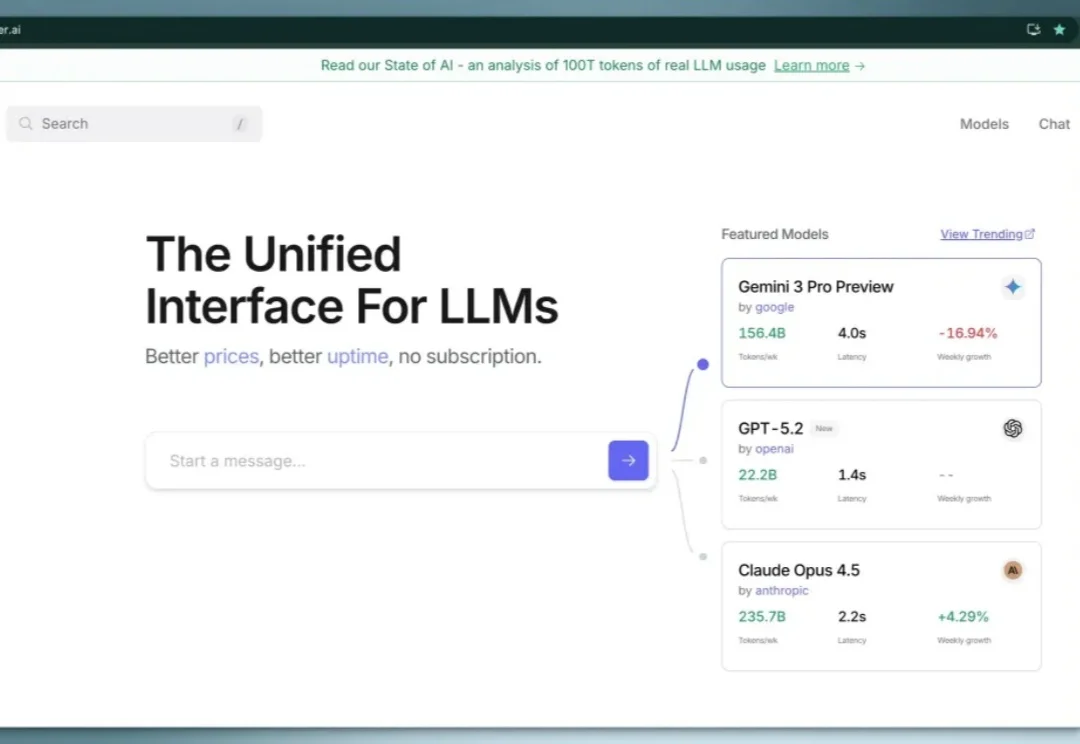

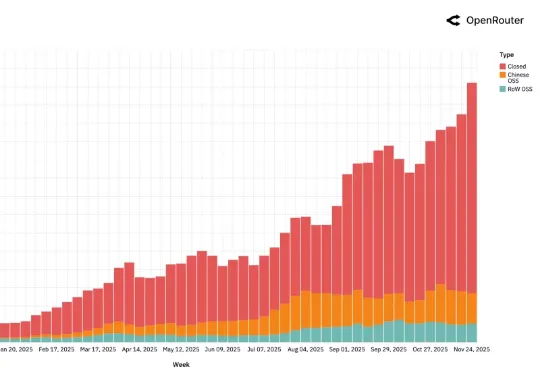

之前我在这篇文章(超全面免费 AI API 分享!零成本开启你的AI之旅!)中介绍过 OpenRouter 这个大模型 API 聚合平台,最近他们通过分析了100 万亿 token用户真实数据,发布了一篇研究报告,反应了真实用户的大模型使用现状。100 万亿 token 是什么概念呢?是人类所有文字资料的好几倍,这个数据量非常有说服力。

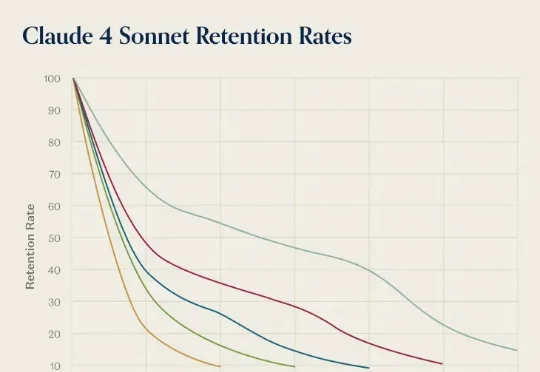

前几天,AI 推理服务供应商 OpenRouter 发布了一份报告《State of AI》,基于平台上 60 多家提供商的 300 多个模型,100 万亿个 token 的交互数据,对 LLM 的实际应用情况进行了分析。报告中,提到了一个「灰姑娘水晶鞋效应」,特别有意思。研究者在分析用户留用数据时发现一个现象:AI 模型发布第一个月进来的用户,往往比后来进来的用户留存率更高。

AI 领域迄今最大规模的用户行为实录,刚刚发布了。这是全球模型聚合平台 OpenRouter 联合硅谷顶级风投 a16z 发布的一份报告,基于全球 100 万亿次真实 API 调用、覆盖 300+款 AI 模型、60+家供应商、超过 50% 非美国用户 。

2025 年 12 月,硅谷风险投资机构 Andreessen Horowitz(简称 a16z)与 AI 推理服务平台 OpenRouter 联合发布了一份名为《State of AI》的研究报告。这份报告基于 OpenRouter 平台上超过 100 万亿 token 的真实用户交互数据,试图呈现过去一年间大语言模型在实际应用中的真实状态。

机器之心报道 编辑:+0、陈陈 最近,学术圈的大瓜莫过于 ICLR 评审大开盒事件了,只要在浏览器上输入某个网址,自行替换你要看的 paper ID 和审稿人编号,你就可以找到对应的审稿人身份。你甚至

Gemini 3 还没影子,GPT 5.1 已经在路上。7 号深夜,OpenRouter 平台上线了一个全新的隐名模型。已经有眼尖动作快的网友尝鲜体验,并且认为这就是披着马甲的 GPT 5.1,暂名:Polaris Alpha。