不止 Sora2!拍我AI V5.5 更新:人人都能用 AI 视频当导演了

不止 Sora2!拍我AI V5.5 更新:人人都能用 AI 视频当导演了2025 年,AI 视频又把桌子掀了。手切金属、小猫做饭,甚至是那个火遍全网的「奥特曼宇宙」,对 AI 来说不过是几句 Prompt 的功夫。

2025 年,AI 视频又把桌子掀了。手切金属、小猫做饭,甚至是那个火遍全网的「奥特曼宇宙」,对 AI 来说不过是几句 Prompt 的功夫。

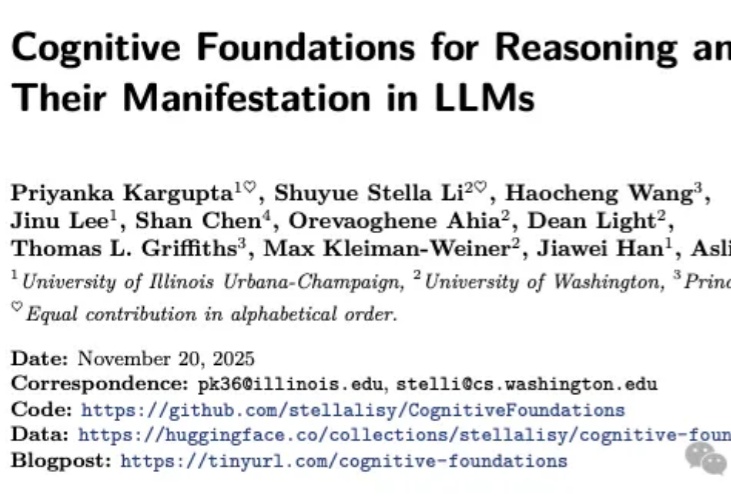

如果告诉你,仅仅改变提示词(Prompt)的结构,就能让大模型在复杂推理任务上的表现暴涨 60%,你相信吗?

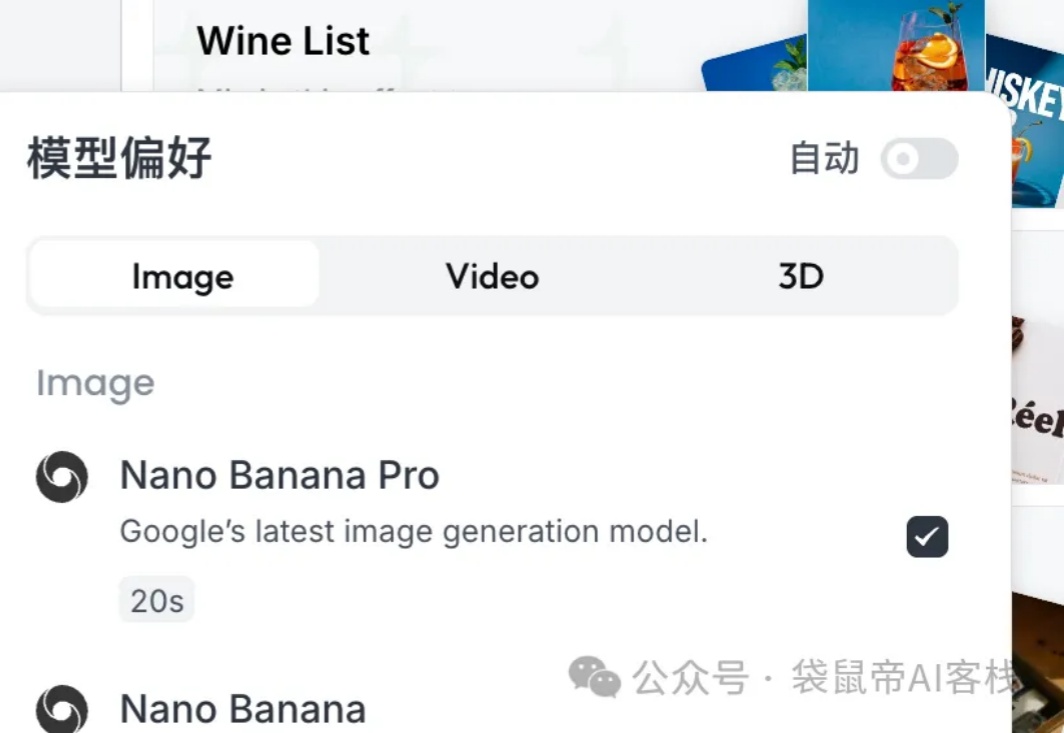

预告了很久,Google终于把他们蓄势已久的NanoBanana2给放出来了。

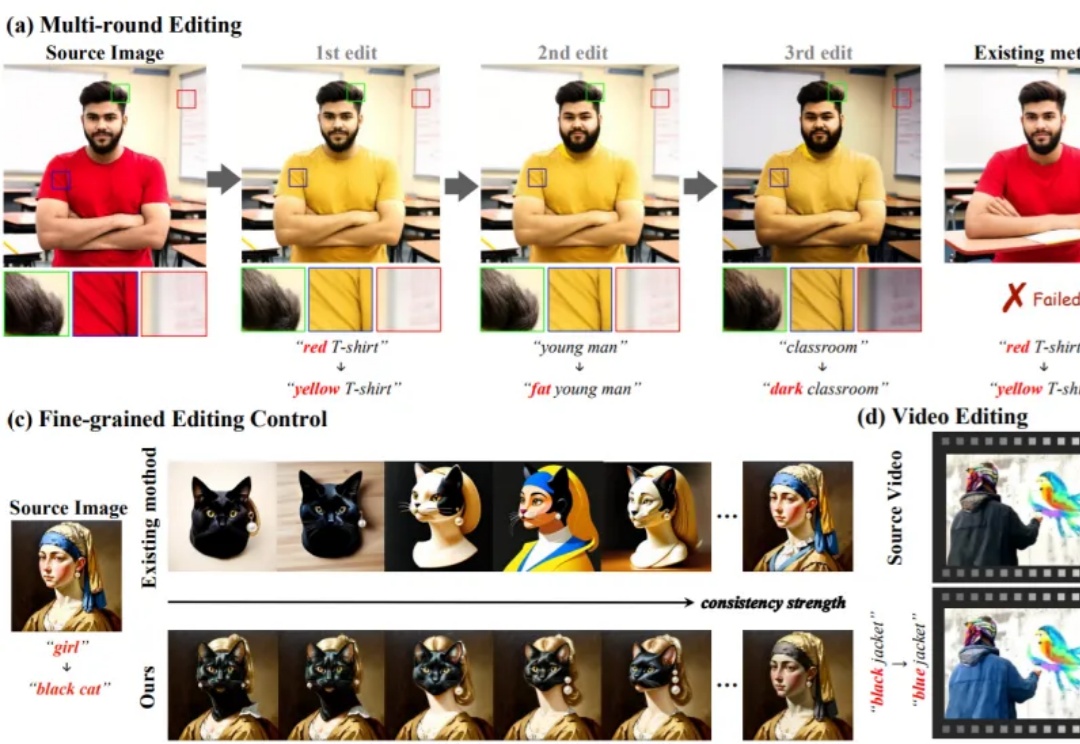

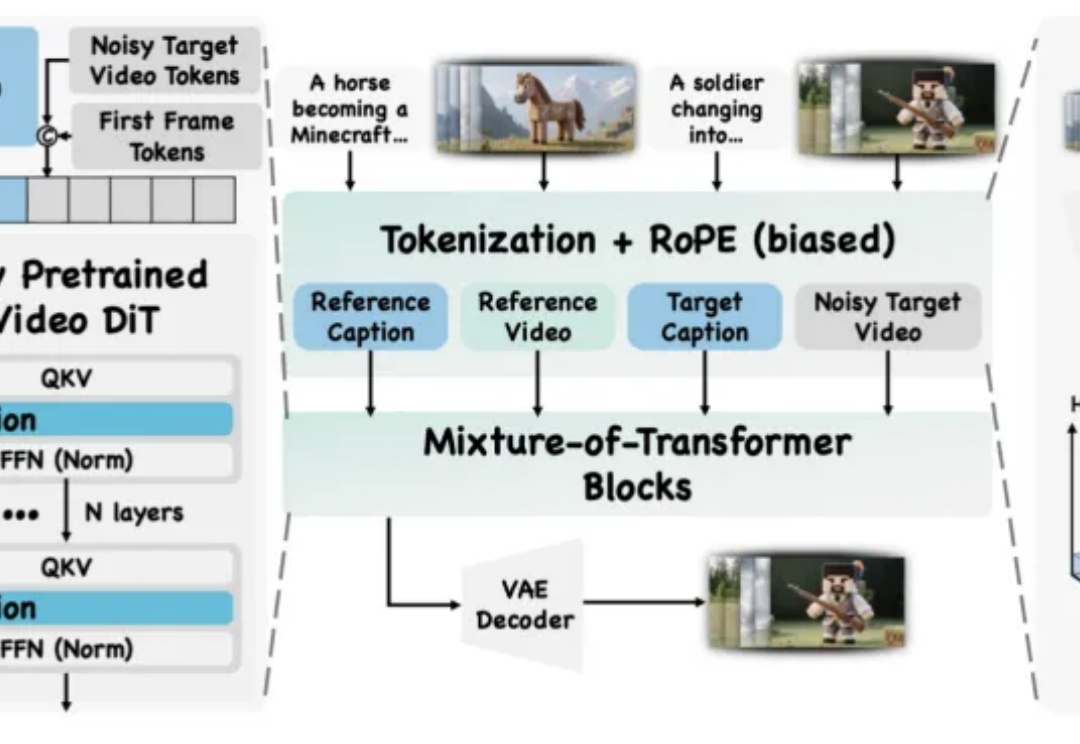

无需额外训练即可适配预训练生成模型的编辑方法,凭借灵活、高效的特性,已成为视觉生成领域的研究热点。这类方法通过操控 Attention 机制(如 Prompt-to-Prompt、MasaCtrl)实现文本引导编辑,但当前技术存在两大核心痛点,严重限制其在复杂场景的应用

视频创作中,你是否曾希望复刻变成 Labubu 的特效,重现吉卜力风格化,跳出短视频平台爆火的同款舞蹈,或模仿复杂有趣的希区柯克运镜?

半夜 3 点,你跟 AI 苦战许久,横跳在 ChatGPT、Claude、Gemini 等各个平台,辗转反侧。

大型语言模型(LLMs)正迅速成为从金融到交通等各个专业领域不可或缺的辅助决策工具。但目前LLM的“通用智能”在面对高度专业化、高风险的任务时,往往显得力不从心。

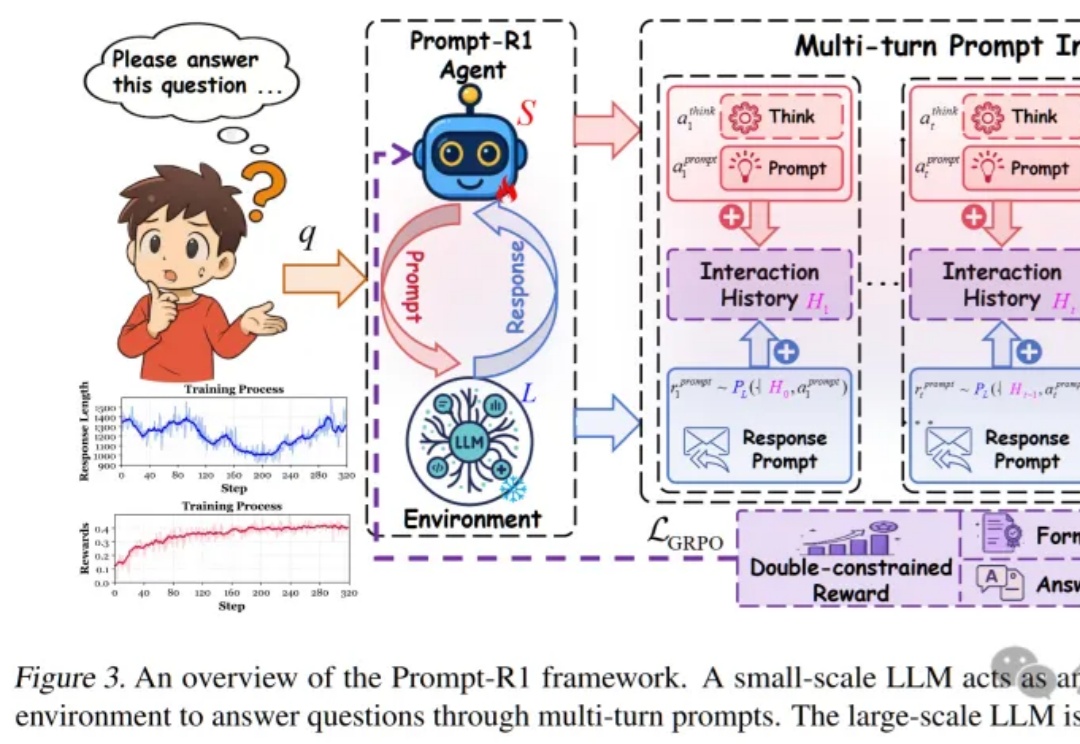

这篇论文提出了一种颠覆性的协作模式,即通过强化学习训练一个“小模型”作为智能代理(Agent),让它自动学会如何写出完美的Prompt,一步步引导任何一个“大模型”完成复杂推理,实现了真正的“AI指挥AI”。

十月,《纽约时报》发表了题为《The A.I. Prompt That Could End the World》(《那个可能终结世界的 AI 提示词》)的文章。作者 Stephen Witt 采访了多位业内人士:有 AI 先驱,图灵奖获奖者 Yoshua Bengio;以越狱测试著称的 Leonard Tang;以及专门研究模型欺骗的 Marius Hobbhahn。

近日刚好得了空闲,在研读 Anthropic 官方技术博客和一些相关论文,主题是「Agent 与 Context 工程」。2025 年 6 月以来,原名为「Prompt Engineering」的提示词工程,在 AI Agent 概念日趋火热的应用潮中,