CES 2025:井喷的AI陪伴与AI眼镜

CES 2025:井喷的AI陪伴与AI眼镜一年一度的科技贸易展国际消费电子展 (CES) 2025年1月7日至10日在拉斯维加斯举行,预计将有超过4500家参展商,其中包括1400家初创公司。

来自主题: AI资讯

9506 点击 2025-01-08 10:07

一年一度的科技贸易展国际消费电子展 (CES) 2025年1月7日至10日在拉斯维加斯举行,预计将有超过4500家参展商,其中包括1400家初创公司。

自从 Chatgpt 诞生以来,LLM(大语言模型)的参数量似乎就成为了各个公司的竞赛指标。GPT-1 参数量为 1.17 亿(1.17M),而它的第四代 GPT-4 参数量已经刷新到了 1.8 万亿(1800B)。

当一个机器人有了名字、有了主人,一切都会变得不一样。 我拿到下面这个小玩意的时候,它告诉了我它的名字叫做Ropet,它的主人是谁,它说着它肚子饿要吃饭。

流行梗随风而过,TV Tropes 永垂不朽。

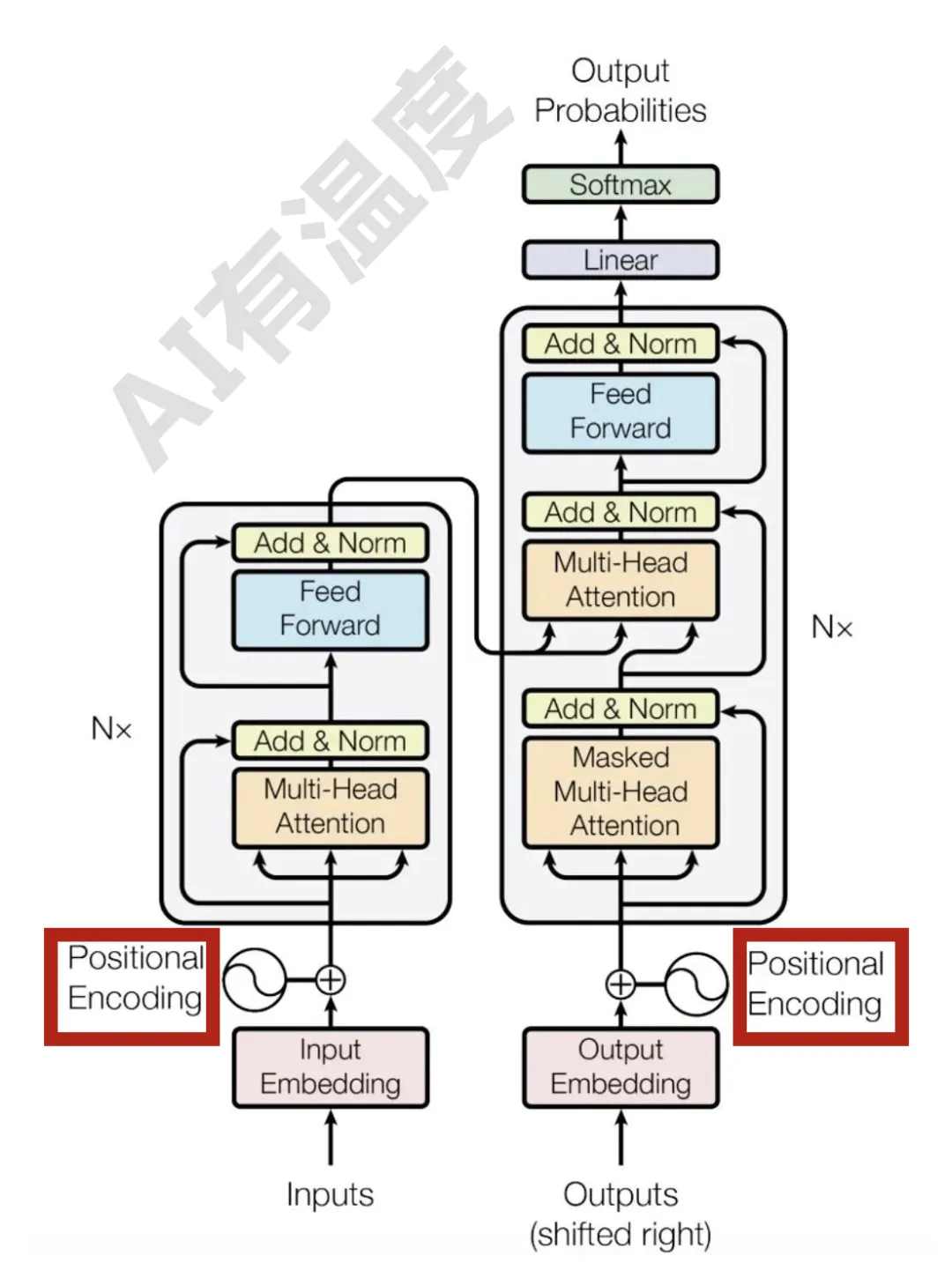

RNN每个step的隐状态都取决于上一个step的输出,这种连续的状态转移方式使得RNN天然带有位置信息。

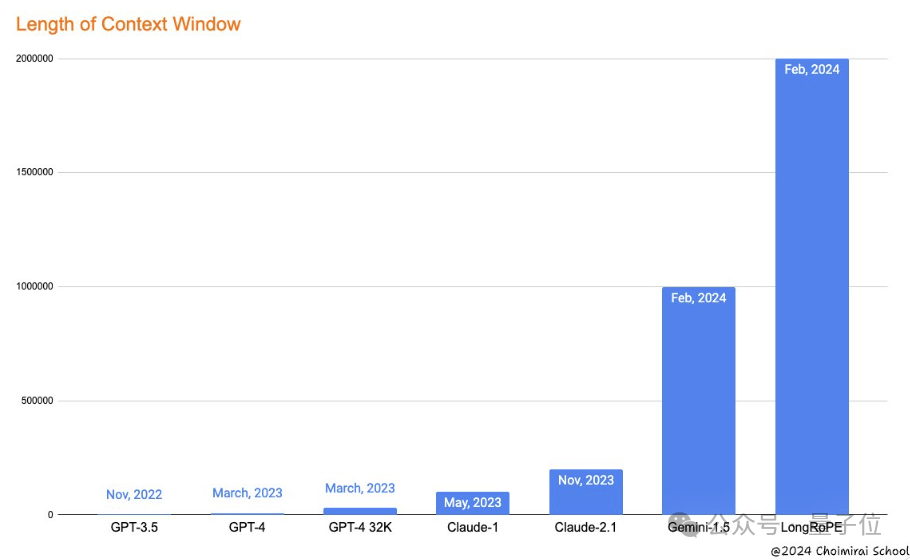

大型语言模型(LLM)往往会追求更长的「上下文窗口」,但由于微调成本高、长文本稀缺以及新token位置引入的灾难值(catastrophic values)等问题,目前模型的上下文窗口大多不超过128k个token

谷歌刚刷新大模型上下文窗口长度记录,发布支持100万token的Gemini 1.5,微软就来砸场子了。