400万token上下文、推理再加速46%!最新开源方案升级MIT成果,推理成本再降低

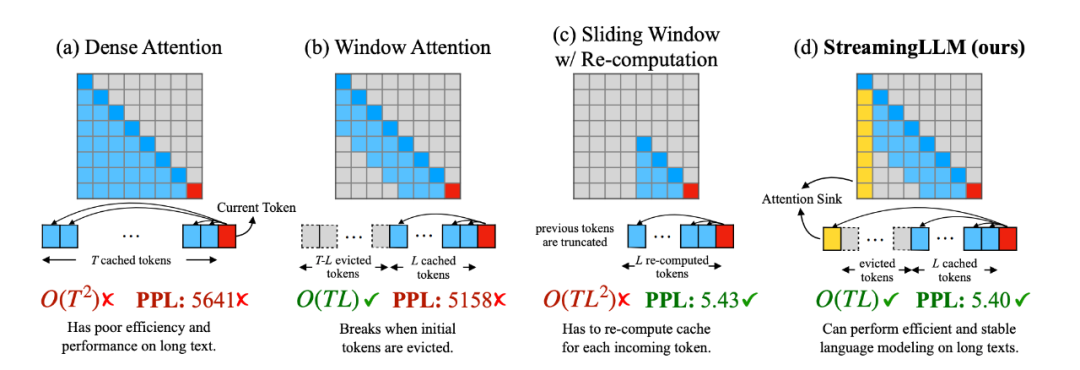

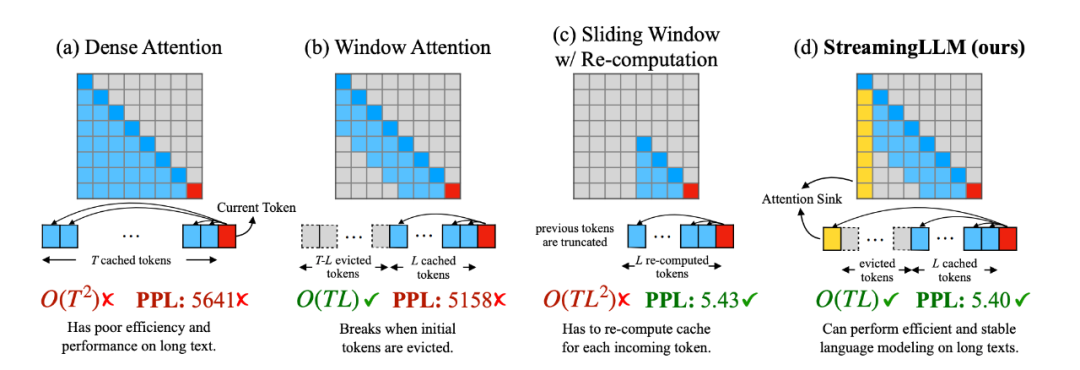

400万token上下文、推理再加速46%!最新开源方案升级MIT成果,推理成本再降低22倍加速还不够,再来提升46%,而且方法直接开源!这就是开源社区改进MIT爆火项目StreamingLLM的最新成果。

来自主题: AI资讯

8339 点击 2024-01-08 14:44

22倍加速还不够,再来提升46%,而且方法直接开源!这就是开源社区改进MIT爆火项目StreamingLLM的最新成果。

大模型推理再次跃升一个新台阶!最近,全新开源的国产SwiftInfer方案,不仅能让LLM处理无限流式输入,而且还将推理性能提升了46%。