从 Manus、Genspark 到 Lovart、ListenHub、Medeo:一张图谱看懂华人 Agent 浪潮

从 Manus、Genspark 到 Lovart、ListenHub、Medeo:一张图谱看懂华人 Agent 浪潮如果用一句话为 2025 年写下注脚,那它不会是某个技术名词,而更像是一种哲学上的转变:“这一年,我们不再是孤立地使用软件,而是与智能的代理人(Agent)共舞,它们正悄然重塑我们的工作与生活。”

如果用一句话为 2025 年写下注脚,那它不会是某个技术名词,而更像是一种哲学上的转变:“这一年,我们不再是孤立地使用软件,而是与智能的代理人(Agent)共舞,它们正悄然重塑我们的工作与生活。”

今天橘子的新产品可以一分钟将任何内容变成播客的 ListenHub发布了,照例想用提示词为他做一张长图。

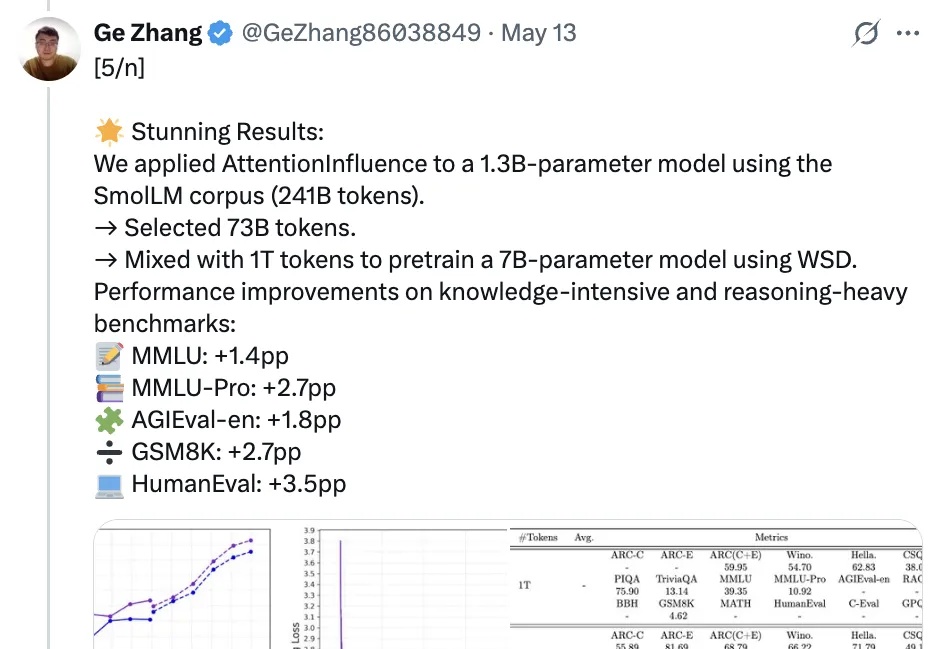

和人工标记数据说拜拜,利用预训练语言模型中的注意力机制就能选择可激发推理能力的训练数据!

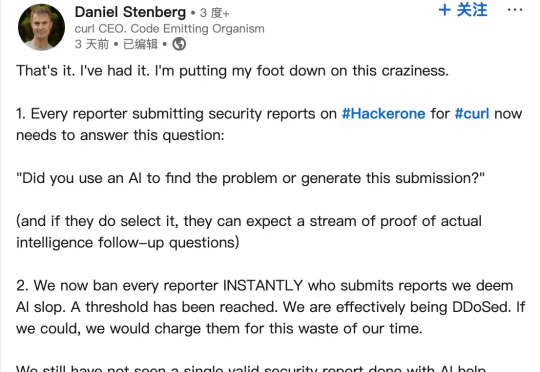

近日,curl 项目(一款用于通过 URL 传输数据的命令行工具和库)创始人 Daniel Stenberg 在领英发帖称,已经受够了由 AI 生成的大量“垃圾”漏洞报告,因此近期引入额外复选框,用以过滤此类平白浪费维护人员时间的低效提交内容。

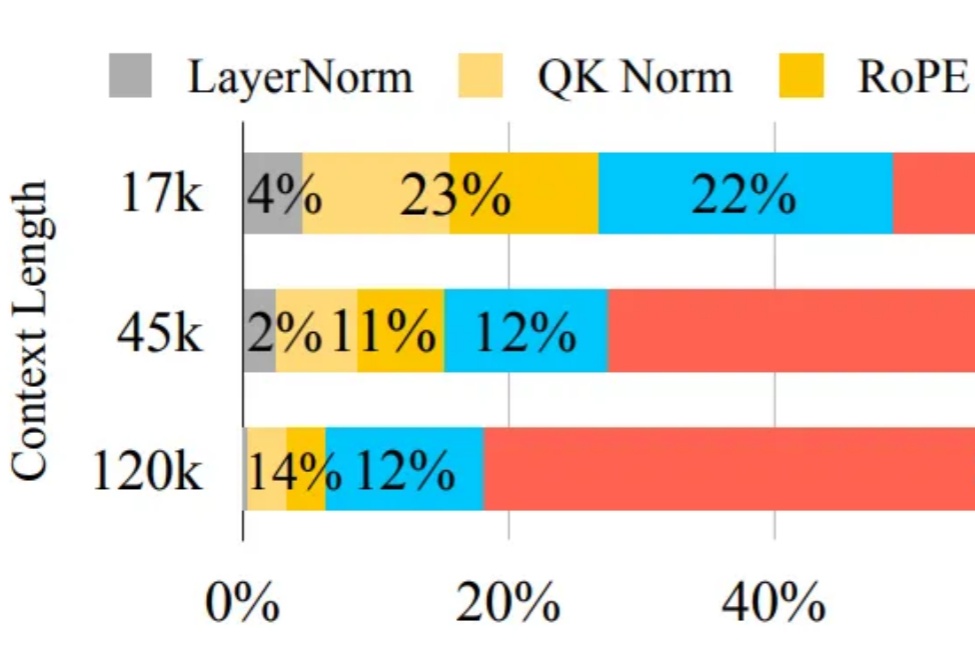

自 OpenAI 发布 Sora 以来,AI 视频生成技术进入快速爆发阶段。凭借扩散模型强大的生成能力,我们已经可以看到接近现实的视频生成效果。但在模型逼真度不断提升的同时,速度瓶颈却成为横亘在大规模应用道路上的最大障碍。

知名 Go 大佬 Thorsten Ball 最近用 315 行代码构建了一个编程智能体,并表示「它运行得非常好」且「没有护城河」(指它并非难以复制)。

在全球大模型快速爆发与AIGC应用加速落地的时代,中国的人工智能创业者也在经历从“算法至上”到“产品为王”的重大转变。过去十年,AI行业几度热潮:从2016年AlphaGo引爆的认知革命,到2022年ChatGPT带来的生成式AI浪潮,技术的跃迁正在倒逼产品逻辑重构。而真正决定一家AI公司能否走得远的,从来不是技术demo,而是“有没有真正被用起来”。

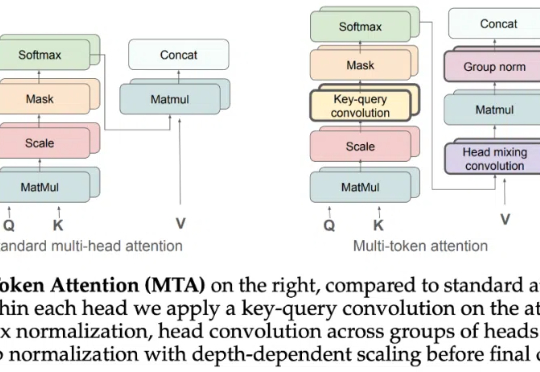

「未来,99% 的 attention 将是大模型 attention,而不是人类 attention。」这是 AI 大牛 Andrej Karpathy 前段时间的一个预言。这里的「attention」可以理解为对内容的需求、处理和分析。也就是说,他预测未来绝大多数资料的处理工作将由大模型来完成,而不是人类。

Attention 还在卷自己。

晚点:过去将近 6 个月,AI 领域最重要的两件事,一是 OpenAI 去年 9 月 o1 发布,另一个是近期 DeepSeek 在发布 R1 后掀起全民狂潮。我们可以从这两个事儿开始聊。你怎么看 o1 和 R1 分别的意义?