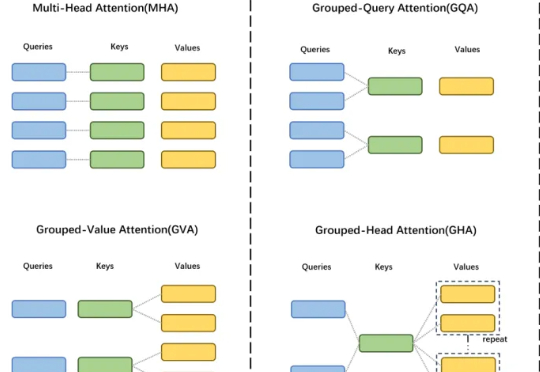

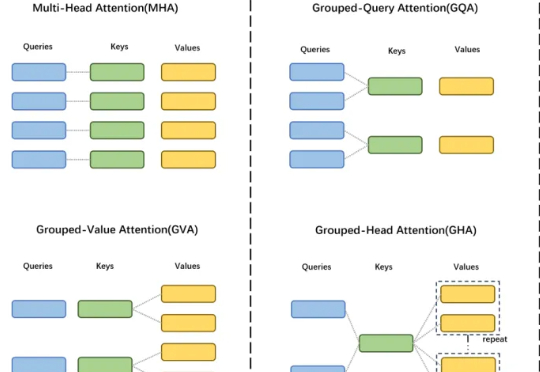

重塑注意力机制:GTA登场,KV缓存缩减70%、计算量削减62.5%

重塑注意力机制:GTA登场,KV缓存缩减70%、计算量削减62.5%GTA 工作由中国科学院自动化研究所、伦敦大学学院及香港科技大学(广州)联合研发,提出了一种高效的大模型框架,显著提升模型性能与计算效率。

GTA 工作由中国科学院自动化研究所、伦敦大学学院及香港科技大学(广州)联合研发,提出了一种高效的大模型框架,显著提升模型性能与计算效率。

不经意间,这场燃烧了三年的AI热潮,已经悄然改变了我们的生活方式。我们开始习惯用AI写作、咨询,向它提出各种问题,搜索引擎的使用频率也在减少。这场改变世界的技术革命,正让那些有想法却不会写代码的普通用户,第一次有机会接触代码世界,体验创造产品的“酷”感。 Same.new正是这样一款AI开发利器。

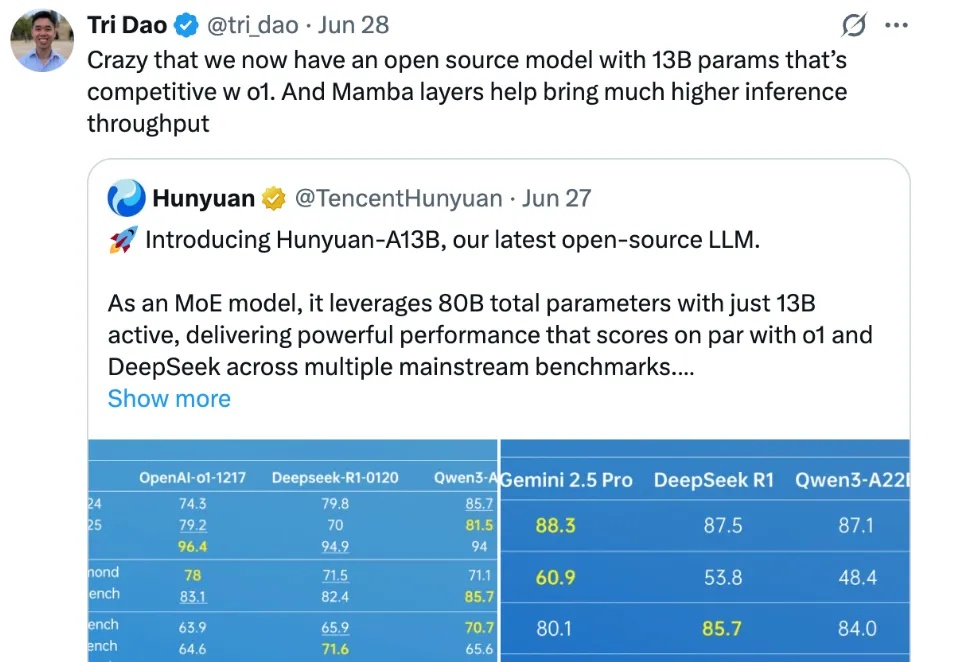

腾讯混元,在开源社区打出名气了。

DeepSeek火爆全球,现在美国版“梁文锋”来了。来自美国的互联网券商巨头Robinhood的CEO——Vlad Tenev决定投身人工智能创业浪潮,与Tudor Achim联合打造了一家专注于人工智能的初创公司——Harmonic AI。

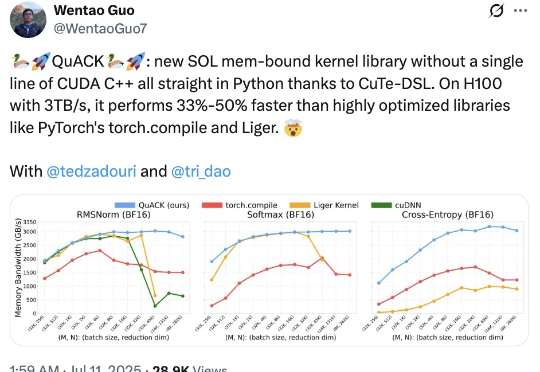

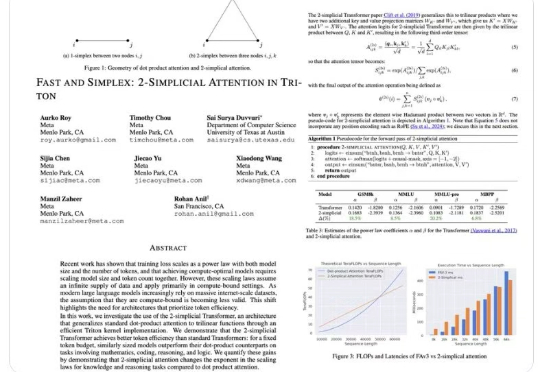

无需CUDA代码,给H100加速33%-50%! Flash Attention、Mamba作者之一Tri Dao的新作火了。

Listen Labs 由两位哈佛校友 Florian Juengermann 与 Alfred Wahlforss 在 2024 年底联合创立,并在 2025 年 4 月连获 Sequoia 领投的种子轮与 A 轮合计 2700 万美元融资,目标是打造一套能自动招募受访者、主持上千场多语访谈、即时归档并复用洞察的“AI 用户研究员”体系。

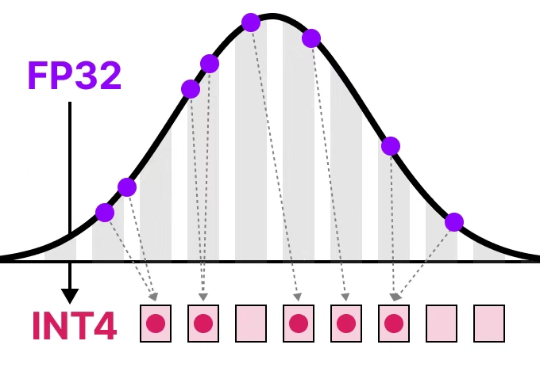

清华大学朱军教授团队提出SageAttention3,利用FP4量化实现推理加速,比FlashAttention快5倍,同时探索了8比特注意力用于训练任务的可行性,在微调中实现了无损性能。

“上线 4 个月,DAU 破百万,累计用户破千万,用户日均对话次数超 9 次,跻身国内同类产品第一梯队 ——元石科技的‘问小白’用生成式推荐重新定义AI时代的信息获取与消费。

2017 年,一篇《Attention Is All You Need》论文成为 AI 发展的一个重要分水岭,其中提出的 Transformer 依然是现今主流语言模型的基础范式。尤其是在基于 Transformer 的语言模型的 Scaling Law 得到实验验证后,AI 领域的发展更是进入了快车道。

“在百川智能的那段时间,我和同事们始终处在一种很亢奋的状态。尽管我们常常工作到深夜,甚至一两点钟才下班,但内心非常地充实和开心。”如今回忆起那段经历时,前百川工具链负责人徐文健的眼中依然有光。