刚刚,谷歌「IMO金牌」模型上线Gemini,数学家第一时间证明猜想

刚刚,谷歌「IMO金牌」模型上线Gemini,数学家第一时间证明猜想网友:Deep Think 简直太疯狂了。本周五,谷歌宣布向 Google AI Ultra 订阅用户推出 Deep Think 功能,并将全版本的 Gemini 2.5 Deep Think 模型(用于 IMO 竞赛)提供给部分数学家使用。

网友:Deep Think 简直太疯狂了。本周五,谷歌宣布向 Google AI Ultra 订阅用户推出 Deep Think 功能,并将全版本的 Gemini 2.5 Deep Think 模型(用于 IMO 竞赛)提供给部分数学家使用。

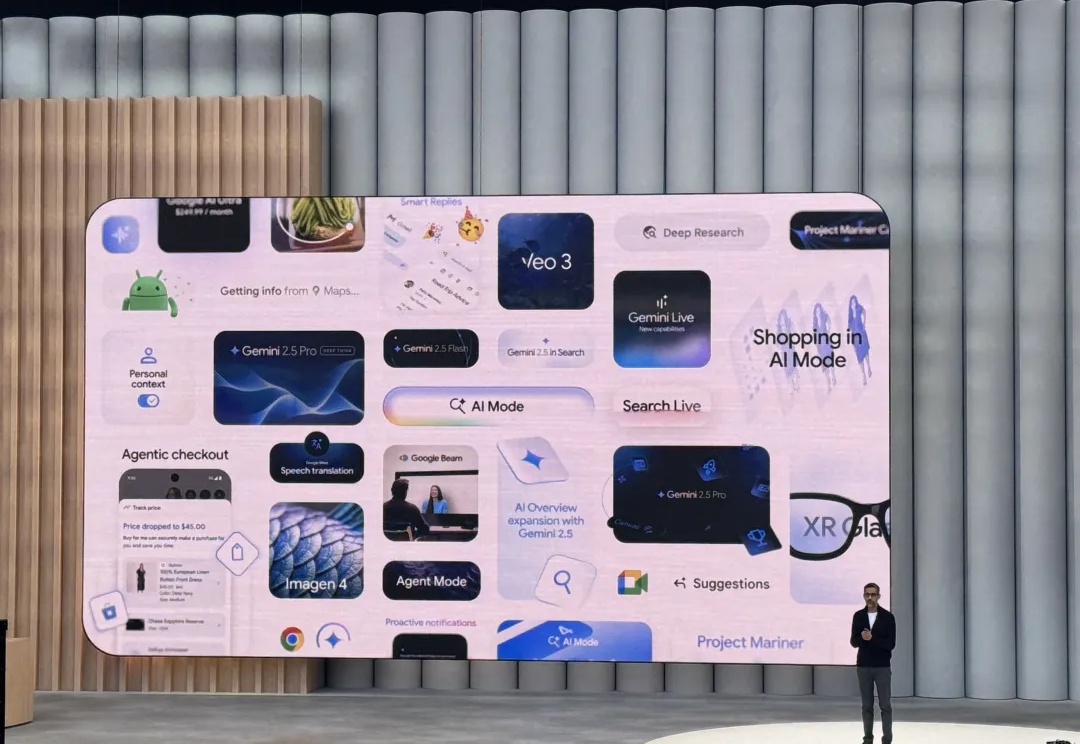

昨夜,谷歌宣布向 Google AI Ultra 订阅用户推出 Deep Think 功能,Gemini 2.5 Deep Think 模型在今年的国际数学奥林匹克竞赛 (IMO) 上夺得金牌。

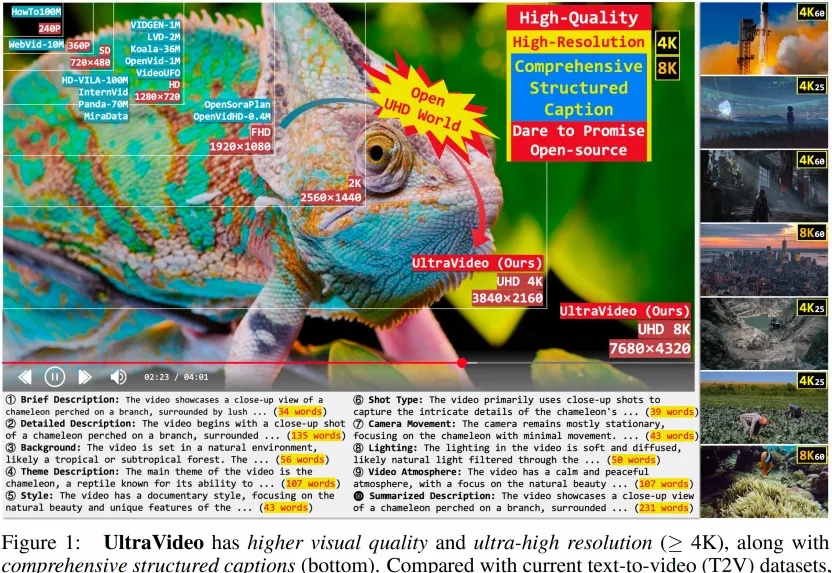

为什么AI生成的视频总是模糊卡顿?为什么细节纹理经不起放大?为什么动作描述总与画面错位?

谷歌把最新的文生图模型 Imagen 4,以及它的 Pro Max 版 Imagen 4 Ultra,放到了 AI Studio 和 API 里。

现在,请大家一起数一下“1”、“2”。OK,短短2秒钟时间,一个准万亿MoE大模型就已经吃透如何解一道高等数学大题了!而且啊,这个大模型还是不用GPU来训练,全流程都是大写的“国产”的那种。

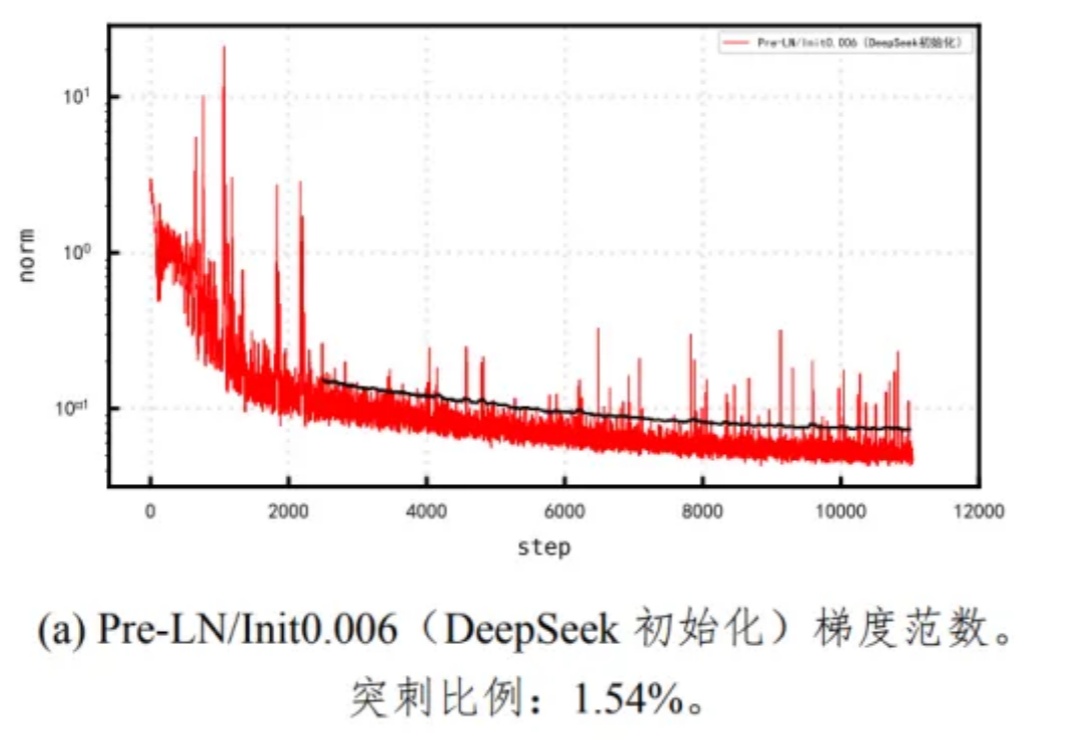

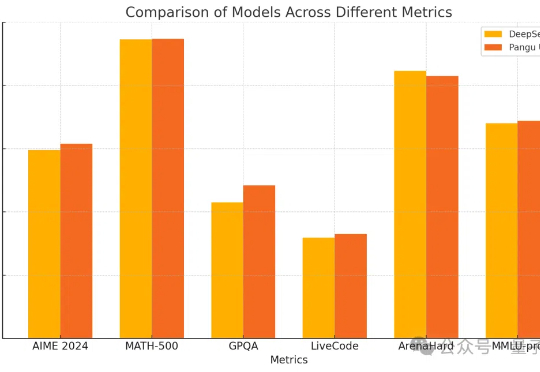

Pangu Ultra MoE 是一个全流程在昇腾 NPU 上训练的准万亿 MoE 模型,此前发布了英文技术报告[1]。最近华为盘古团队发布了 Pangu Ultra MoE 模型架构与训练方法的中文技术报告,进一步披露了这个模型的细节。

今年,Google算是打了个翻身仗。

来自英伟达和UIUC的华人团队提出一种高效训练方法,将LLM上下文长度从128K扩展至惊人的400万token SOTA纪录!基于Llama3.1-Instruct打造的UltraLong-8B模型,不仅在长上下文基准测试中表现卓越,还在标准任务中保持顶尖竞争力。

密集模型的推理能力也能和DeepSeek-R1掰手腕了?

终于,华为盘古大模型系列上新了,而且是昇腾原生的通用千亿级语言大模型。我们知道,如今各大科技公司纷纷发布百亿、千亿级模型。但这些大部分模型训练主要依赖英伟达的 GPU。