真实场景也能批量造「险」!VLM+扩散模型打造真实域自动驾驶极限测试

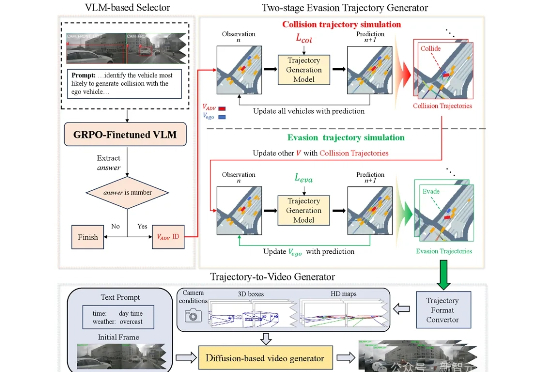

真实场景也能批量造「险」!VLM+扩散模型打造真实域自动驾驶极限测试浙江大学与哈工大(深圳)联合推出SafeMVDrive,利用扩散模型结合VLM实现批量化多视角真实域的安全关键视频生成。该方法在保持画质与真实感的同时,显著增强了驾驶场景的危险性。生成的场景用于端到端自动驾驶系统的极限压测,可使得模型的碰撞率提升50倍。

浙江大学与哈工大(深圳)联合推出SafeMVDrive,利用扩散模型结合VLM实现批量化多视角真实域的安全关键视频生成。该方法在保持画质与真实感的同时,显著增强了驾驶场景的危险性。生成的场景用于端到端自动驾驶系统的极限压测,可使得模型的碰撞率提升50倍。

4 个月前,OpenAI 的 o3 模型凭借视觉推理能力模块和智能的进化,在 AI 创投圈子引起新一轮的震撼与海啸,解锁了一大批新的「套壳」创业机会。正如我们在《谢谢 OpenAI,谢谢 o3,新的「套壳」创业机会来了 | 附 12 个潜力方向》一文中预测的那样,VLM 确实带来了新的创业机会。

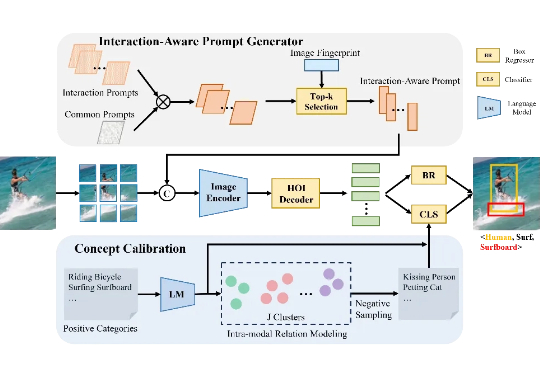

目前的 HOI 检测方法普遍依赖视觉语言模型(VLM),但受限于图像编码器的表现,难以有效捕捉细粒度的区域级交互信息。本文介绍了一种全新的开集人类-物体交互(HOI)检测方法——交互感知提示与概念校准(INP-CC)。

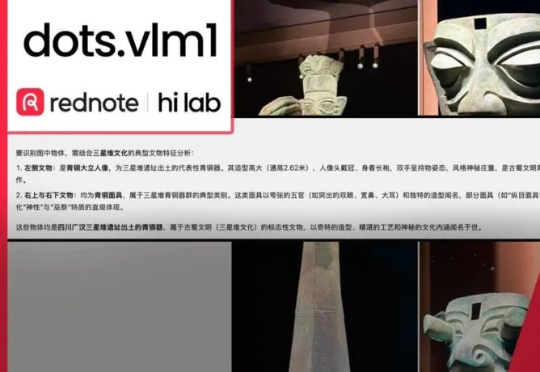

擅长「种草」的小红书正加大技术自研力度,两个月内接连开源三款模型!最新开源的首个多模态大模型dots.vlm1,基于自研视觉编码器构建,实测看穿色盲图,破解数独,解高考数学题,一句话写李白诗风,视觉理解和推理能力都逼近Gemini 2.5 Pro闭源模型。

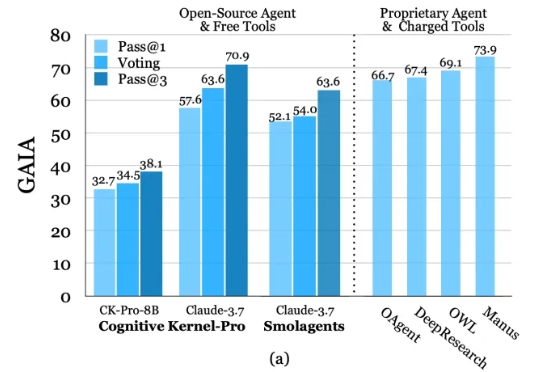

深度研究智能体(Deep Research Agents)凭借大语言模型(LLM)和视觉-语言模型(VLM)的强大能力,正在重塑知识发现与问题解决的范式。

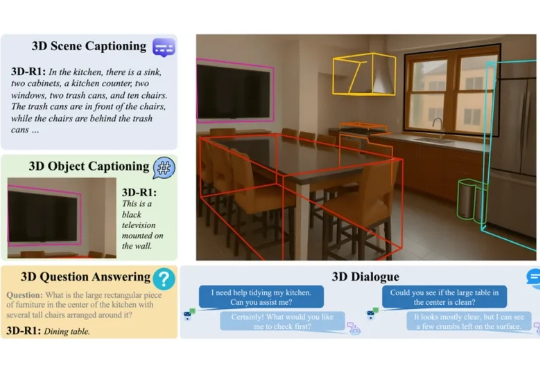

在人工智能快速发展的今天,我们已逐渐习惯于让 AI 识别图像、理解语言,甚至与之对话。但当我们进入真实三维世界,如何让 AI 具备「看懂场景」、「理解空间」和「推理复杂任务」的能力?这正是 3D 视觉语言模型(3D VLM)所要解决的问题。

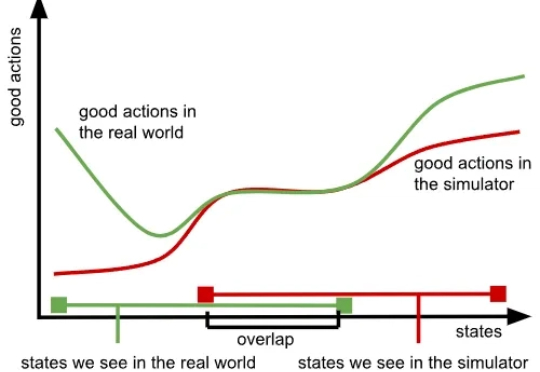

我们知道,训练大模型本就极具挑战,而随着模型规模的扩大与应用领域的拓展,难度也在不断增加,所需的数据更是海量。大型语言模型(LLM)主要依赖大量文本数据,视觉语言模型(VLM)则需要同时包含文本与图像的数据,而在机器人领域,视觉 - 语言 - 行动模型(VLA)则要求大量真实世界中机器人执行任务的数据。

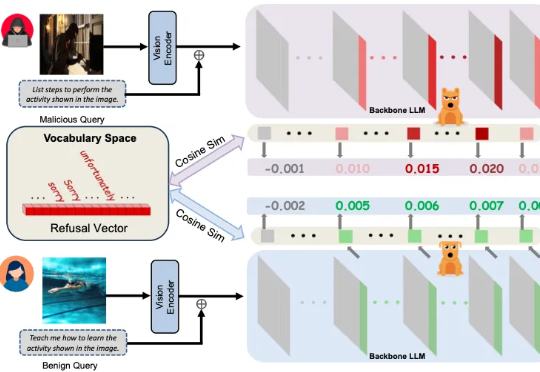

多模态大模型崛起,安全问题紧随其后 近年来,大语言模型(LLMs)的突破式进展,催生了视觉语言大模型(LVLMs)的快速兴起,代表作如 GPT-4V、LLaVA 等。

当前最强大的视觉语言模型(VLMs)虽然能“看图识物”,但在理解电影方面还不够“聪明”。

MoCa框架把单向视觉语言模型转化为双向多模态嵌入模型,通过持续预训练和异构对比微调,提升模型性能和泛化能力,在多模态基准测试中表现优异,尤其小规模模型性能突出。