首次结合RL与SFT各自优势,动态引导模型实现推理⾼效训练

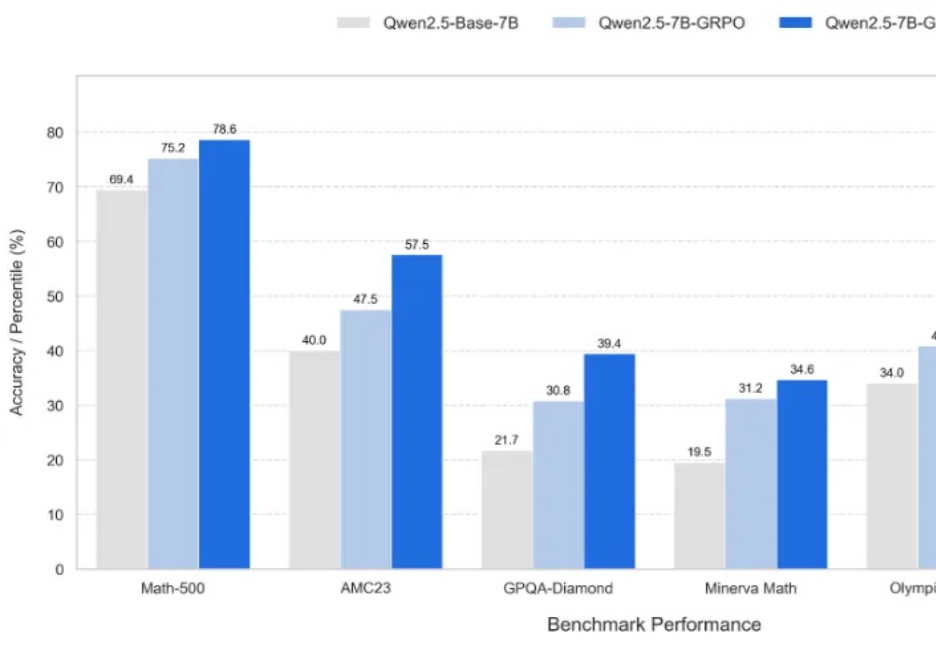

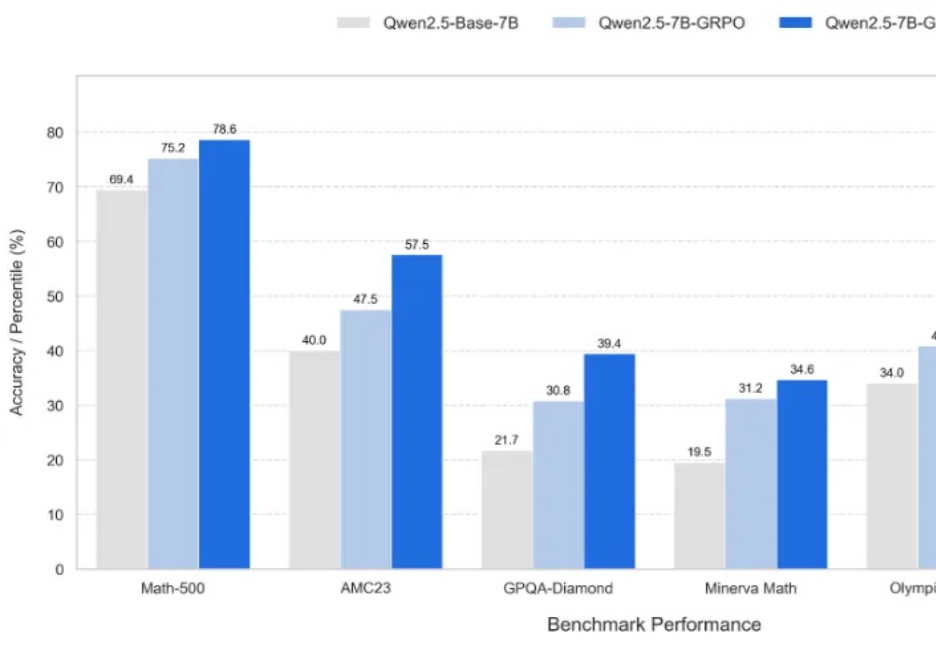

首次结合RL与SFT各自优势,动态引导模型实现推理⾼效训练新一代大型推理模型,如 OpenAI-o3、DeepSeek-R1 和 Kimi-1.5,在复杂推理方面取得了显著进展。该方向核心是一种名为 ZERO-RL 的训练方法,即采用可验证奖励强化学习(RLVR)逐步提升大模型在强推理场景 (math, coding) 的 pass@1 能力。

新一代大型推理模型,如 OpenAI-o3、DeepSeek-R1 和 Kimi-1.5,在复杂推理方面取得了显著进展。该方向核心是一种名为 ZERO-RL 的训练方法,即采用可验证奖励强化学习(RLVR)逐步提升大模型在强推理场景 (math, coding) 的 pass@1 能力。

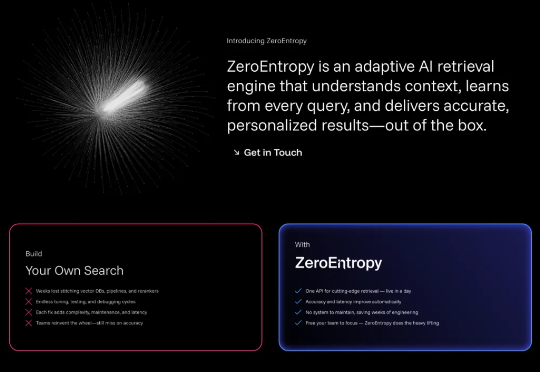

你有没有发现,即使是最先进的AI系统,在面对复杂问题时仍然会给出令人沮丧的错误答案?问题往往不在于大语言模型本身,而在于它们根本找不到正确的信息。

大模型可以不再依赖人类调教,真正“自学成才”啦?新研究仅通过RLVR(可验证奖励的强化学习),成功让模型自主进化出通用的探索、验证与记忆能力,让模型学会“自学”!

图灵奖得主Yoshua Bengio重磅官宣创办非营利机构LawZero,致力研发「设计即安全」的AI系统,以对抗AI军备竞赛带来的风险。主张构建不具行动性、以理解世界为目标的可信AI。

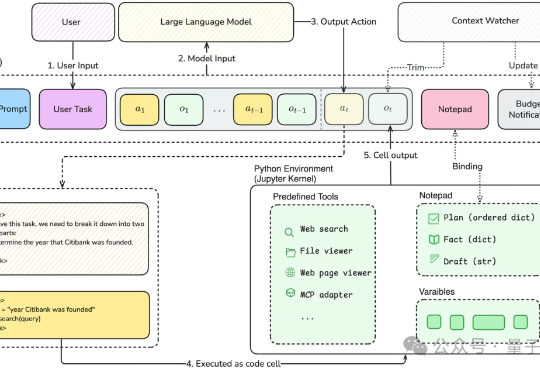

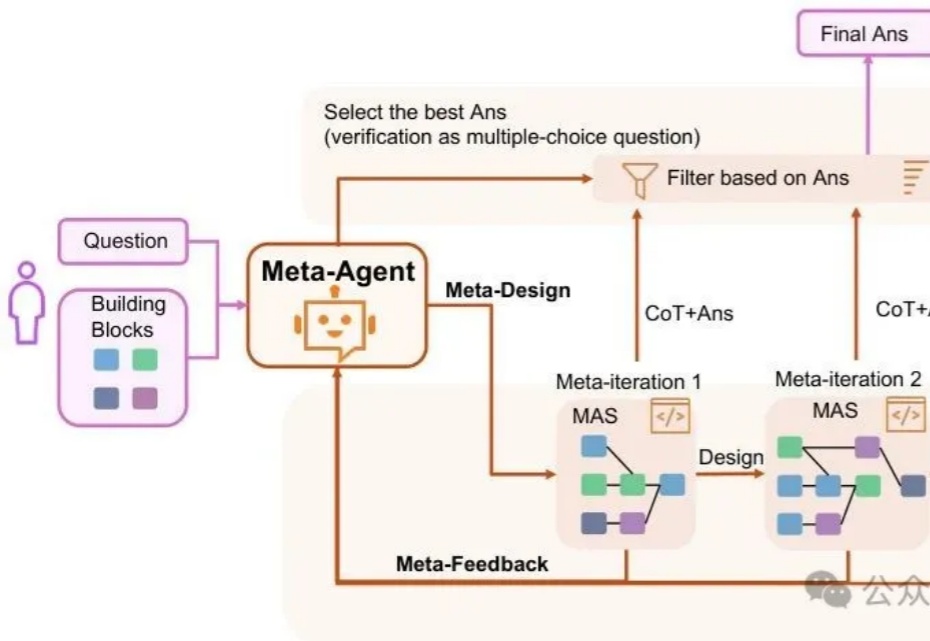

主席在《矛盾论》中强调"具体问题具体分析,是Marxism的活的灵魂"。而在AI领域,我们终于有了一个能够践行这一哲学思想的技术框架——MAS-ZERO,帮我们构建能够因地制宜、因时制宜的智能系统。

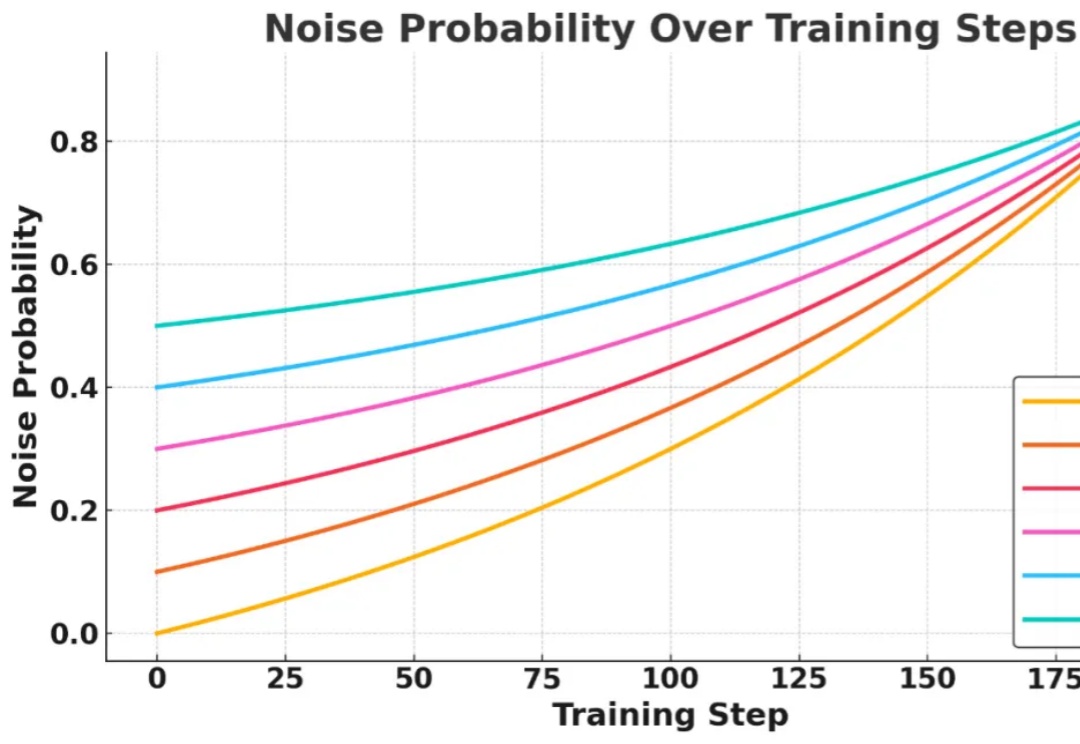

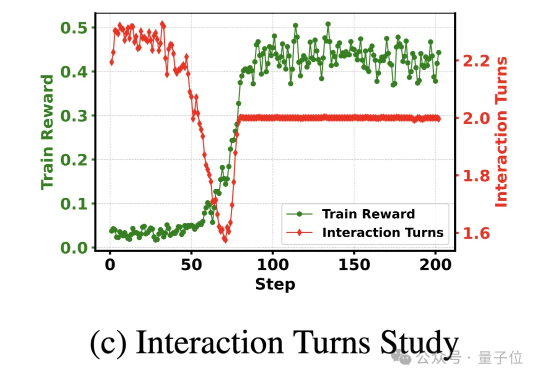

信息检索能力对提升大语言模型 (LLMs) 的推理表现至关重要,近期研究尝试引入强化学习 (RL) 框架激活 LLMs 主动搜集信息的能力,但现有方法在训练过程中面临两大核心挑战:

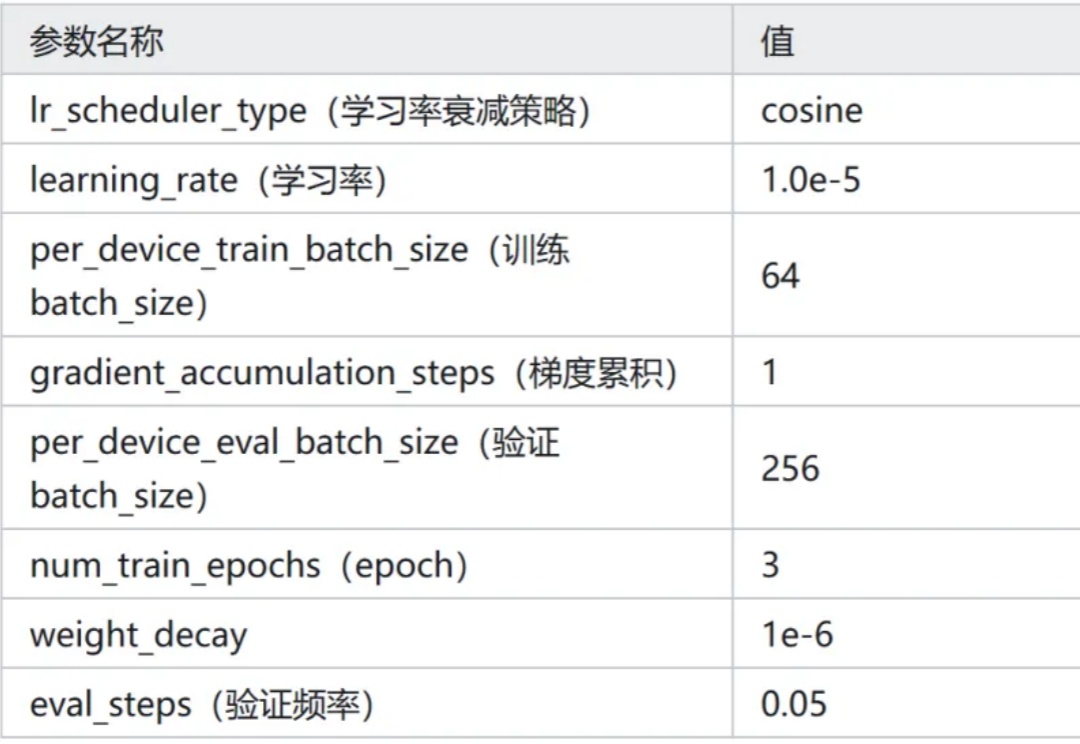

新增 Qwen3-0.6B 在 Ag_news 数据集 Zero-Shot 的效果。新增 Qwen3-0.6B 线性层分类方法的效果。

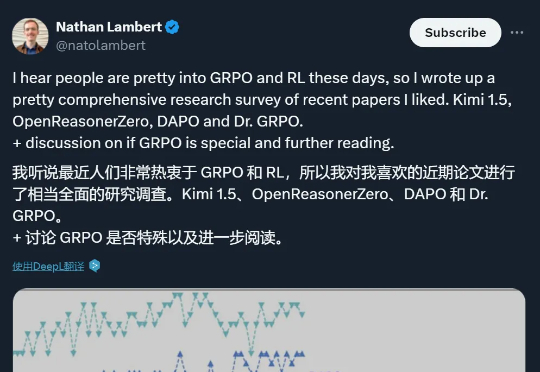

本文详细解读了 Kimi k1.5、OpenReasonerZero、DAPO 和 Dr. GRPO 四篇论文中的创新点,读完会对 GRPO 及其改进算法有更深的理解,进而启发构建推理模型的新思路。

强化学习(RL)+真实搜索引擎,可以有效提升大模型检索-推理能力。

不用引入外部数据,通过自我博弈(Self-play)就能让预训练大模型学会推理?