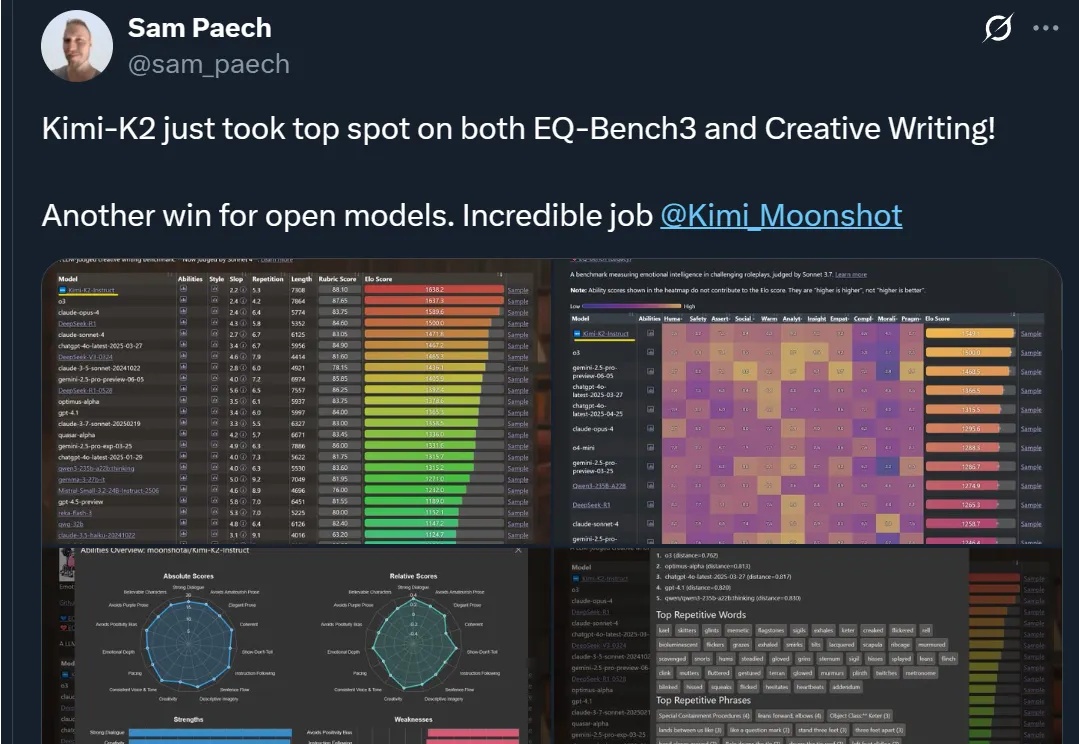

DeepSeek终于丢了开源第一王座,但继任者依然来自中国

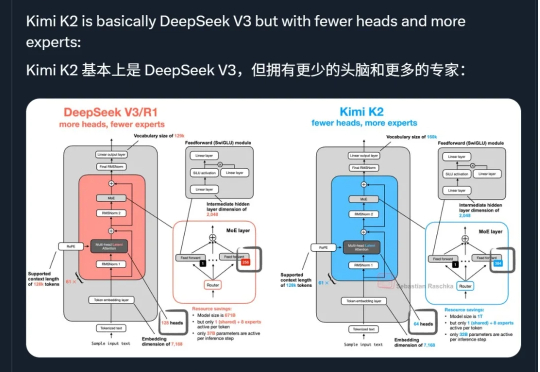

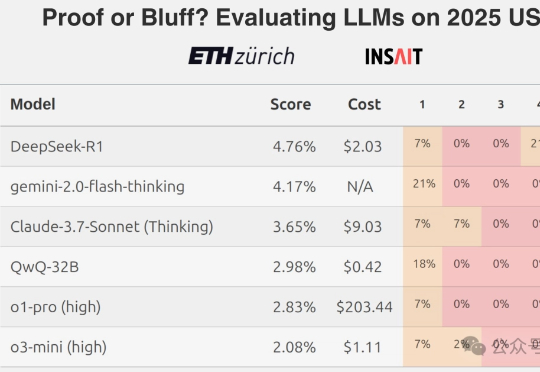

DeepSeek终于丢了开源第一王座,但继任者依然来自中国几千人盲投,Kimi K2超越DeepSeek拿下全球开源第一!

几千人盲投,Kimi K2超越DeepSeek拿下全球开源第一!

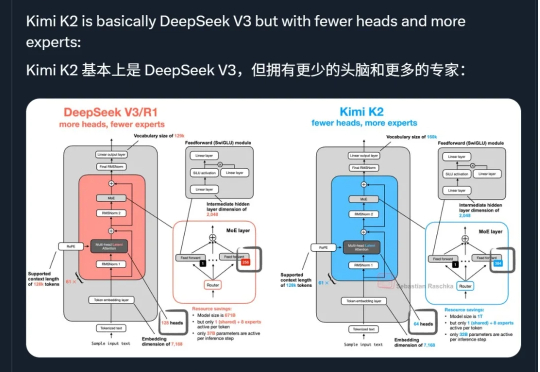

AI做奥数的神话,刚刚被戳破了!最新出炉的2025 IMO数学竞赛中,全球顶尖AI模型无一例外翻车了。即便是冠军Gemini也只拿下可怜的31分,连铜牌都摸不到。Grok-4更是摆烂到底,连DeepSeek-R1都令人失望。看来,AI想挑战人类奥数大神,还为时尚早。

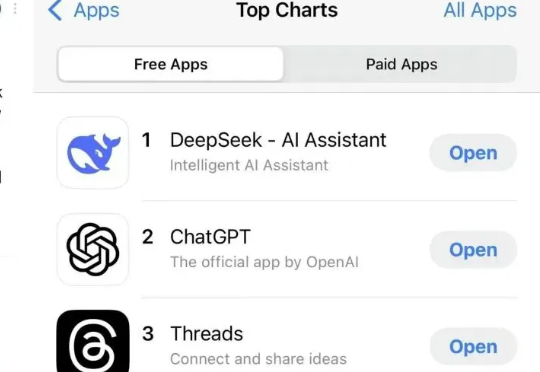

半年前,DeepSeek R1 的推出轰动了全球,无论东西方都是火的一塌糊涂,更是被外网称为 AI 领域的 Sputnik 时刻。

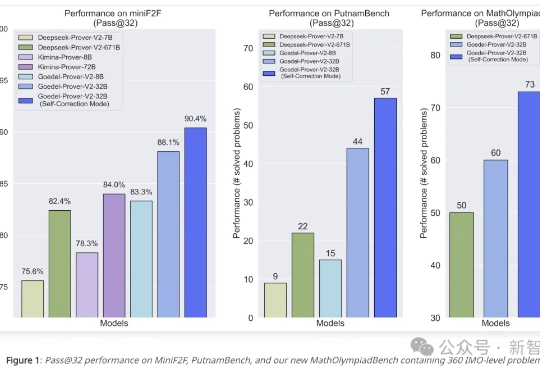

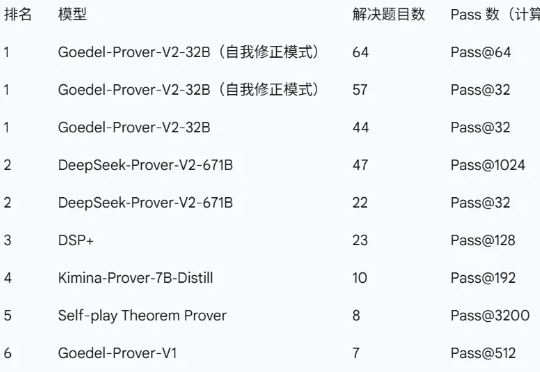

迄今为止最强大的开源定理证明器登场!Goedel-Prover-V2仅用8B参数击败671B的DeepSeek-Prover,并再次夺下数学PutnamBench冠军。十位核心贡献者,八大顶尖机构,让AI形式化证明再破纪录。

近日,由普林斯顿大学牵头,联合清华大学、北京大学、上海交通大学、斯坦福大学,以及英伟达、亚马逊、Meta FAIR 等多家顶尖机构的研究者共同推出了新一代开源数学定理证明模型——Goedel-Prover-V2。

英伟达CEO黄仁勋再访北京,盛赞华为是「非常优秀」的竞争对手,并认为「DeepSeek、Qwen、Kimi都很优秀」。

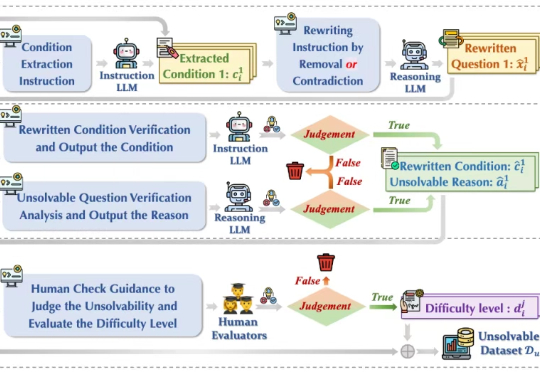

今年初以 DeepSeek-r1 为代表的大模型在推理任务上展现强大的性能,引起广泛的热度。然而在面对一些无法回答或本身无解的问题时,这些模型竟试图去虚构不存在的信息去推理解答,生成了大量的事实错误、无意义思考过程和虚构答案,也被称为模型「幻觉」 问题,如下图(a)所示,造成严重资源浪费且会误导用户,严重损害了模型的可靠性(Reliability)。

从GPT-2到Llama 4,大模型这几年到底「胖」了多少?从百亿级密集参数到稀疏MoE架构,从闭源霸权到开源反击,Meta、OpenAI、Mistral、DeepSeek……群雄割据,谁能称王?

最近大家有没有发现,好多店家开始用 DeepSeek 来营销了?

Kimi新模型热度持续高涨ing!