Mercury:颠覆性扩散大语言模型如何重塑AI生成领域

Mercury:颠覆性扩散大语言模型如何重塑AI生成领域2025年2月27日,由前扩散模型领域顶尖研究者创立的Inception Labs正式发布了全球首个商业级扩散大语言模型(dLLM)——“Mercury”。这一里程碑式产品不仅在生成速度、硬件效率和成本控制上实现突破,更标志着自然语言处理技术从自回归(Autoregressive)范式向扩散(Diffusion)范式的重大跃迁。

2025年2月27日,由前扩散模型领域顶尖研究者创立的Inception Labs正式发布了全球首个商业级扩散大语言模型(dLLM)——“Mercury”。这一里程碑式产品不仅在生成速度、硬件效率和成本控制上实现突破,更标志着自然语言处理技术从自回归(Autoregressive)范式向扩散(Diffusion)范式的重大跃迁。

智东西3月3日报道,继2月22日超过豆包后,今日,腾讯旗下AI大模型应用腾讯元宝超过DeepSeek,登顶iOS免费App榜。近期借势DeepSeek,腾讯元宝存在感爆棚,密集上新:2月17日宣布已上线DeepSeek-R1 671B和腾讯混元深度思考模型Thinker(T1);2月18日宣布调用腾讯元宝紧急支持微信搜索,让大家都能稳定体验和使用DeepSeek-R1;

现有的可控Diffusion Transformer方法,虽然在推进文本到图像和视频生成方面取得了显著进展,但也带来了大量的参数和计算开销。

我想在沙漠里建一个室内滑雪场。DeepSeek:可以,详细计划如下。这是阿里国际站首个AI搜索引擎Accio接入DeepSeek之后的演示首秀。即便是这么离谱的想法,它还是在短短30秒内搜索了大量资料、反复推理,给出了一份有理有据的商业计划。

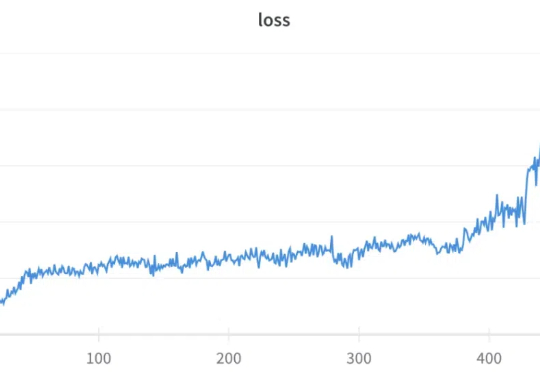

GRPO(Group Relative Policy Optimization)是 DeepSeek-R1 成功的基础技术之一,我们之前也多次报道过该技术,比如《DeepSeek 用的 GRPO 占用大量内存?有人给出了些破解方法》。

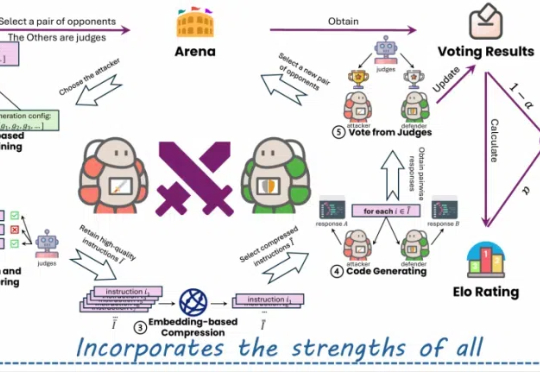

近年来,大型语言模型(LLMs)在代码相关的任务上展现了惊人的表现,各种代码大模型层出不穷。这些成功的案例表明,在大规模代码数据上进行预训练可以显著提升模型的核心编程能力。

这家初创公司希望让大公司争夺大众市场,而自己专注于吸引行业专业人士,并与 Lionsgate 达成一笔里程碑式的交易。

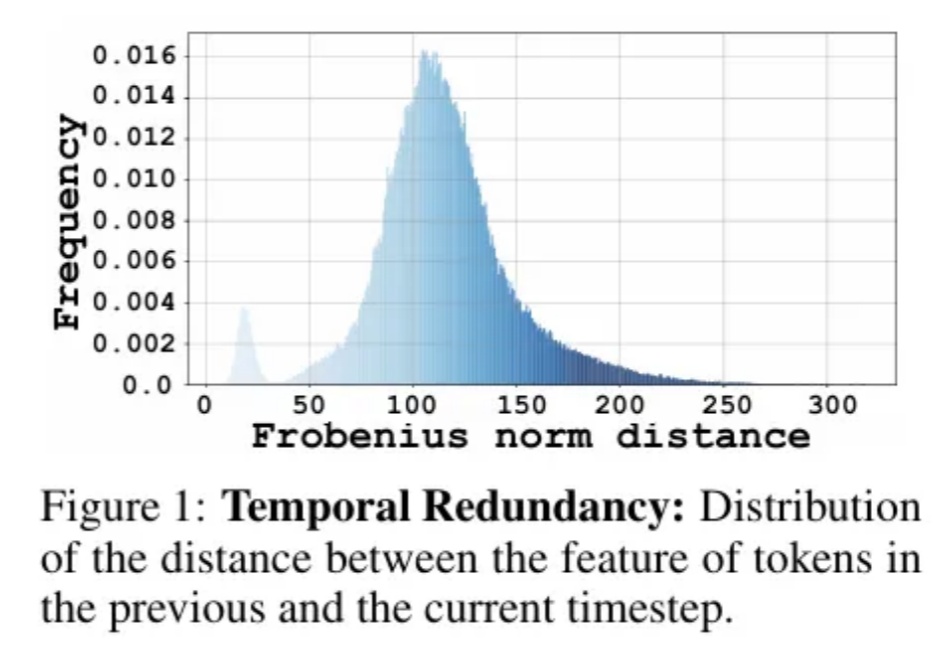

Diffusion Transformer模型模型通过token粒度的缓存方法,实现了图像和视频生成模型上无需训练的两倍以上的加速。

这位曾用代码构建童话世界的工程师,被困在了由 AI 工具引发的一场噩梦里。

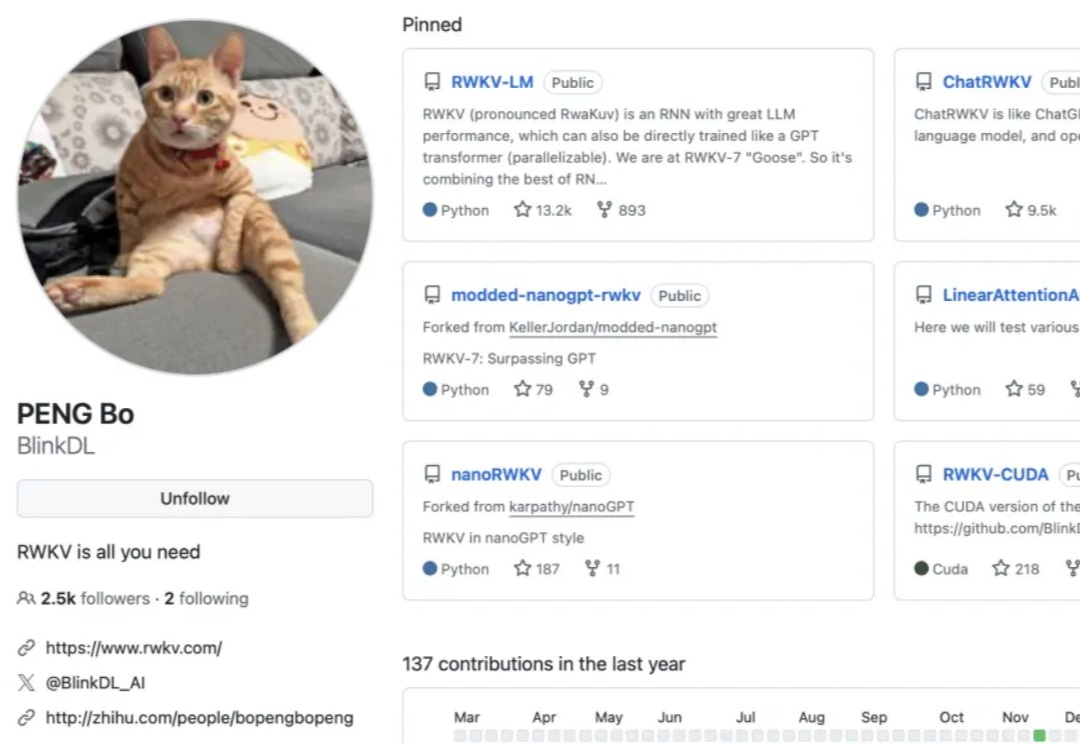

当DeepSeek引发业界震动时,元始智能创始人彭博正专注于一个更宏大的愿景。