AI“入侵”生物医药史:从暴力破解到Transformer模型三部曲

AI“入侵”生物医药史:从暴力破解到Transformer模型三部曲AI如何颠覆生物科技? AI正在入侵科学界,特别是生物科技方向。 瑞典皇家科学院在2024年10月宣布了当年诺贝尔化学奖的获奖者,出乎意料的是—— AI又是大赢家。

AI如何颠覆生物科技? AI正在入侵科学界,特别是生物科技方向。 瑞典皇家科学院在2024年10月宣布了当年诺贝尔化学奖的获奖者,出乎意料的是—— AI又是大赢家。

Mamba 这种状态空间模型(SSM)被认为是 Transformer 架构的有力挑战者。近段时间,相关研究成果接连不断。而就在不久前,Mamba 作者 Albert Gu 与 Karan Goel、Chris Ré、Arjun Desai、Brandon Yang 一起共同创立的 Cartesia 获得 2700 万美元种子轮融资。

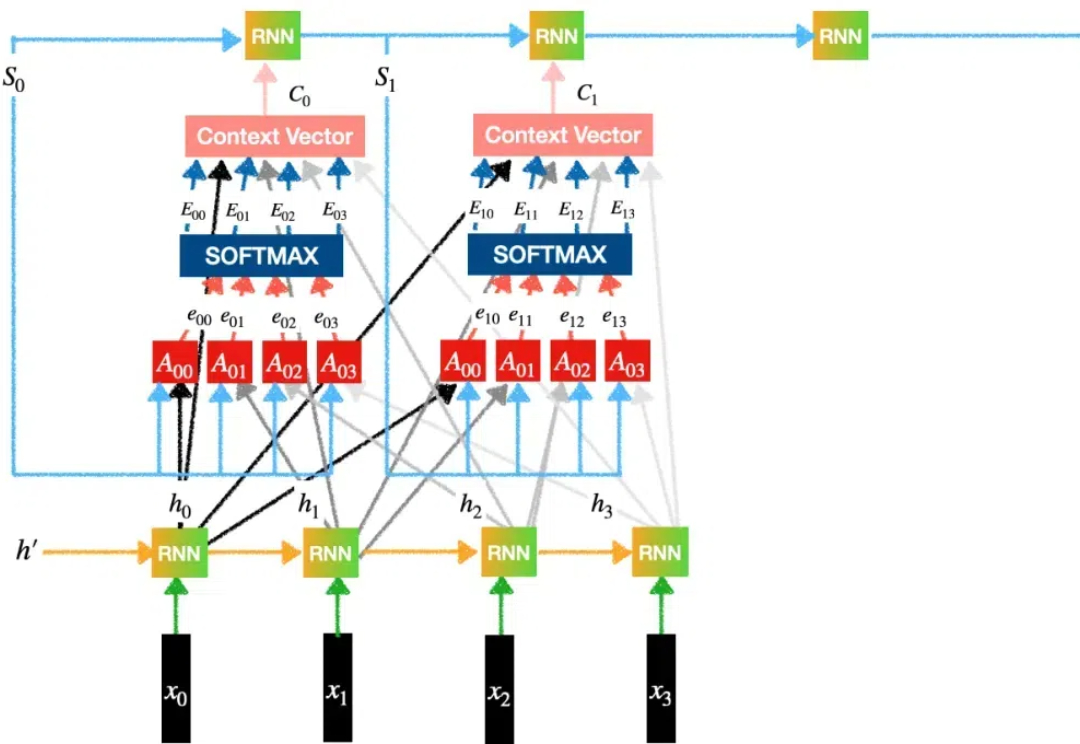

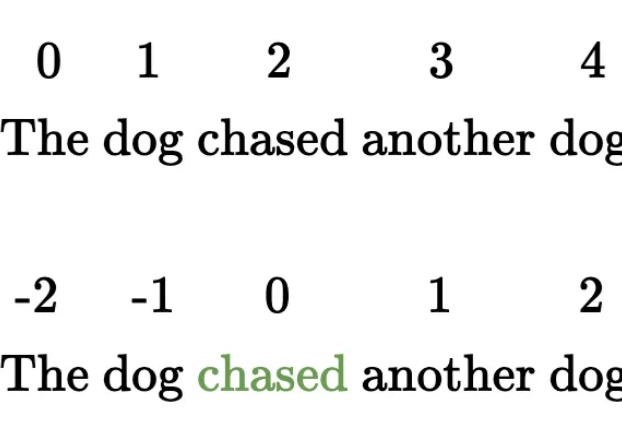

Transformer模型自2017年问世以来,已成为AI领域的核心技术,尤其在自然语言处理中占据主导地位。然而,关于其核心机制“注意力”的起源,学界存在争议,一些学者如Jürgen Schmidhuber主张自己更早提出了相关概念。

几个小时前,著名 AI 研究者、OpenAI 创始成员之一 Andrej Karpathy 发布了一篇备受关注的长推文,其中分享了注意力机制背后一些或许少有人知的故事。

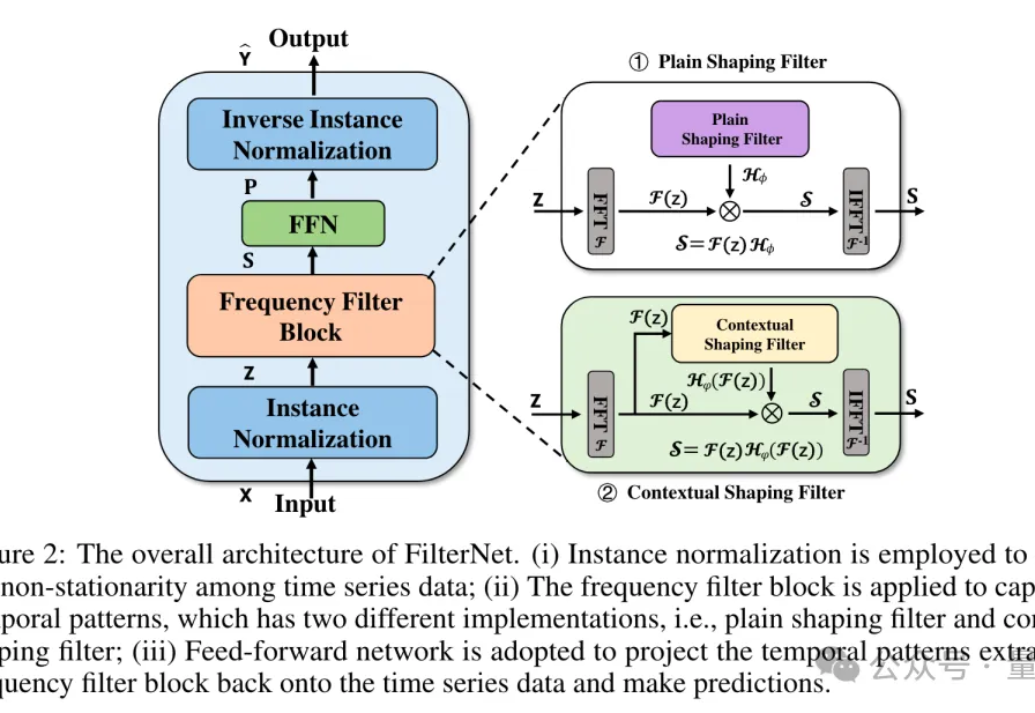

无需Transformer,简单滤波器即可提高时间序列预测精度。 由国家信息中心、牛津大学、北京理工大学、同济大学、中国科学技术大学等机构的团队提出了一个FilterNet。 目前已被NeurlPS 2024接收。

一个有效的复杂系统总是从一个有效的简单系统演化而来的。——John Gall

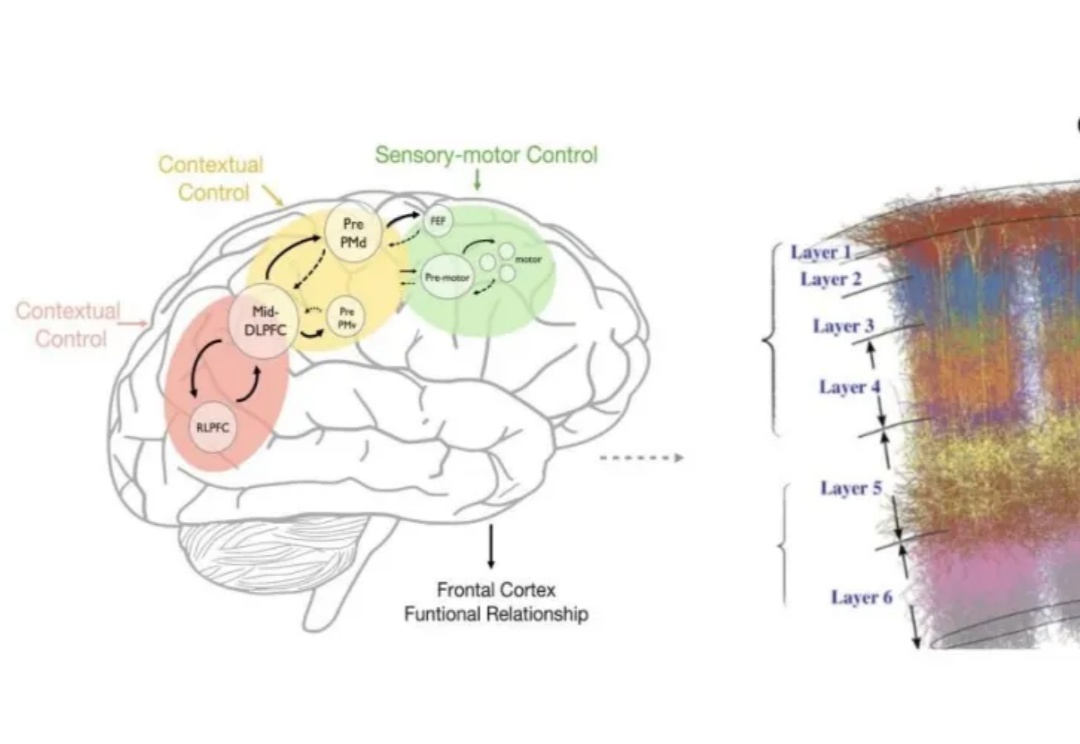

北京大学研究团队开发的FAN模型能有效捕捉数据中的周期性模式,相比传统模型在多项任务中表现出色,同时降低了参数量和计算量,增强了对周期性特征的建模能力,应用潜力广泛。

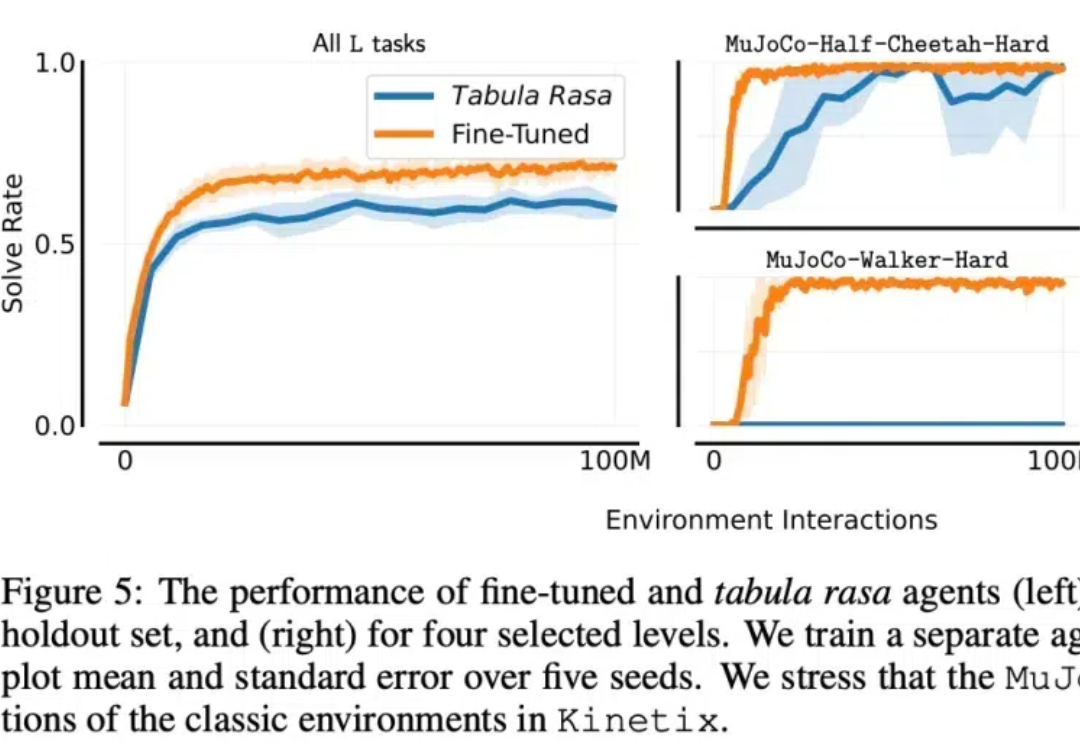

在机器学习领域,开发一个在未见过领域表现出色的通用智能体一直是长期目标之一。一种观点认为,在大量离线文本和视频数据上训练的大型 transformer 最终可以实现这一目标。

在AI领域数据和算力的军备竞赛中,AI从业者要么紧密跟随OpenAI等领先公司做进一步的应用开发,要么在Transformer机制日益显现局限之时探索新的路径。

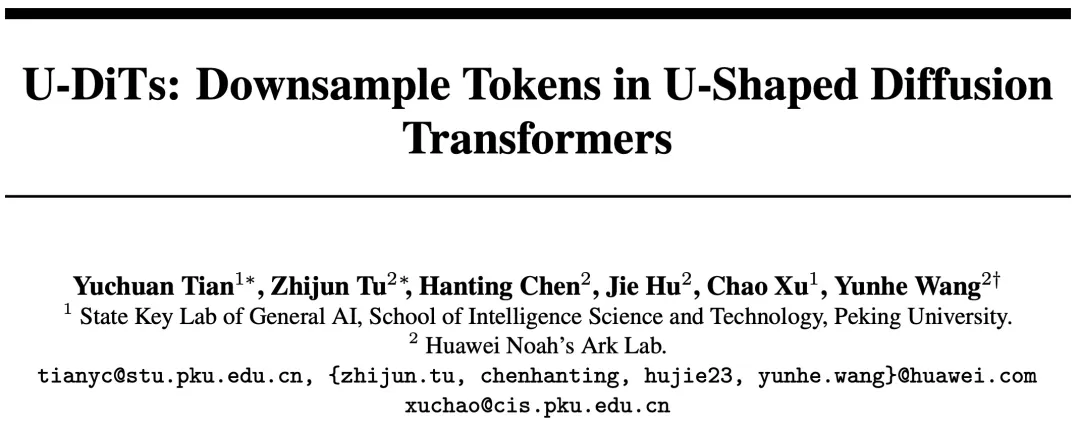

Sora 的发布让广大研究者及开发者深刻认识到基于 Transformer 架构扩散模型的巨大潜力。作为这一类的代表性工作,DiT 模型抛弃了传统的 U-Net 扩散架构,转而使用直筒型去噪模型。鉴于直筒型 DiT 在隐空间生成任务上效果出众,后续的一些工作如 PixArt、SD3 等等也都不约而同地使用了直筒型架构。