文生图参数量升至240亿!Playground v3发布:深度融合LLM,图形设计能力超越人类

文生图参数量升至240亿!Playground v3发布:深度融合LLM,图形设计能力超越人类自去年以来,文本到图像生成模型取得了巨大进展,模型的架构从传统的基于UNet逐渐转变为基于Transformer的模型。

自去年以来,文本到图像生成模型取得了巨大进展,模型的架构从传统的基于UNet逐渐转变为基于Transformer的模型。

通用机器人模型,目前最大的障碍便是「异构性」。

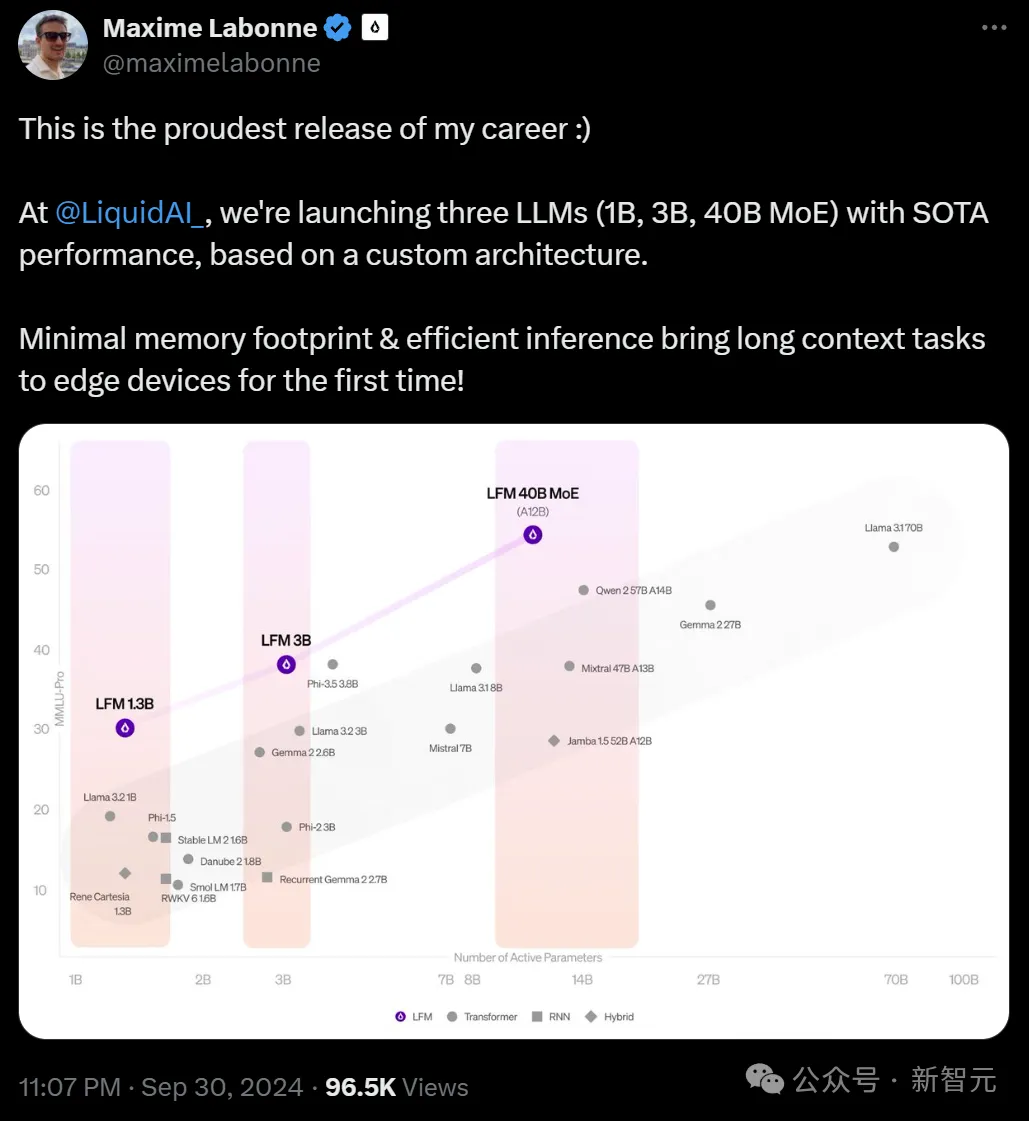

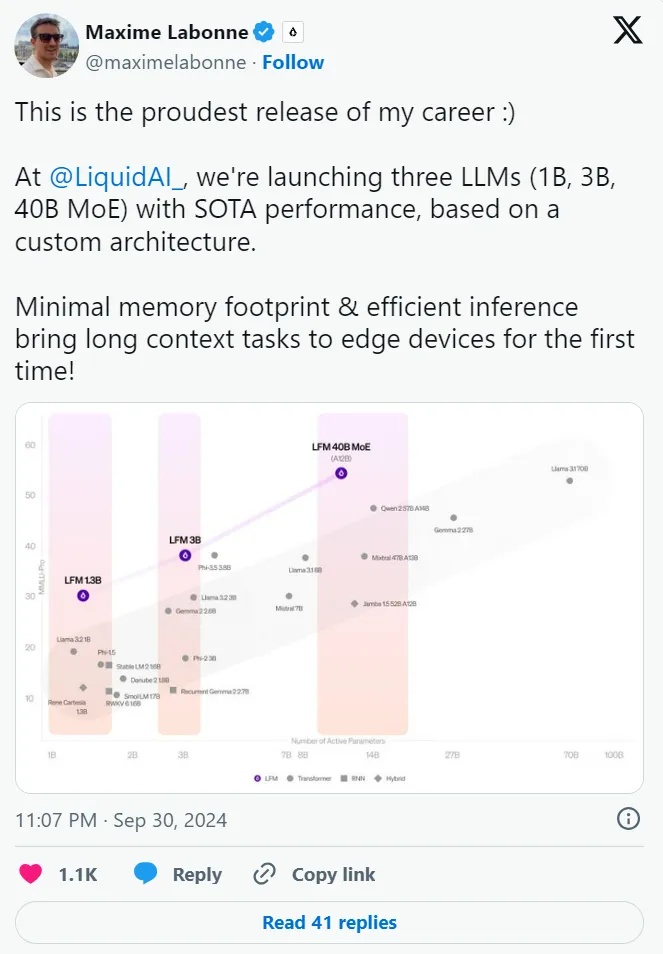

挑战Transformer,MIT初创团队推出LFM(Liquid Foundation Model)新架构模型爆火。

就在刚刚,MIT系初创公司Liquid AI团队官宣:推出首批多模态非Transformer模型——液体基础模型LFM。

一个受线虫启发的全新架构,三大「杯型」均能实现 SOTA 性能,资源高度受限环境也能部署。移动机器人可能更需要一个虫子的大脑。

通往AGI的路径只有一条吗?实则不然。这家国产AI黑马认为,「群体智能」或许是一种最佳的尝试。他们正打破惯性思维,打造出最强AI大脑,要让世界每一台设备都有自己的智能。

取代现有计算架构。 人工智能(AI)硬件有望彻底被颠覆,在计算速度和能效方面实现前所未有的改进。

扩展多模态大语言模型(MLLMs)的长上下文能力对于视频理解、高分辨率图像理解以及多模态智能体至关重要。这涉及一系列系统性的优化,包括模型架构、数据构建和训练策略,尤其要解决诸如随着图像增多性能下降以及高计算成本等挑战。

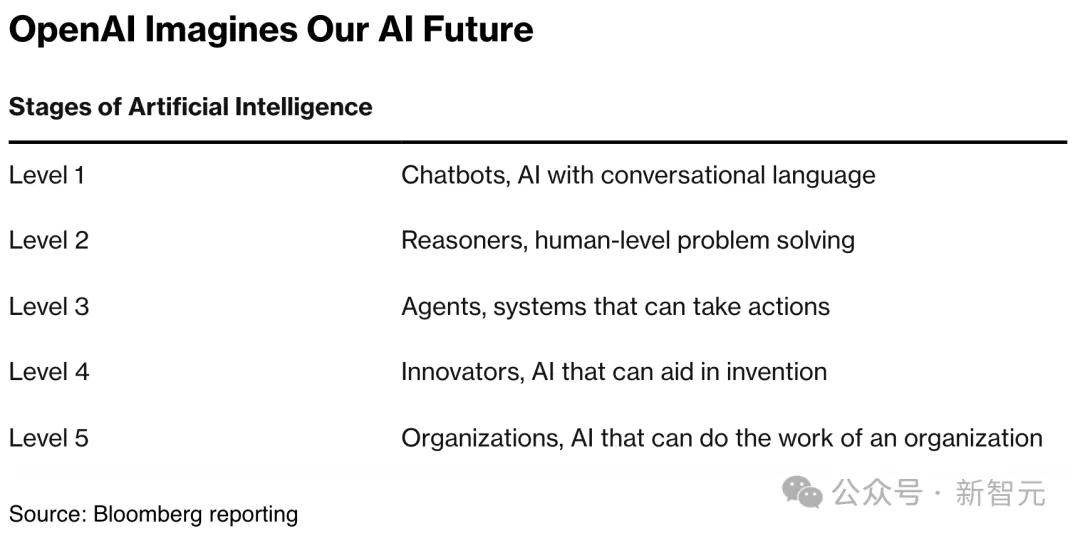

随OpenAI爆火的CoT,已经引发了大佬间的激战!谷歌DeepMind首席科学家Denny Zhou拿出一篇ICLR 2024论文称:CoT可以让Transformer推理无极限。但随即他就遭到了田渊栋和LeCun等的质疑。最终,CoT会是通往AGI的正确路径吗?

Transformer 是现代深度学习的基石。传统上,Transformer 依赖多层感知器 (MLP) 层来混合通道之间的信息。