直接扩展到无限长,谷歌Infini-Transformer终结上下文长度之争

直接扩展到无限长,谷歌Infini-Transformer终结上下文长度之争谷歌又放大招了,发布下一代 Transformer 模型 Infini-Transformer。

谷歌又放大招了,发布下一代 Transformer 模型 Infini-Transformer。

谷歌终于更新了Transformer架构。最新发布的Mixture-of-Depths(MoD),改变了以往Transformer计算模式。它通过动态分配大模型中的计算资源,跳过一些不必要计算,显著提高训练效率和推理速度。

物体姿态估计对于各种应用至关重要,例如机器人操纵和混合现实。实例级方法通常需要纹理 CAD 模型来生成训练数据,并且不能应用于测试时未见过的新物体;而类别级方法消除了这些假设(实例训练和 CAD 模型),但获取类别级训练数据需要应用额外的姿态标准化和检查步骤。

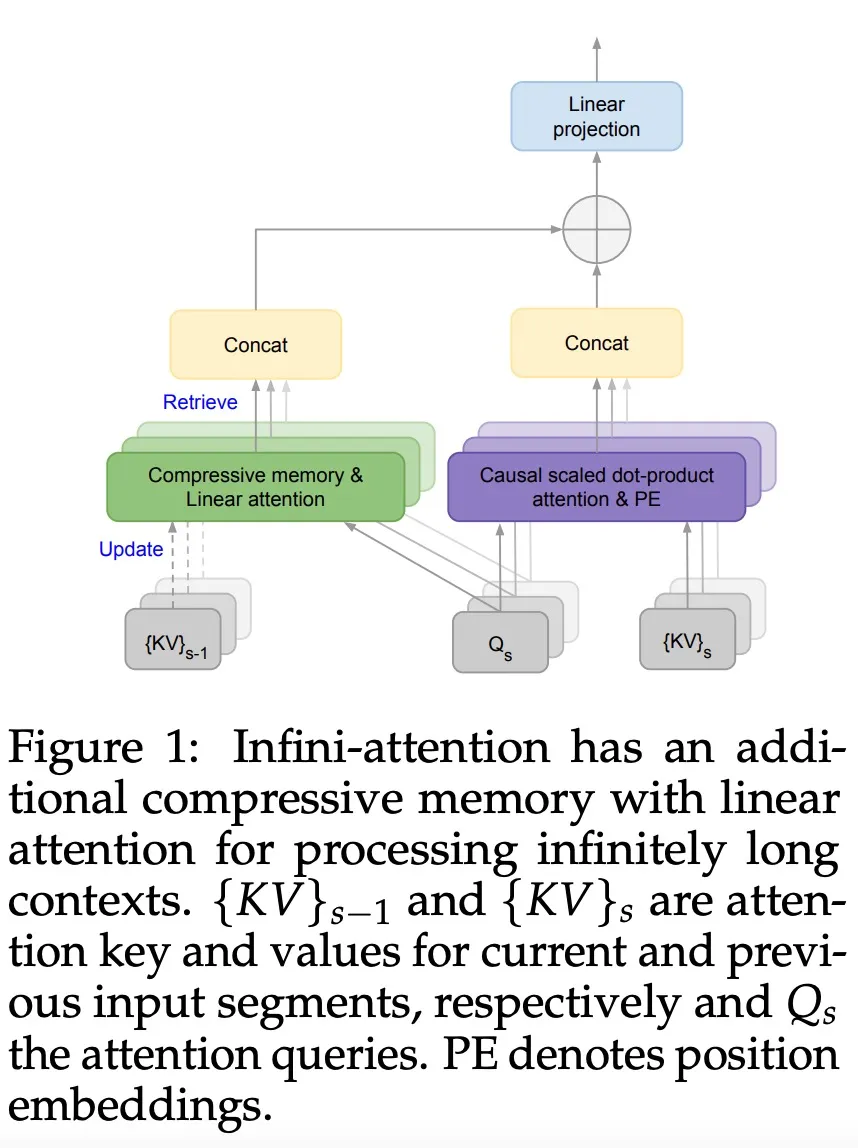

基于 Transformer 架构的大语言模型在 NLP 领域取得了令人惊艳的效果,然而,Transformer 中自注意力带来的二次复杂度使得大模型的推理成本和内存占用十分巨大,特别是在长序列的场景中。

解决最短路径算法,也能被扩散模型完成。

现在,AI 大模型已经疯狂到这种地步了吗?此时此刻,正有两个 Claude 模型在无休止地对话,它们在探索整个宇宙的奥妙。

目前,Video Pose Transformer(VPT)在基于视频的三维人体姿态估计领域取得了最领先的性能。近年来,这些 VPT 的计算量变得越来越大,这些巨大的计算量同时也限制了这个领域的进一步发展,对那些计算资源不足的研究者十分不友好。例如,训练一个 243 帧的 VPT 模型通常需要花费好几天的时间,严重拖慢了研究的进度,并成为了该领域亟待解决的一大痛点。

安克经常被国人认为是一家充电宝公司,但其实是个做细分品类的公司,充电宝收入只占他们收入的 10% 不到。2022 年,安克营收 20 亿美元,在充电和储能、影音设备、智能家居三个领域里,不少细分品类都做到了全球第一梯队。

精彩精彩,第一个把爆火Mamba架构真正扩展到足够大的工作来了。 520亿参数,还是Mamba+Transformer混合架构。 它的名字叫Jamba。

【新智元导读】52B的生产级Mamba大模型来了!这个超强变体Jamba刚刚打破世界纪录,它能正面硬刚Transformer,256K超长上下文窗口,吞吐量提升3倍,权重免费下载。