Attention isn’t all you need!Mamba混合大模型开源:三倍Transformer吞吐量

Attention isn’t all you need!Mamba混合大模型开源:三倍Transformer吞吐量Mamba时代来了?

Mamba时代来了?

让大模型自己动手,好过让人类动手。黄仁勋对话Transformer八子时,最后一位离开谷歌的论文作者Llion Jones,相信这是大模型技术的关键趋势。他还卖了个关子,预告他创立的Sakana AI马上就有大动作。

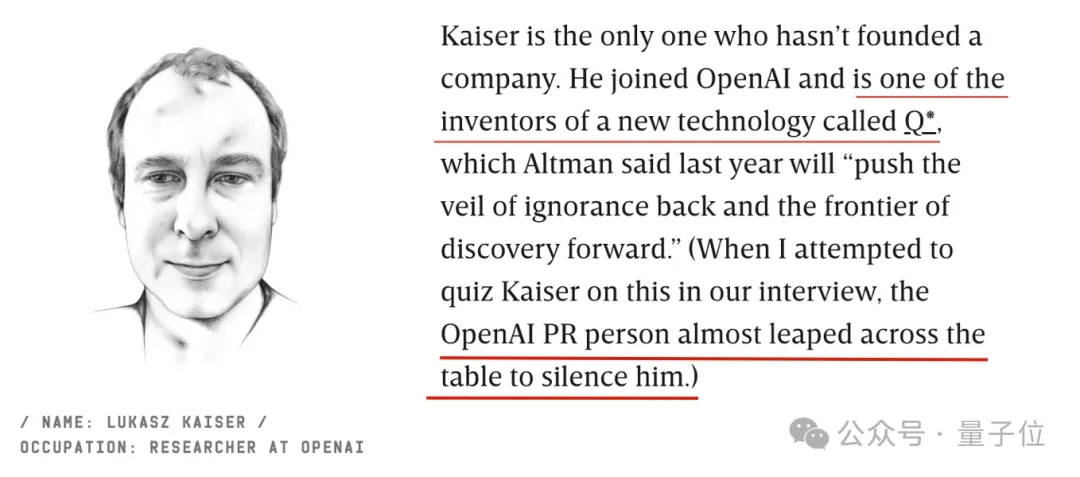

Transformer作者中唯一去了OpenAI的那位,公开承认了:他参与了Q*项目,是这项新技术的发明者之一。这几天除了英伟达老黄组局把Transformer作者聚齐,他们中的几位还接受了连线杂志的采访,期间出了这么一个小插曲。

把Huggingface上的现成模型拿来“攒一攒”—— 直接就能组合出新的强大模型?!日本大模型公司sakana.ai脑洞大开(正是“Transformer八子”之一所创办的公司),想出了这么一个进化合并模型的妙招。

去年 8 月,两位著名的前谷歌研究人员 David Ha、Llion Jones 宣布创立一家人工智能公司 Sakana AI,总部位于日本东京。

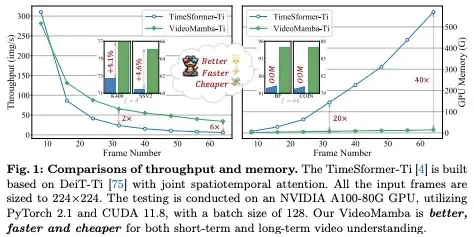

视频理解因大量时空冗余和复杂时空依赖,同时克服两个问题难度巨大,CNN 和 Transformer 及 Uniformer 都难以胜任,Mamba 是个好思路,让我们看看本文是如何创造视频理解的 VideoMamba。

淘天在AI电商上迈出的重要一步。Tech星球独家获悉,淘宝天猫集团自研大模型“淘宝星辰”官网已经上线,这也是淘天集团公开的首个自研大模型。官网除了显示该大模型的介绍外,还设置有“立即体验”和“登录/注册”入口,或将在不久对外开放。

Transformer奠基之作拯救了现在的AI。就在GTC大会上,老黄聚齐了其中的七位作者,开启了一场深度访谈。

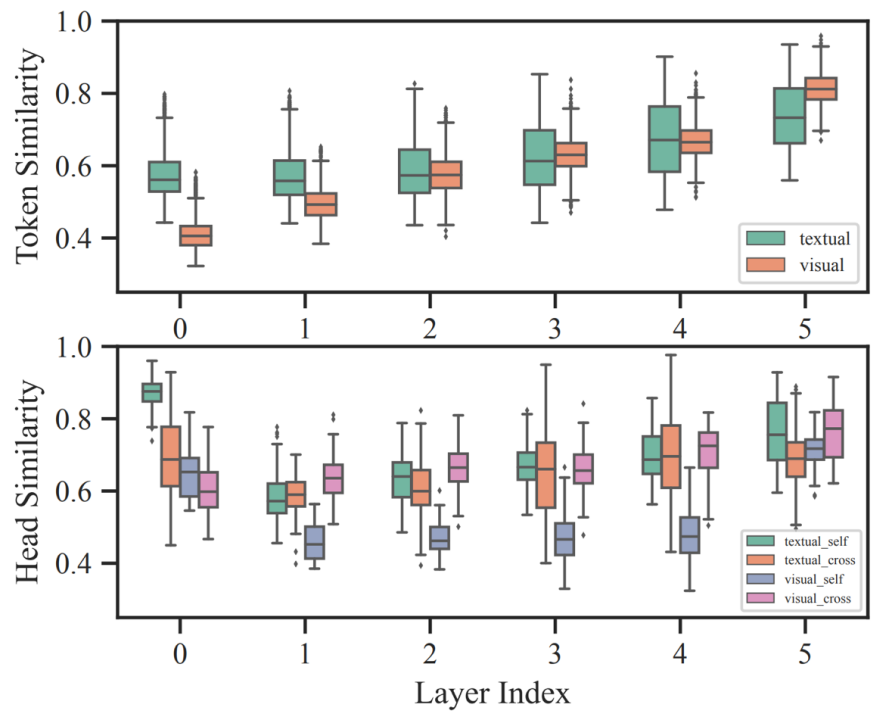

哈工大联合度小满推出针对多模态模型的自适应剪枝算法 SmartTrim,论文已被自然语言处理顶级会议 COLING 24 接收。

新模型bGPT是一个基于字节的Transformer模型,能够将不同类型的数据纳入同一框架之下,可以生成文本、图像和音频,还能模拟计算机行为,数字世界将迎来真正的大一统?