PyTorch官方认可!斯坦福博士新作:长上下文LLM推理速度提8倍

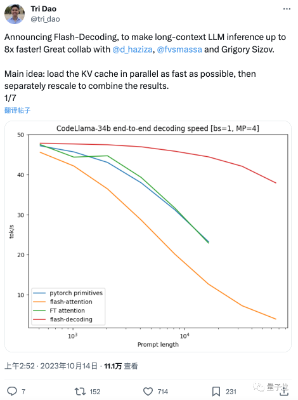

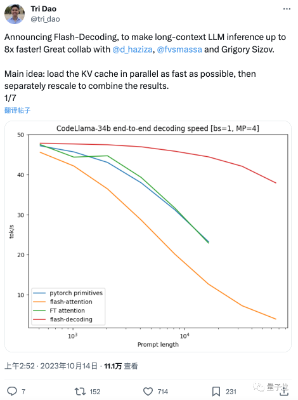

PyTorch官方认可!斯坦福博士新作:长上下文LLM推理速度提8倍这两天,FlashAttention团队推出了新作: 一种给Transformer架构大模型推理加速的新方法,最高可提速8倍。 该方法尤其造福于长上下文LLM,在64k长度的CodeLlama-34B上通过了验证

来自主题: AI技术研报

4212 点击 2023-10-18 14:43

这两天,FlashAttention团队推出了新作: 一种给Transformer架构大模型推理加速的新方法,最高可提速8倍。 该方法尤其造福于长上下文LLM,在64k长度的CodeLlama-34B上通过了验证

悄无声息,羊驼家族“最强版”来了! 与GPT-4持平,上下文长度达3.2万token的LLaMA 2 Long,正式登场。

ChatGPT 已成为大多数人日常用来自动执行各种任务的不可或缺的工具。如果您使用 ChatGPT 任何时间,您都会意识到它可能会提供错误的答案,并且在某些利基主题上仅限于零上下文。这就提出了我们如何利用 chatGPT 来弥补差距并允许 ChatGPT 拥有更多自定义数据的问题。