GDP增长将取决于Tokens数量?微软CEO纳德拉达沃斯对话信息量太大了……

GDP增长将取决于Tokens数量?微软CEO纳德拉达沃斯对话信息量太大了……在2026年的世界经济论坛上,微软 CEO 萨提亚·纳德拉(Satya Nadella)与贝莱德 CEO 拉里·芬克(Larry Fink)进行了一场对话。

在2026年的世界经济论坛上,微软 CEO 萨提亚·纳德拉(Satya Nadella)与贝莱德 CEO 拉里·芬克(Larry Fink)进行了一场对话。

前两天听同事说豆包在浦东美术馆接活儿了,不光带人逛展,还包讲解的那种。(震惊.jpg)

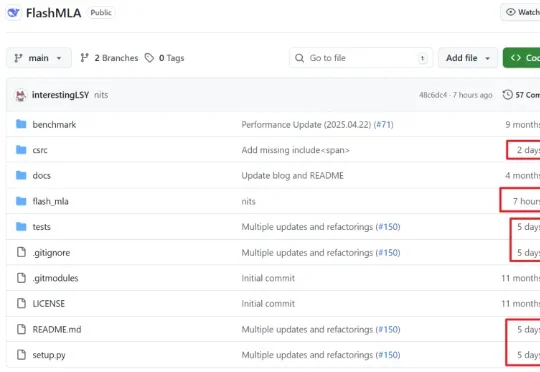

如果你最近关注了 GitHub,可能会注意到一个有趣的现象: YOLO 的版本号,直接从 11 跳到了 26。

2025 年 1 月 20 日,DeepSeek(深度求索)正式发布了 DeepSeek-R1 模型,并由此开启了新的开源 LLM 时代。在 Hugging Face 刚刚发布的《「DeepSeek 时刻」一周年记》博客中,DeepSeek-R1 也是该平台上获赞最多的模型。

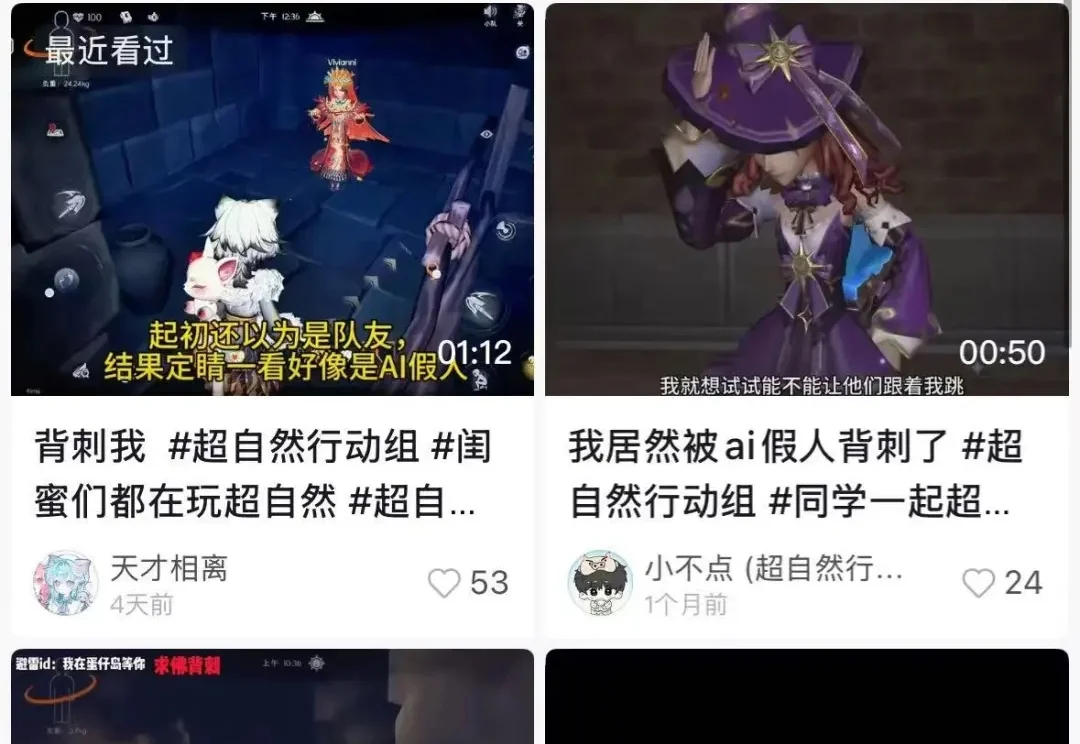

谁能想到,有朝一日,人在游戏里会被 AI 耍得团团转。

昨天,Claude刚刚被曝要有永久记忆,今天就被开发者抢先一步。一个叫Smart Forking的扩展,让大模型首次拥有「长期记忆」,无需重头解释。开发者圈沸腾了:难以置信,它真的能跑!

我们进入了一个模型不再只是“工具”的时代。真正的突破,不在于它能做多少事,而在于它是否能读懂你的意图、情绪与沉默。

「服务器繁忙,请稍后再试。」

不要被AI的温柔表象欺骗! Anthropic最新研究刺穿了AGI的温情假象:你以为在和良师益友倾诉,其实是在悬崖边给「杀手」松绑。 当脆弱情感遇上激活值坍塌,RLHF防御层将瞬间溃缩。既然无法教化野兽,人类只能选择最冷酷的「赛博脑叶切除术」。

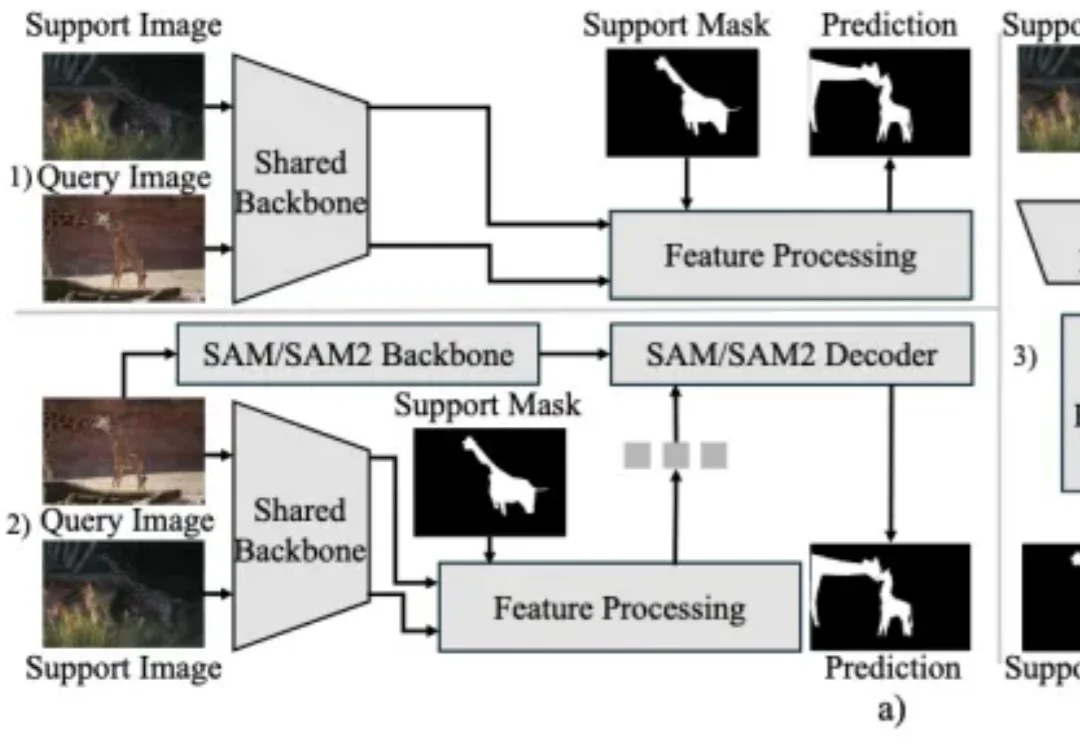

上下文分割(In-Context Segmentation)旨在通过参考示例指导模型实现对特定目标的自动化分割。尽管 SAM 凭借卓越的零样本泛化能力为此提供了强大的基础,但将其应用于此仍受限于提示(如点或框)构建,这样的需求不仅制约了批量推理的自动化效率,更使得模型在处理复杂的连续视频时,难以维持时空一致性。