NeurIPS 2025 | DePass:通过单次前向传播分解实现统一的特征归因

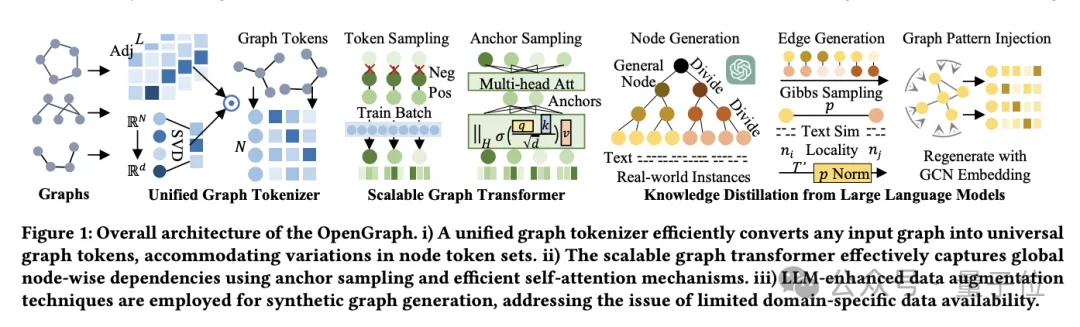

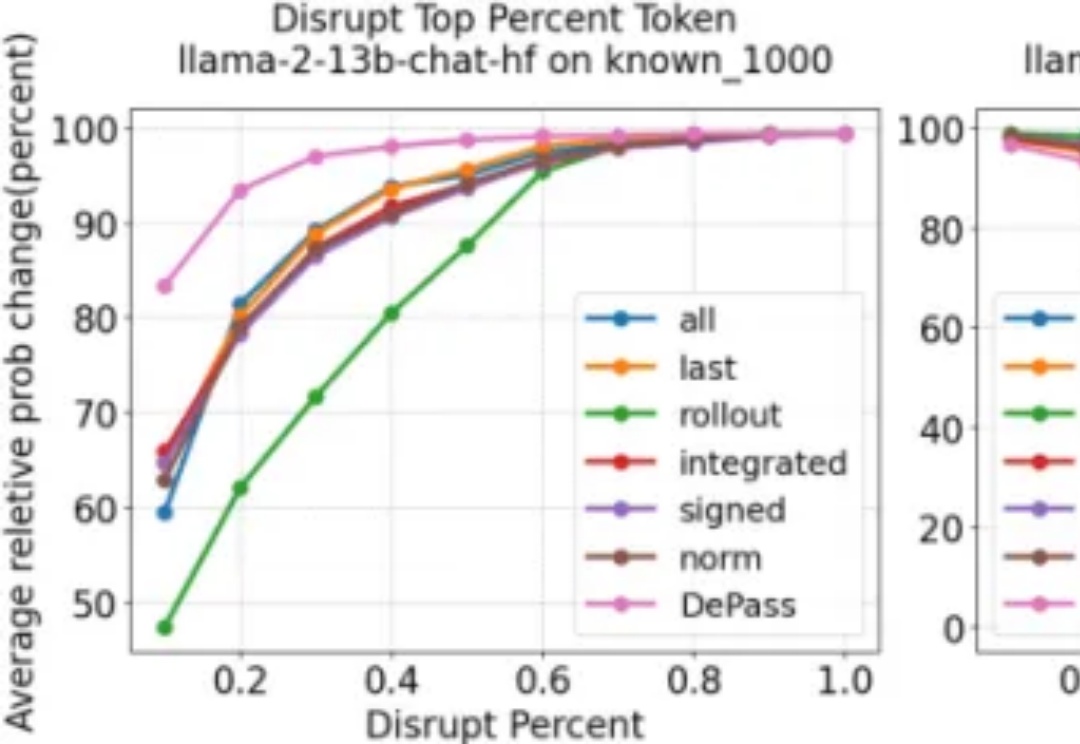

NeurIPS 2025 | DePass:通过单次前向传播分解实现统一的特征归因随着大型语言模型在各类任务中展现出卓越的生成与推理能力,如何将模型输出精确地追溯到其内部计算过程,已成为 AI 可解释性研究的重要方向。然而,现有方法往往计算代价高昂、难以揭示中间层的信息流动;同时,不同层面的归因(如 token、模型组件或表示子空间)通常依赖各自独立的特定方法,缺乏统一且高效的分析框架。

来自主题: AI技术研报

5695 点击 2025-12-01 13:49