扩散LLM推理用上类GRPO强化学习!优于单独SFT,UCLA、Meta新框架d1开源

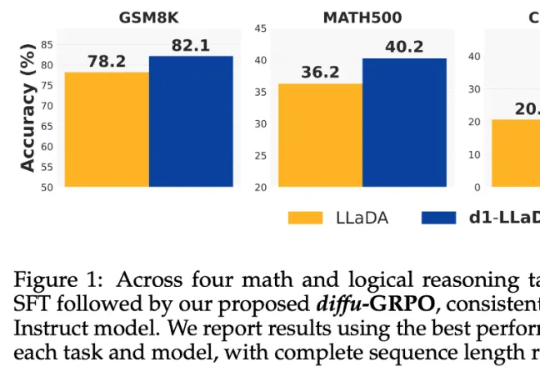

扩散LLM推理用上类GRPO强化学习!优于单独SFT,UCLA、Meta新框架d1开源当前,强化学习(RL)方法在最近模型的推理任务上取得了显著的改进,比如 DeepSeek-R1、Kimi K1.5,显示了将 RL 直接用于基础模型可以取得媲美 OpenAI o1 的性能不过,基于 RL 的后训练进展主要受限于自回归的大语言模型(LLM),它们通过从左到右的序列推理来运行。

来自主题: AI技术研报

6566 点击 2025-04-22 08:39