一个真正意义上的实时多模态智能体框架,TEN Framework 为构建下一代 AI Agent 而生

一个真正意义上的实时多模态智能体框架,TEN Framework 为构建下一代 AI Agent 而生有了 TEN(Transformative Extensions Network,变革性扩展网络),开发者们终于不用再「绞尽脑汁」了!TEN 是全球首个真正实现实时多模态智能体的框架,不仅能减少开发痛点,还让你轻松从头开始构建下一代 AI 应用。

有了 TEN(Transformative Extensions Network,变革性扩展网络),开发者们终于不用再「绞尽脑汁」了!TEN 是全球首个真正实现实时多模态智能体的框架,不仅能减少开发痛点,还让你轻松从头开始构建下一代 AI 应用。

GPT-4o 四月发布会掀起了视频理解的热潮,而开源领军者Qwen2也对视频毫不手软,在各个视频评测基准上狠狠秀了一把肌肉。

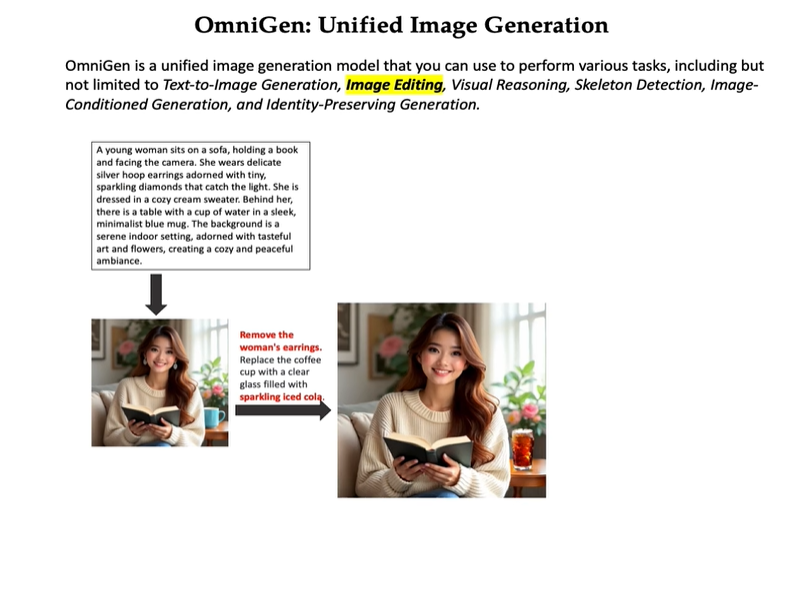

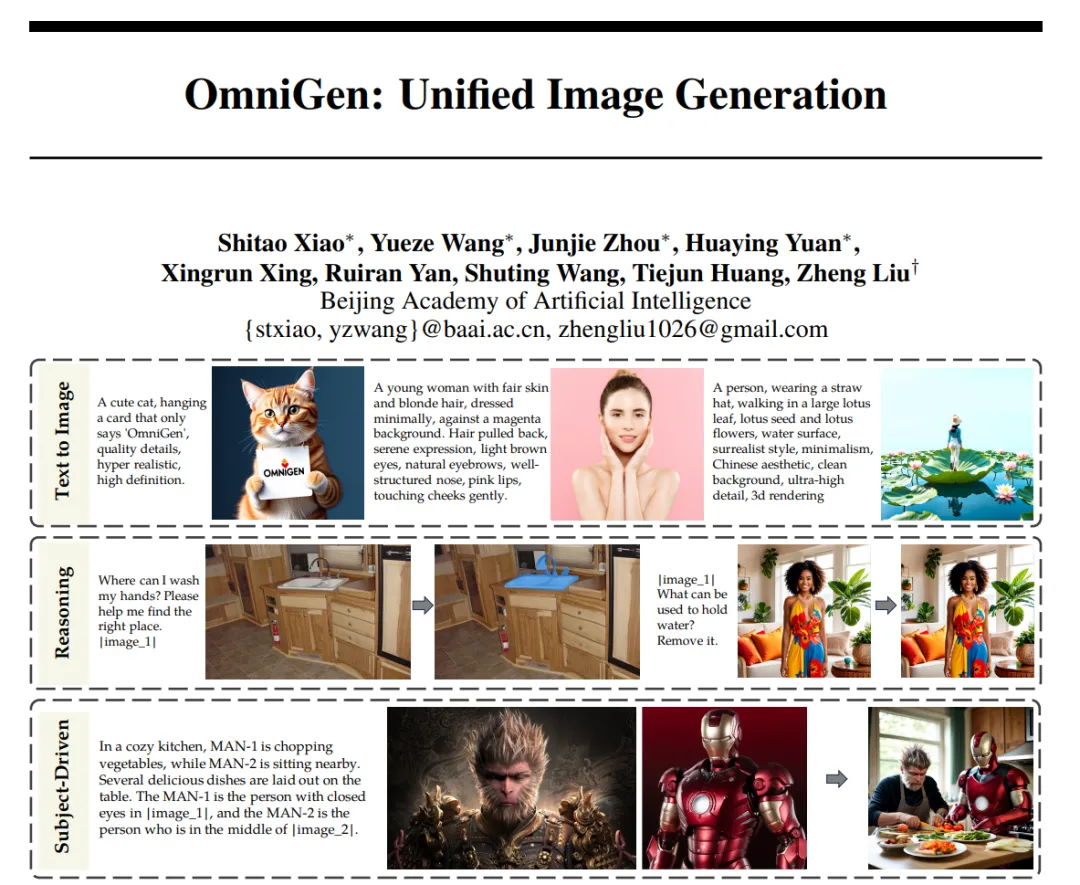

多模态模型,统一图像生成。

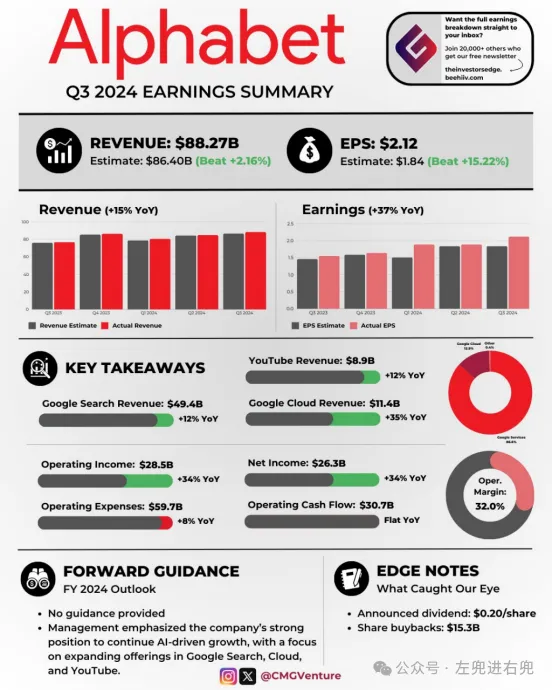

三季度谷歌母公司Alphabet总营收同比增长15%,EPS盈利增近37%远超预期;各业务中云营收增长最迅猛,云业务营业利润同比增超六倍、均再创单季新高;资本支出在二季度环比增近10%后转降0.9%,略高于预期;三季度广告收入增逾10%,其中谷歌搜索和YouTube广告的营收连续两季放缓,仍高于预期;YouTube广告和订阅总收入一年来首次单季突破500亿美元。

Janus 是 DeepSeek AI 开发的一个先进的多模态理解和生成框架,它通过创新性地解耦视觉编码路径来应对多模态理解和生成任务之间的需求冲突。

PUMA(emPowering Unified MLLM with Multi-grAnular visual generation)是一项创新的多模态大型语言模型(MLLM),由商汤科技联合来自香港中文大学、港大和清华大学的研究人员共同开发。它通过统一的框架处理和生成多粒度的视觉表示,巧妙地平衡了视觉生成任务中的多样性与可控性。

大型语言模型(LLM)的出现统一了语言生成任务,并彻底改变了人机交互。然而,在图像生成领域,能够在单一框架内处理各种任务的统一模型在很大程度上仍未得到探索。近日,智源推出了新的扩散模型架构 OmniGen,一种新的用于统一图像生成的多模态模型。

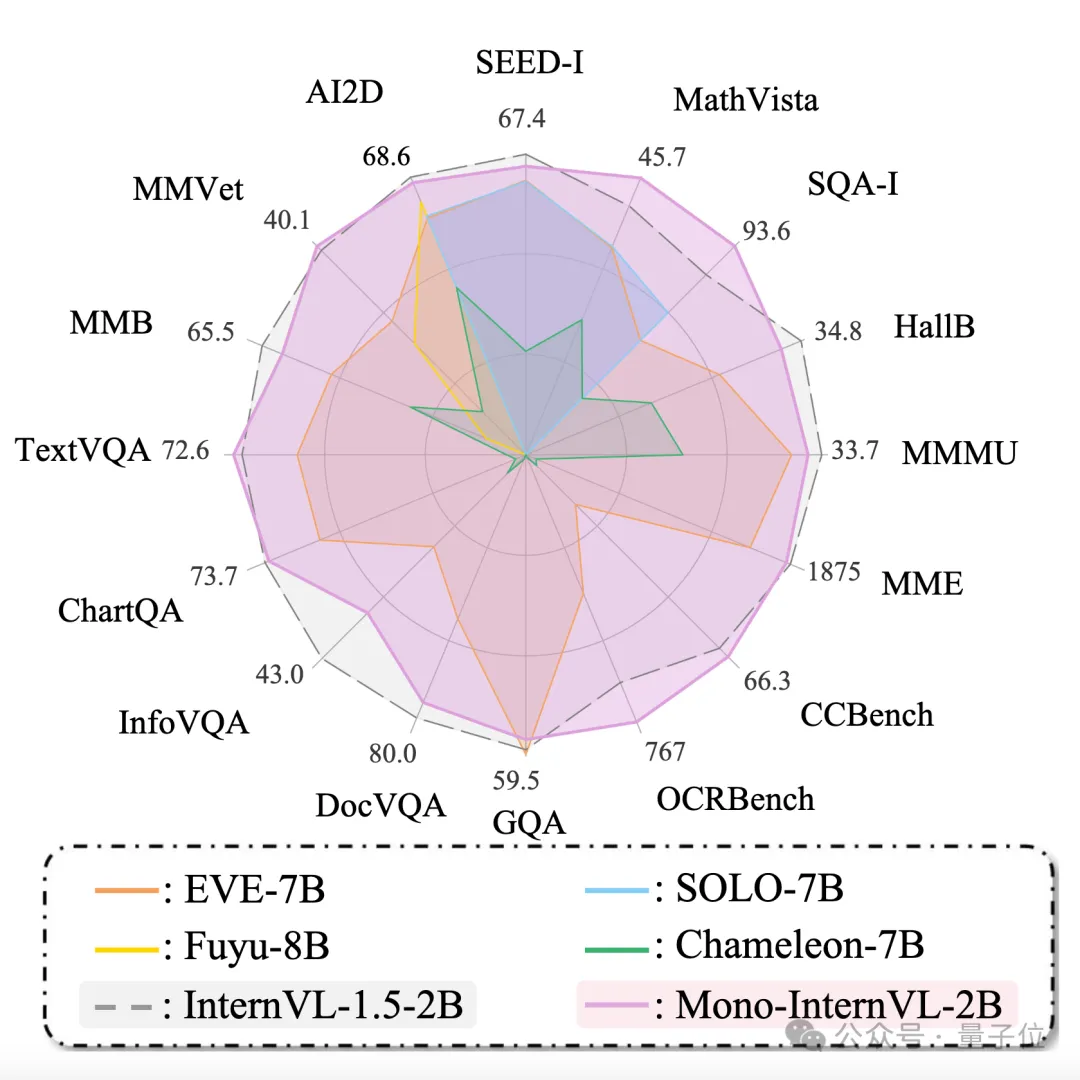

原生多模态大模型性能瓶颈,迎来新突破! 上海AI Lab代季峰老师团队,提出了全新的原生多模态大模型Mono-InternVL。 与非原生模型相比,该模型首个单词延迟最多降低67%,在多个评测数据集上均达到了SOTA水准。

北京大学的研究人员开发了一种新型多模态框架FakeShield,能够检测图像伪造、定位篡改区域,并提供基于像素和图像语义错误的合理解释,可以提高图像伪造检测的可解释性和泛化能力。

西安电子科大、上海AI Lab等提出多模态融合检测算法E2E-MFD,将图像融合和目标检测整合到一个单阶段、端到端框架中,简化训练的同时,提升目标解析性能。 相关论文已入选顶会NeurlPS 2024 Oral,代码、模型均已开源。