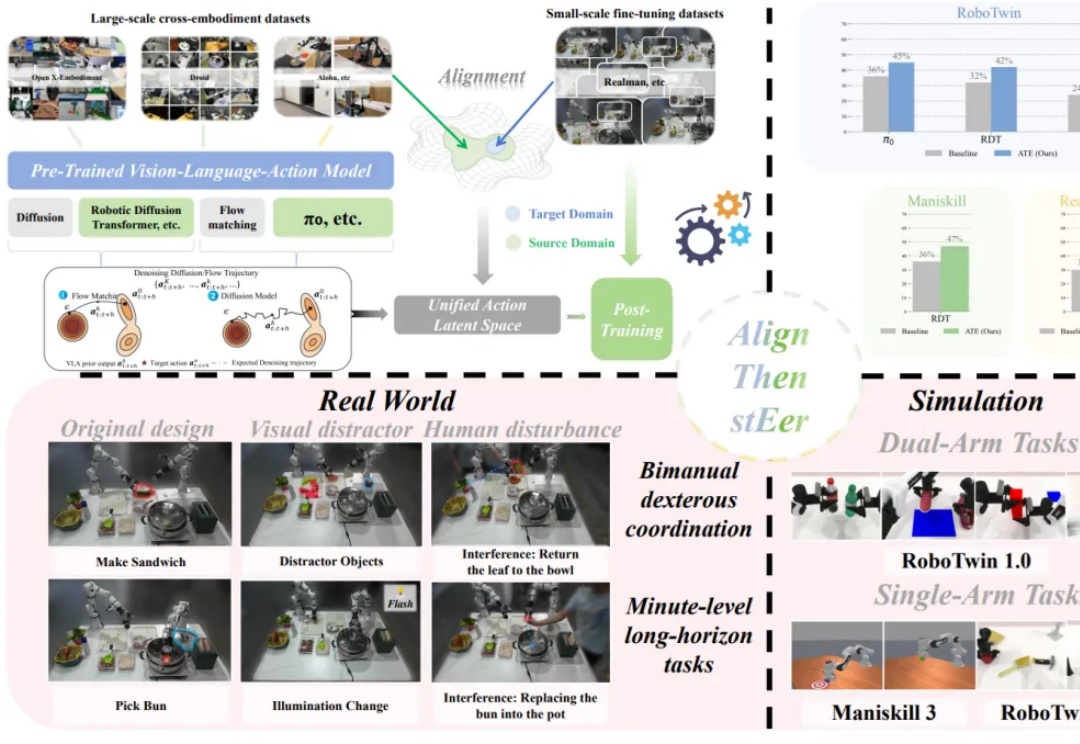

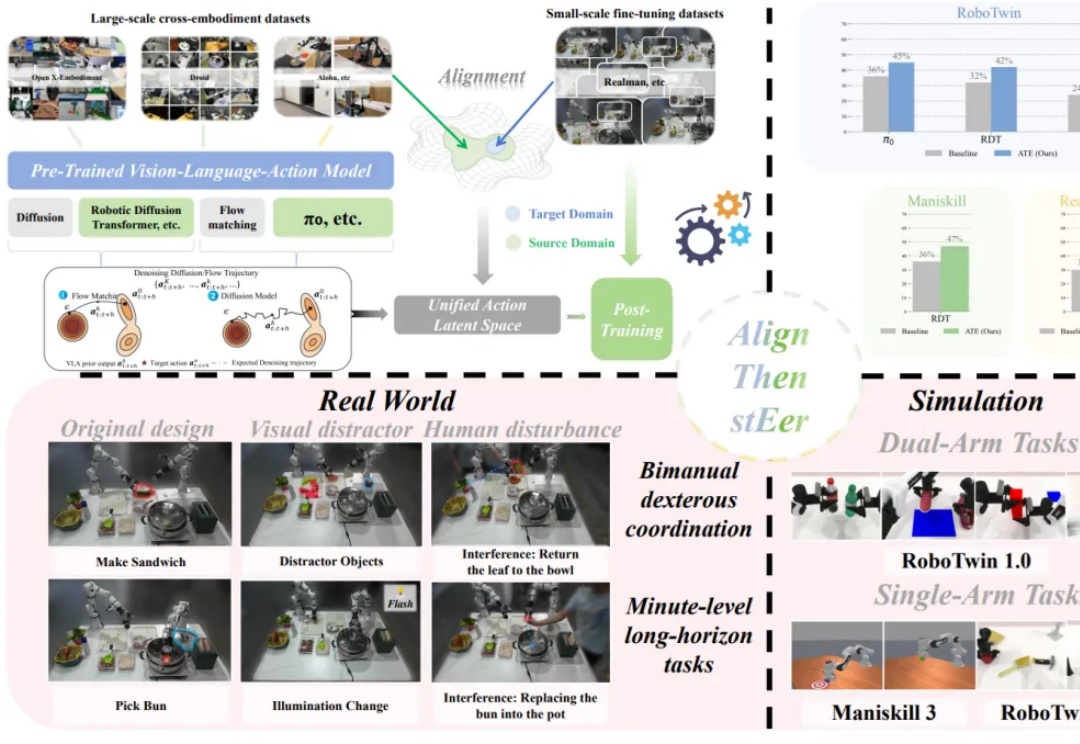

具身VLA后训练:TeleAI提出潜空间引导的VLA跨本体泛化方法

具身VLA后训练:TeleAI提出潜空间引导的VLA跨本体泛化方法在多模态大模型的基座上,视觉 - 语言 - 动作(Visual-Language-Action, VLA)模型使用大量机器人操作数据进行预训练,有望实现通用的具身操作能力。

在多模态大模型的基座上,视觉 - 语言 - 动作(Visual-Language-Action, VLA)模型使用大量机器人操作数据进行预训练,有望实现通用的具身操作能力。

近年来,生成式 AI 和多模态大模型在各领域取得了令人瞩目的进展。然而,在现实世界应用中,动态环境下的数据分布和任务需求不断变化,大模型如何在此背景下实现持续学习成为了重要挑战

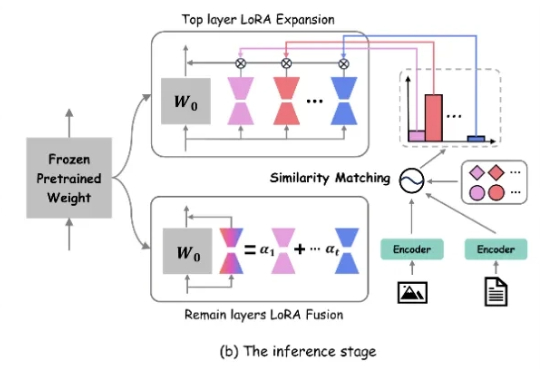

近期,多模态大模型在图像问答与视觉理解等任务中进展迅速。随着 Vision-R1 、MM-Eureka 等工作将强化学习引入多模态推理,数学推理也得到了一定提升。

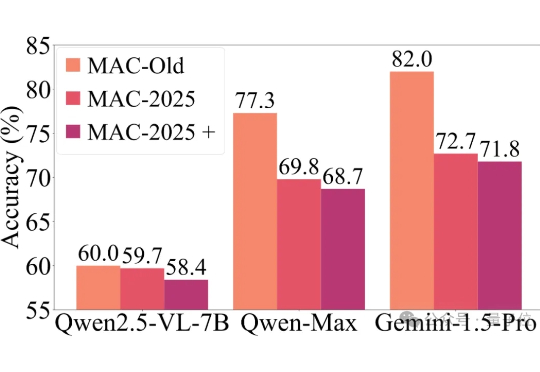

近年来,以GPT-4o、Gemini 2.5 Pro为代表的多模态大模型,在各大基准测试(如MMMU)中捷报频传,纷纷刷榜成功。

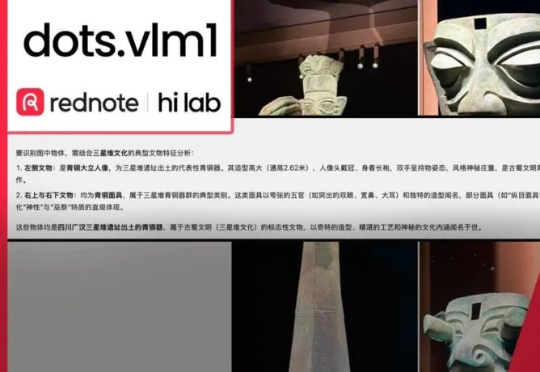

擅长「种草」的小红书正加大技术自研力度,两个月内接连开源三款模型!最新开源的首个多模态大模型dots.vlm1,基于自研视觉编码器构建,实测看穿色盲图,破解数独,解高考数学题,一句话写李白诗风,视觉理解和推理能力都逼近Gemini 2.5 Pro闭源模型。

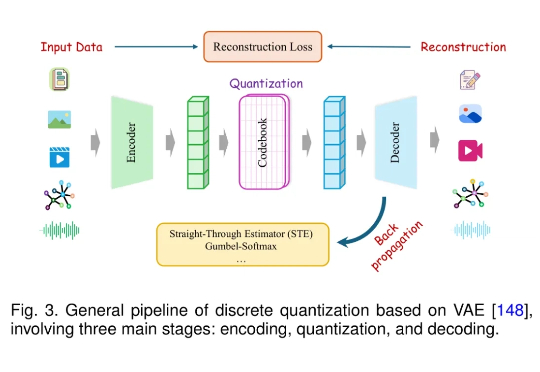

近年来,大语言模型(LLM)在语言理解、生成和泛化方面取得了突破性进展,并广泛应用于各种文本任务。随着研究的深入,人们开始关注将 LLM 的能力扩展至非文本模态,例如图像、音频、视频、图结构、推荐系统等。

当马斯克的 Grok-4 还在用 “幽默模式” 讲冷笑话时,中国的科学家已经在用书生 Intern-S1 默默破解癌症药物靶点的密码 —— 谁说搞科研不能又酷又免费?

WAIC大会上,这个机器人凭惊艳实力引起了层层围观!叠衣服、分拣物品、听指令取货,他们研发的Mech-GPT多模态大模型和「眼脑手」系统,让机器人的高难度操作性能暴增。现在,这家公司已经成为市占率连续五年的行业冠军了。

AI教父Hinton中国首秀,在与周伯文教授的17分钟高密度对话中,他首次公开表示当今多模态大模型已具「意识」,并建议以不同技术训练「聪明」与「善良」AI。两人探讨AI主观体验、科学促进AI发展的路径,并寄语青年科研者:坚持怀疑与原创,突破才会发生。

在医学影像领域,AI的革命性进展已不稀奇——CT有了自动阅片系统,X光报告可由模型生成。但当聚光灯转向超声时,这一“最日常”的影像手段,却始终没有迎来真正的智能时代。为什么?