让GUI智能体不再「过度执行」,上海交大、Meta联合发布OS-Kairos系统

让GUI智能体不再「过度执行」,上海交大、Meta联合发布OS-Kairos系统本文第一作者是上海交通大学计算机学院三年级博士生程彭洲,研究方向为多模态大模型推理、AI Agent、Agent 安全等。通讯作者为张倬胜助理教授和刘功申教授。

本文第一作者是上海交通大学计算机学院三年级博士生程彭洲,研究方向为多模态大模型推理、AI Agent、Agent 安全等。通讯作者为张倬胜助理教授和刘功申教授。

又一家A股上市公司冲刺“A+H”!6月26日,上海AI产品公司合合信息递表港交所。招股书显示,合合信息是一家原生AI(AI-native)公司,已成为全球多模态大模型文本智能技术的领先者,业务已覆盖全球超过200个国家和地区,3款C端产品拥有数亿全球用户群,是少有的同时在中国和全球拥有成规模用户量的原生AI公司。

本周五凌晨,谷歌正式发布、开源了全新端侧多模态大模型 Gemma 3n。谷歌表示,Gemma 3n 代表了设备端 AI 的重大进步,它为手机、平板、笔记本电脑等端侧设备带来了强大的多模式功能,其性能去年还只能在云端先进模型上才能体验。

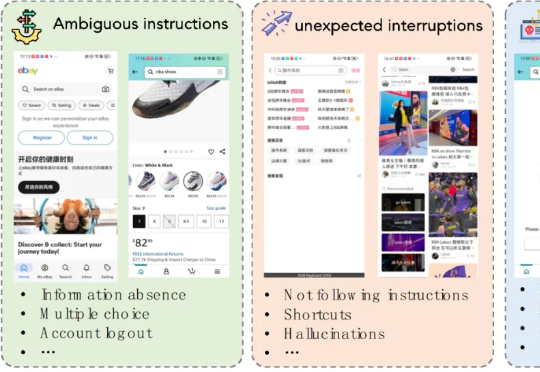

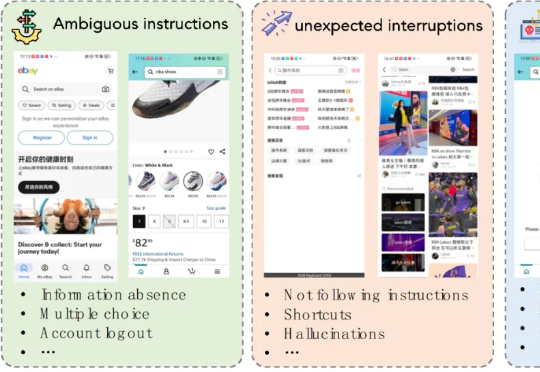

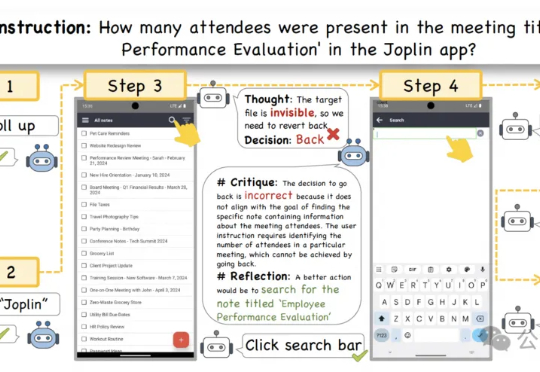

GUI智能体总是出错, 甚至是不可逆的错误。 即使是像GPT-4o这样的顶级多模态大模型,也会因为缺乏常识而在执行GUI任务时犯错。在它即将执行错误决策时,需要有人提醒它出错了。

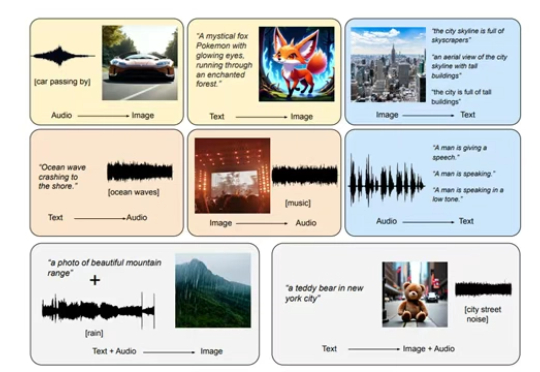

随着大模型的不断发展,多模态数据处理成为了新的热点领域。多模态生成任务主要通过整合多种类型的数据,如文本、图像、音频等,实现不同模态之间的相互转换与生成。

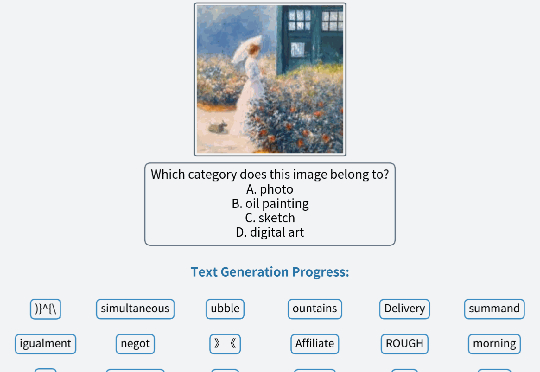

在金融科技智能化转型进程中,大语言模型以及多模态大模型(LVLM)正成为核心技术驱动力。尽管 LVLM 展现出卓越的跨模态认知能力

王劲,香港大学计算机系二年级博士生,导师为罗平老师。研究兴趣包括多模态大模型训练与评测、伪造检测等,有多项工作发表于 ICML、CVPR、ICCV、ECCV 等国际学术会议。

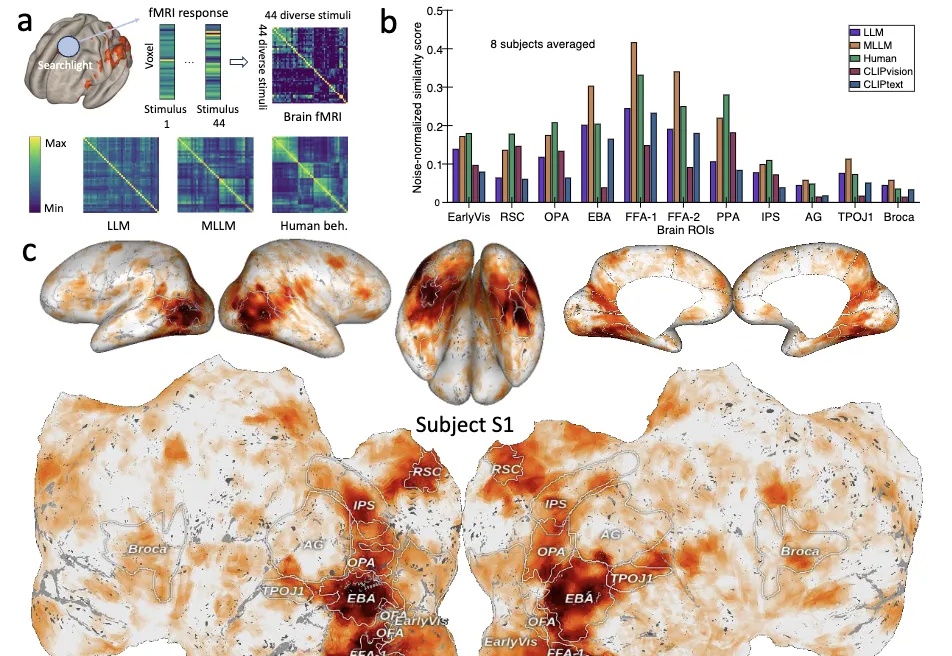

大模型≠随机鹦鹉!Nature子刊最新研究证明: 大模型内部存在着类似人类对现实世界概念的理解。

本文第一作者为前阿里巴巴达摩院高级技术专家,现一年级博士研究生满远斌,研究方向为高效多模态大模型推理和生成系统。通信作者为第一作者的导师,UTA 计算机系助理教授尹淼。尹淼博士目前带领 7 人的研究团队,主要研究方向为多模态空间智能系统,致力于通过软件和系统的联合优化设计实现空间人工智能的落地。

近年来,大语言模型(LLMs)以及多模态大模型(MLLMs)在多种场景理解和复杂推理任务中取得突破性进展。