本文第一作者为前阿里巴巴达摩院高级技术专家,现一年级博士研究生满远斌,研究方向为高效多模态大模型推理和生成系统。通信作者为第一作者的导师,UTA 计算机系助理教授尹淼。尹淼博士目前带领 7 人的研究团队,主要研究方向为多模态空间智能系统,致力于通过软件和系统的联合优化设计实现空间人工智能的落地。

近年来,大语言模型(LLM)持续刷新着多模态理解的边界。当语言模型具备了「看视频」的能力,视频问答、视频摘要和字幕生成等任务正逐步迈入真正的智能阶段。但一个现实难题亟待解决——如何高效理解超长视频?

为此,来自得克萨斯大学阿灵顿分校(UTA)计算机系研究团队提出了 AdaCM2:首个支持超长视频理解的跨模态记忆压缩框架。该研究已被 CVPR 2025 正式接收,并荣获 Highlight 论文(接收率为 3%),展示出其在技术创新与实际价值上的双重突破。

背景:LLM 强大,长视频理解却步

多模态视频理解模型如 VideoLLaMA、VideoChat 等已经在短视频(5–15 秒)场景中表现优异,能够回答关于视频内容的自然语言问题。但当视频长度扩展至分钟级甚至小时级,模型的显存瓶颈和冗余信息干扰问题暴露无遗:

AdaCM2 正是为解决这些核心问题而生。

提出动机:两大关键观察揭示「压缩冗余」的机会

AdaCM2 的提出建立在对视频与文本交互过程中的两个核心观察基础上,揭示了现有模型在超长视频场景下的内在局限:

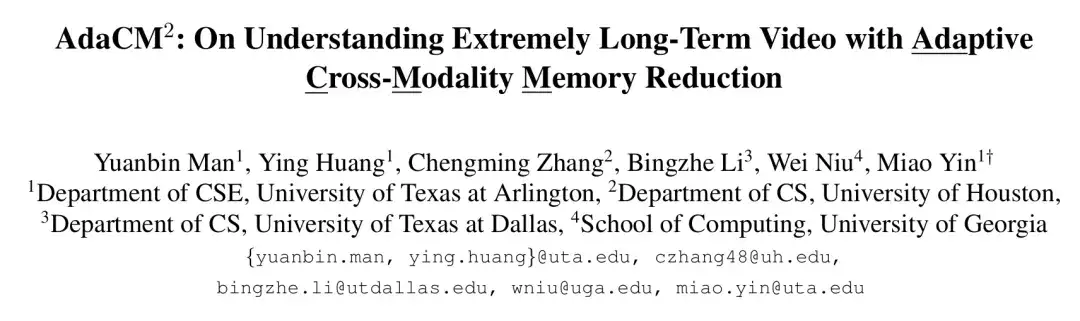

观察一:帧内注意力稀疏性(Intra-Frame Sparsity)

在长视频的任意一帧中,只有极少数视觉 Token 对当前文本提示具有强相关性。绝大多数视觉信息对于回答文本问题(如「她在和谁说话?」)是无关的。实验发现,这些注意力得分呈现出尾部偏置分布,意味着高价值信息集中在少数 Token 中。

启发: 可以有选择性地仅保留「重要的」视觉 Token,而无需一视同仁处理全部帧内容。

观察二:层间语义冗余性(Layer-Wise Redundancy)

研究还发现,在深层网络中,临近帧之间的跨模态注意力相似度非常高,甚至在间隔较远的帧之间也存在冗余。这种高相似性意味着:多个 Token 在不同时间或不同层次上表达了重复的语义信息。

启发: 应该在不同层次上使用差异化的压缩策略,从而动态平衡信息保留与内存占用。

这两大观察构成了 AdaCM2 设计的基础,驱动出一整套可调、可解释、可扩展的「视频记忆管理机制」。

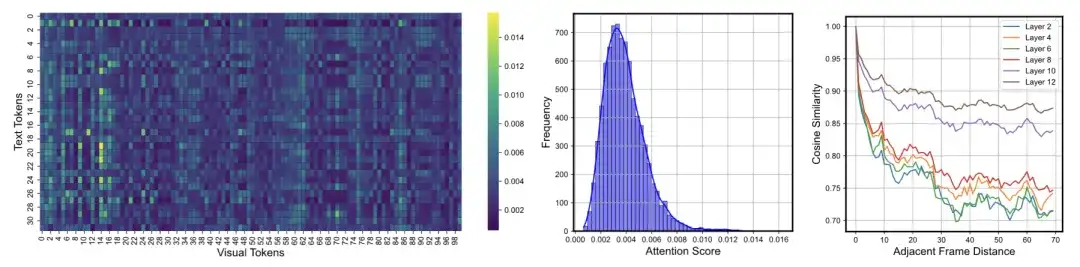

创新:AdaCM2 提出跨模态动态压缩机制

为应对长视频带来的内存挑战,AdaCM2 首次引入了跨模态注意力驱动的层级记忆压缩策略。其核心思想是:「仅保留那些对文本提示最有意义的视觉信息」,并通过跨层级的策略自适应完成压缩,确保模型不丢关键信息。

关键技术点:

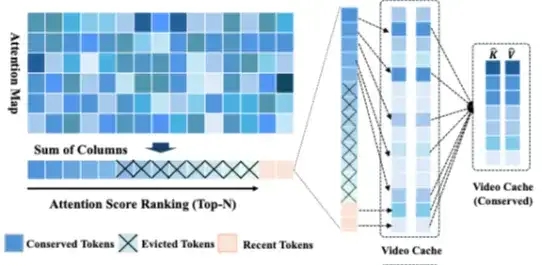

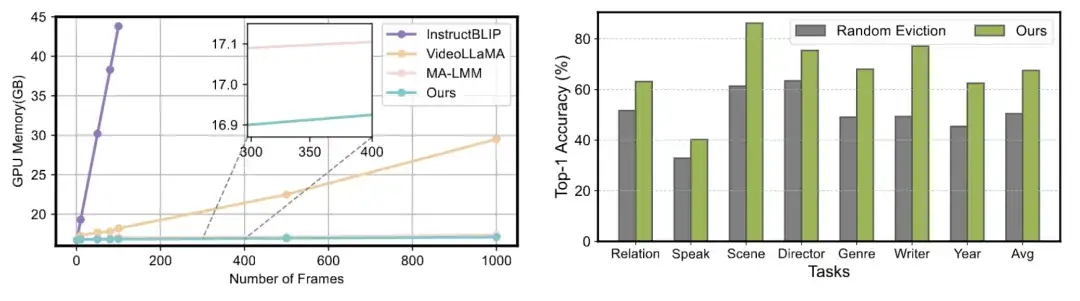

实验结果:性能超越 SOTA + 显存下降 65%

AdaCM2 在多个长视频标准数据集上进行了验证,包括:

消融研究也显示,若移除跨模态压缩模块或将其替换为随机丢弃,模型性能将显著下降,证明观察驱动设计的有效性。

应用前景:多模态大模型的「长时记忆」引擎

AdaCM2 的提出,为多模态模型赋予了「可控的长时记忆能力」。这一能力不仅适用于传统的视频理解任务,还对以下未来应用场景具有重要意义:

总结

AdaCM2 作为首个专注于极长视频理解的跨模态记忆压缩框架,在大语言模型和视觉编码器之间架起了一座高效的信息筛选桥梁。它不仅优化了计算资源利用率,还拓展了多模态 AI 在实际应用中的边界。随着多模态大模型逐步走向落地,AdaCM2 的提出无疑将成为推动长视频智能理解发展的关键技术。

该论文已被 CVPR 2025 接收并评为 Highlight 论文,充分体现其在长视频多模态建模领域的前瞻性与影响力。更多相关研究成果也即将在未来发布,敬请关注!

文章来自公众号“机器之心”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner