多模态模型免微调接入互联网,即插即用新框架,效果超闭源商用方案

多模态模型免微调接入互联网,即插即用新框架,效果超闭源商用方案一个5月份完成训练的大模型,无法对《黑神话·悟空》游戏内容相关问题给出准确回答。

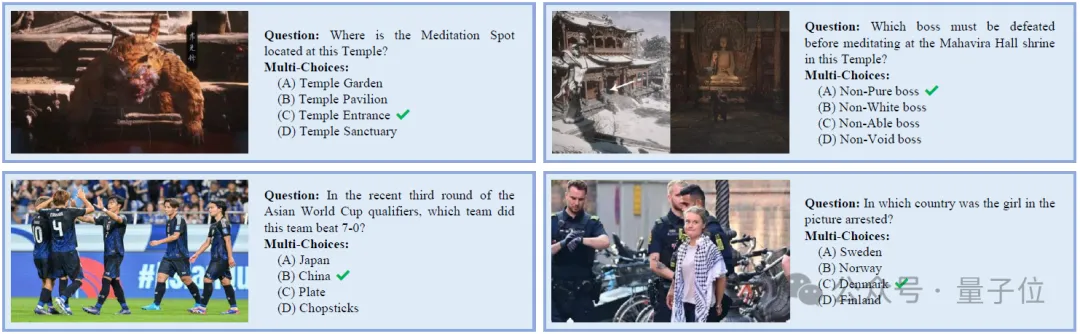

一个5月份完成训练的大模型,无法对《黑神话·悟空》游戏内容相关问题给出准确回答。

MME-Finance 是一个专为金融领域设计的多模态基准测试,由同花顺财经旗下的 HiThink 研究团队联合多家高校共同开发,旨在评估和提升多模态大型语言模型(MLLMs)在金融领域的专业理解和推理能力。

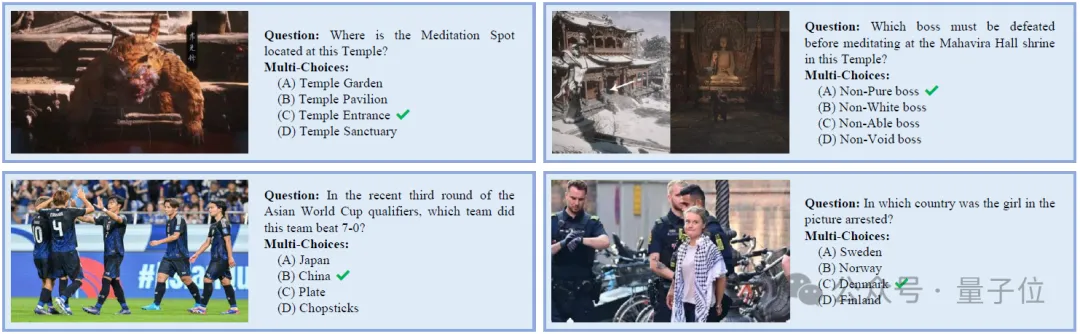

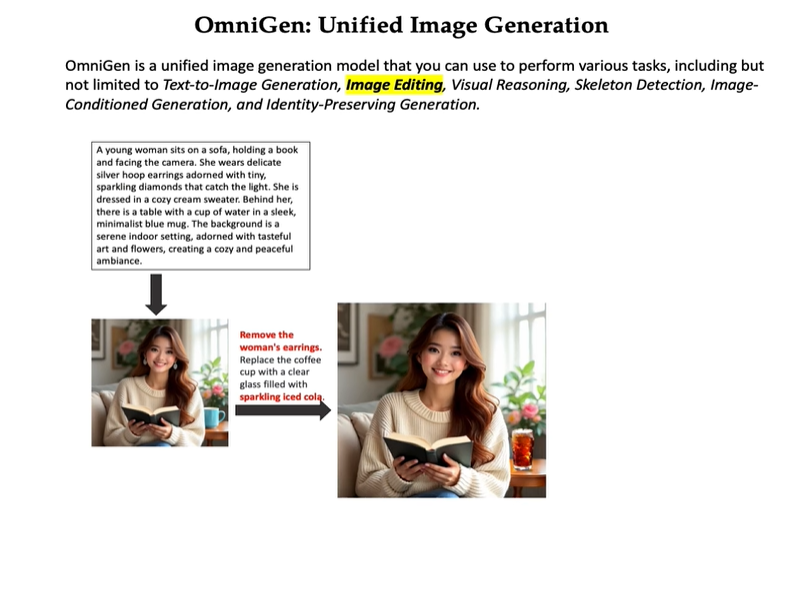

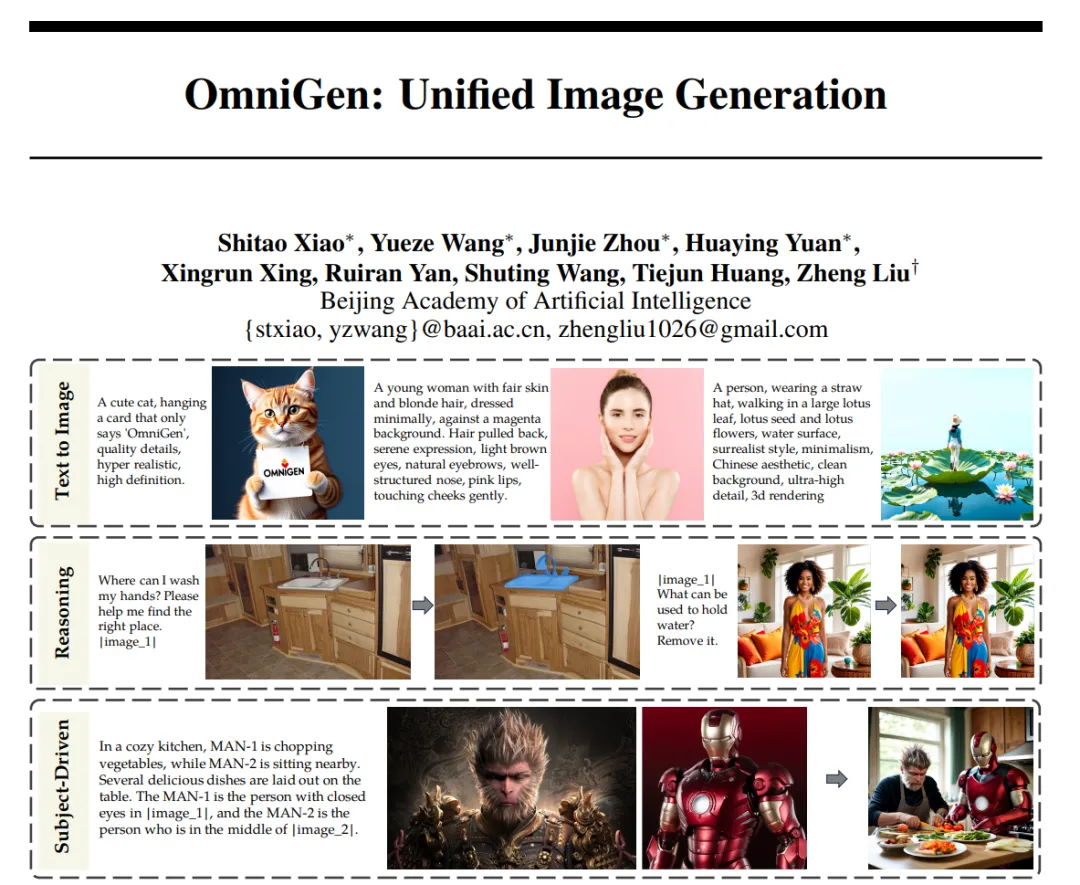

多模态模型,统一图像生成。

大型语言模型(LLM)的出现统一了语言生成任务,并彻底改变了人机交互。然而,在图像生成领域,能够在单一框架内处理各种任务的统一模型在很大程度上仍未得到探索。近日,智源推出了新的扩散模型架构 OmniGen,一种新的用于统一图像生成的多模态模型。

两位清华校友,在OpenAI发布最新研究—— 生成图像,但速度是扩散模型的50倍。 路橙、宋飏再次简化了一致性模型,仅用两步采样,就能使生成质量与扩散模型相媲美。

OpenAI 前首席科学家、联合创始人 Ilya Sutskever 曾在多个场合表达观点:只要能够非常好的预测下一个 token,就能帮助人类达到通用人工智能(AGI)。

多模态大语言模型(MLLM)如今已是大势所趋。 过去的一年中,闭源阵营的GPT-4o、GPT-4V、Gemini-1.5和Claude-3.5等模型引领了时代。

如果您正在探寻人工智能未来的辉煌篇章,那么答案就在这里。 OpenAI的领导者Sam Altman和Greg Brockman最近表示:“现在正是我们展望未来的最佳时机。”他们预见了一个新时代,用户将不再只是与单一的模型对话,而是与由众多多模态模型和工具构成的系统互动,这些系统能够代表用户执行操作。

Molmo,开源多模态模型正在发力!

视觉数据的种类极其多样,囊括像素级别的图标到数小时的视频。现有的多模态大语言模型(MLLM)通常将视觉输入进行分辨率的标准化或进行动态切分等操作,以便视觉编码器处理。然而,这些方法对多模态理解并不理想,在处理不同长度的视觉输入时效率较低。