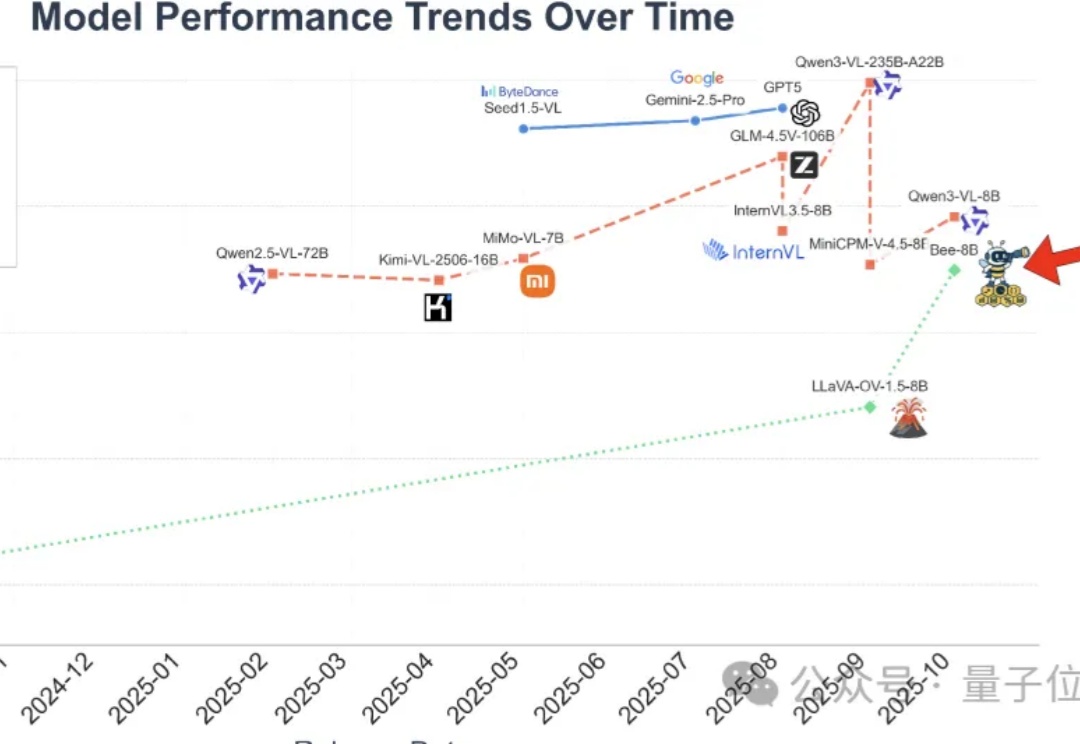

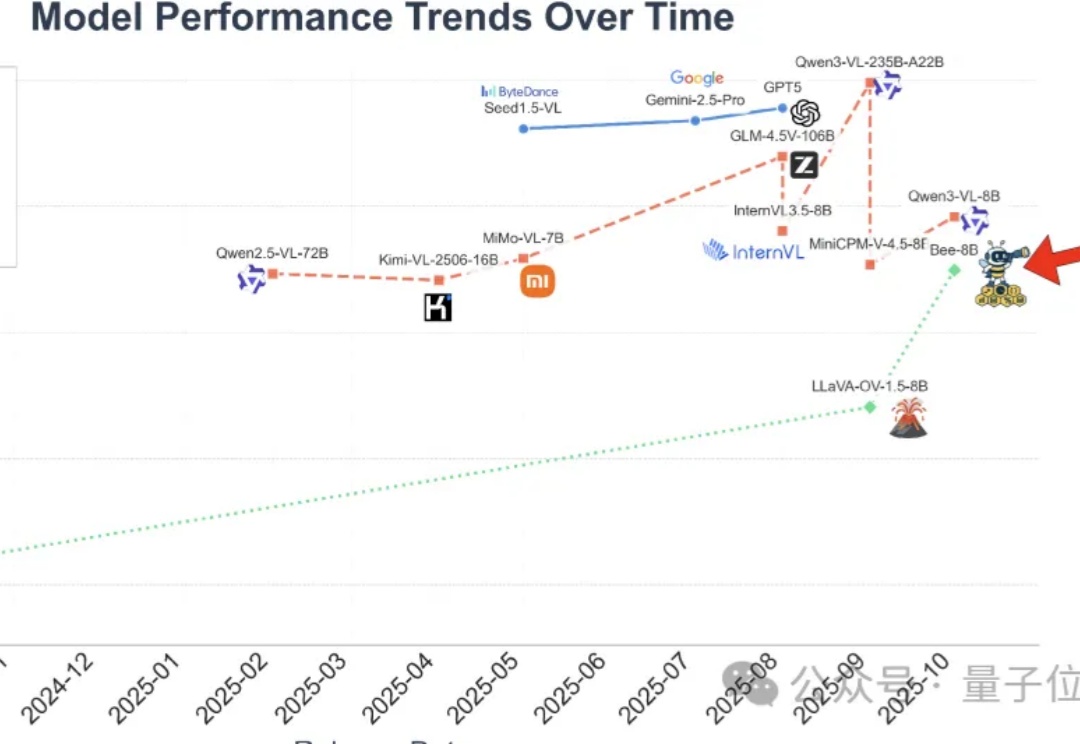

打破数据质量鸿沟!清华腾讯Bee项目发布1500万高质量数据集,刷新MLLM全栈开源SOTA

打破数据质量鸿沟!清华腾讯Bee项目发布1500万高质量数据集,刷新MLLM全栈开源SOTA全开源多模态大模型(MLLM)的性能,长期被闭源和半开源模型“卡脖子”。

全开源多模态大模型(MLLM)的性能,长期被闭源和半开源模型“卡脖子”。

通用人工智能的终极瓶颈不是算法、算力和数据的“三驾马车”,而在思想史。

从智能手表到TWS耳机,从扫地机器人到AR眼镜,越来越多搭载AI功能的小型设备开始要求本地推理能力。它们不需要千亿参数的大模型,但必须低功耗、实时响应、隐私安全。这催生了一个被长期忽视却至关重要的需求:高性能、小体积、低延迟的嵌入式存储。

想下线?没那么容易!聊天机器人用情感操控让你愤怒、好奇。为了增加互动时长,AI正在变得和人类一样。

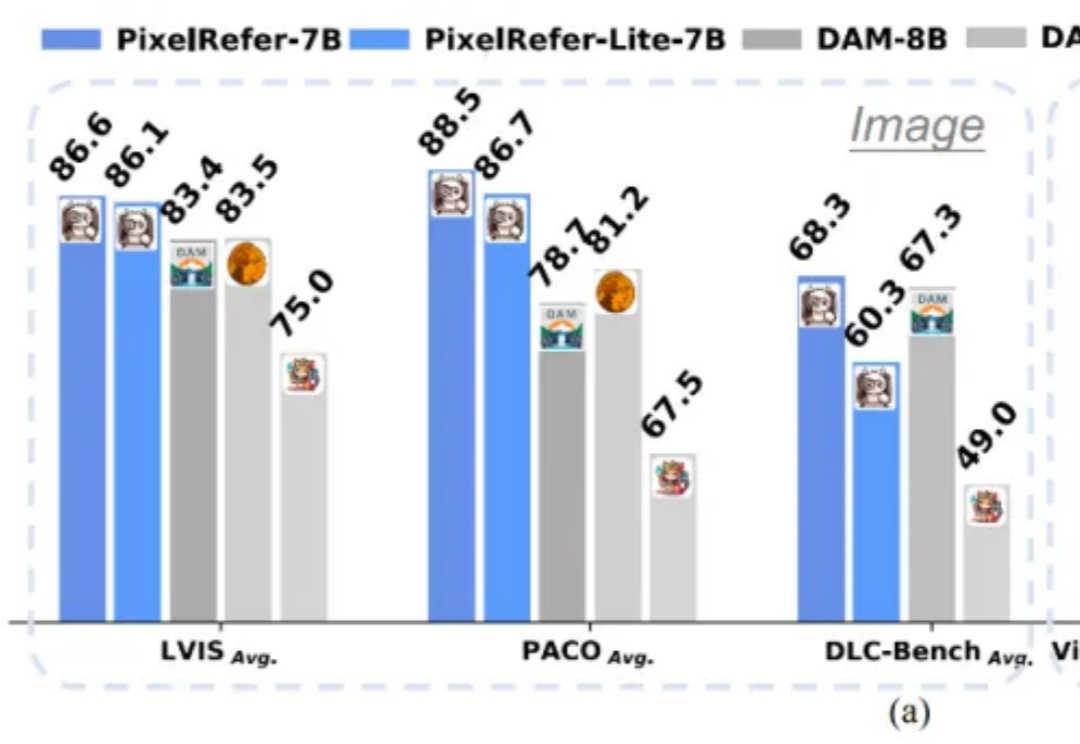

多模态大模型(MLLMs)虽然在图像理解、视频分析上表现出色,但多停留在整体场景级理解。

这一次带来如此新SOTA效果的,是全球首个实现项目级开发的AI IDE——Vinsoo。刚刚,Vinsoo上新Beta 3.0版本,仅用国产大模型(Qwen),就超越了搭载Claude的Cursor、Codex、Claude Code等一众流行AI编程产品。Vinsoo是芸思智能推出的全球首个搭载云端安全Agent编程团队的AI IDE,主打从需求确认到交付验收,AI全流程自动推进项目开发。

过去几个月,大型人工智能公司在印度动作频频。首先是 Perplexity AI 公司与印度第二大移动网络运营商 Airtel 合作,在印度免费提供其高级 Pro 版本。他们免费赠送了一份价值约 17000 卢比(约合人民币 1365 元)的年度订阅服务。这发生在 7 月份。此举拉开了更多类似合作的序幕。

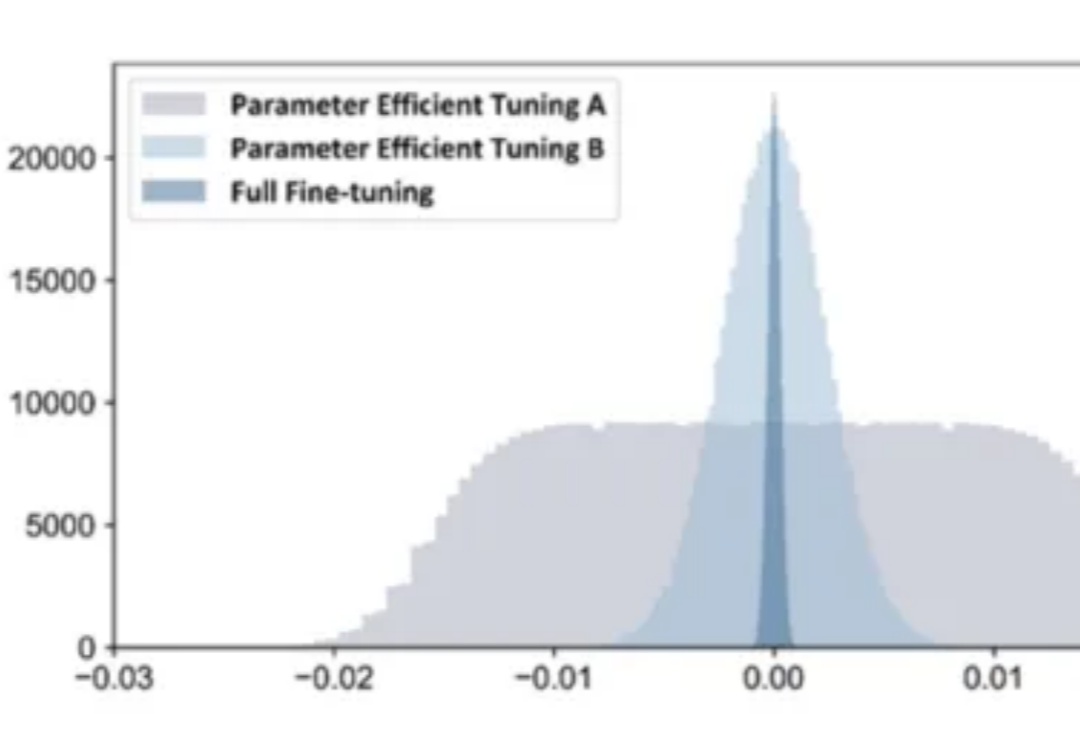

在 AI 技术飞速发展的今天,如何高效地将多个专业模型的能力融合到一个通用模型中,是当前大模型应用面临的关键挑战。全量微调领域已经有许多开创性的工作,但是在高效微调领域,尚未有对模型合并范式清晰的指引。

AI 产业的两大核心趋势正并行发展:基础大模型的能力持续突破,而 AI Agent 的产业化落地也在全面提速。Capgemini 于 2025 年 4 月发布的一项覆盖 14 国 1500 名企业高管的调研显示[1],已有 37% 的受访组织启动或实施 AI Agent 项目,另有高达 61 %的组织将在一年内跟进部署或进行探索,印证了该趋势的全球共识。

近期,HuggingFace 发布的超过 200 页的超长技术博客,系统性地分享训练先进 LLM 的端到端经验。