面向超长上下文,大语言模型如何优化架构,这篇综述一网打尽了

面向超长上下文,大语言模型如何优化架构,这篇综述一网打尽了作者重点关注了基于 Transformer 的 LLM 模型体系结构在从预训练到推理的所有阶段中优化长上下文能力的进展。

作者重点关注了基于 Transformer 的 LLM 模型体系结构在从预训练到推理的所有阶段中优化长上下文能力的进展。

拾象科技及其公众号「海外独角兽」一直关注海外大模型产品的技术和商业进展,近日,拾象科技 CEO 李广密和商业作者张小珺一起讨论了 2023 年全球大模型竞赛,以及接下来大模型格局会如何演进、GPT-4 的超越难度、以及需要解决的关键问题等。

2023年上半年人见人爱的大模型,逐渐“失宠”。前有百度创始人李彦宏说“重复开发大模型是资源浪费”,后有百川智能联合创始人洪涛说“99%的行业大模型都可能被替代”。

大模型领域最新的一个热门趋势是把模型塞到手机里。而最应该做这个研究的公司终于带着它的论文现身,那就是苹果。

大型语言模型(LLM)虽然在诸多下游任务上展现出卓越的能力,但其实际应用还存在一些问题。其中,LLM 的「幻觉(hallucination)」问题是一个重要缺陷。

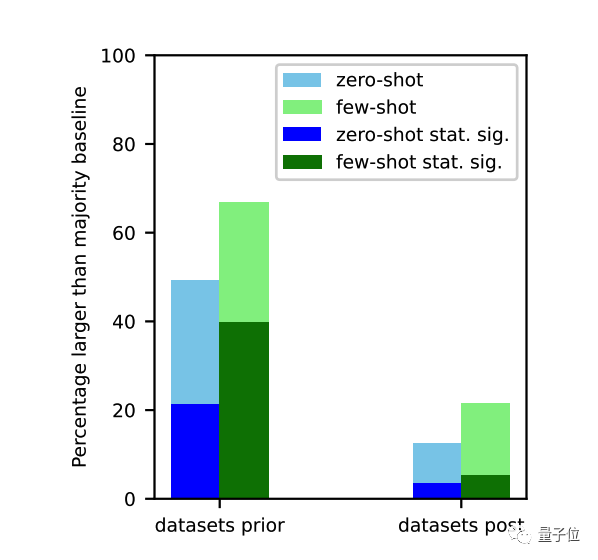

最近由UCSC的研究人员发表论文,证明大模型的零样本或者少样本能力,几乎都是来源于对于训练数据的记忆。

OpenAI最近官方放出了自己的提示工程指南,从大模型小白到开发者,都可以从中消化出不少营养。看看全世界最懂大模型的人,是怎么写提示词的。

华为盘古系列,带来架构层面上新!量子位获悉,华为诺亚方舟实验室等联合推出新型大语言模型架构:盘古-π。

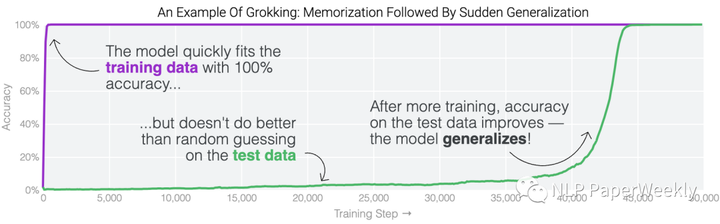

今天分享一篇符尧大佬的一篇数据工程(Data Engineering)的文章,解释了speed of grokking指标是什么,分析了数据工程

对于ChatGPT变笨原因,学术界又有了一种新解释。加州大学圣克鲁兹分校一项研究指出:在训练数据截止之前的任务上,大模型表现明显更好。