Ilya警告、LeCun冷嘲、奥特曼沉默:Scaling Law时代还能走多远?

Ilya警告、LeCun冷嘲、奥特曼沉默:Scaling Law时代还能走多远?过去10年,AI大模型的技术本质,是把电力能源通过计算过程转化为可复用的智能。2026年,我们需要让AI模型在单位时间内「吃下」更多能源,并真正将其转化为智能。

过去10年,AI大模型的技术本质,是把电力能源通过计算过程转化为可复用的智能。2026年,我们需要让AI模型在单位时间内「吃下」更多能源,并真正将其转化为智能。

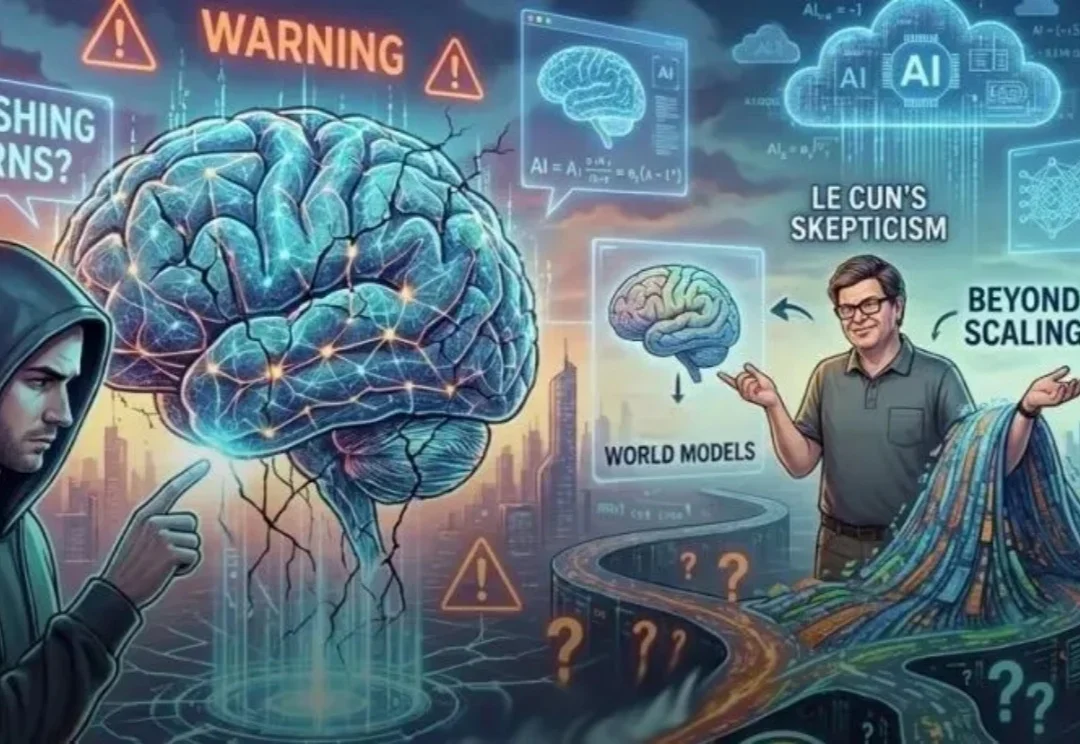

在生成式 AI 技术日新月异的背景下,合成语音的逼真度已达到真假难辨的水平,随之而来的语音欺诈与信息伪造风险也愈演愈烈。作为应对手段,语音鉴伪技术已成为信息安全领域的研究重心。

第一批AI大模型公司上市潮来了,先冲线的两家公司MiniMax、智谱揭开了自己的底牌。

作为一名 AI 领域的博士生,徐玉庄的经历比较特殊。本科毕业于国防科技大学,随后在部队工作了 5 年,接着在清华大学获得硕士学位,目前在哈尔滨工业大学读博。

快手大模型掌舵人,被曝出即将离职!今天,多个媒体爆料,快手副总裁、基础大模型及推荐模型负责人周国睿即将离职。关于周国睿下一步去向,也成了谜团:据传他将加入Meta,也有消息称,他可能会转投TikTok,具体不得而知。

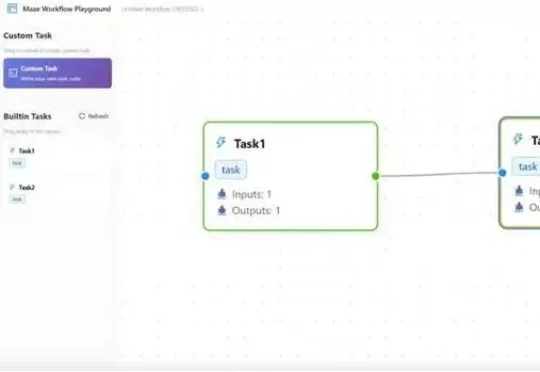

在大模型智能体(LLM Agent)落地过程中,复杂工作流的高效执行、资源冲突、跨框架兼容、分布式部署等问题一直困扰着开发者。而一款名为Maze的分布式智能体工作流框架,正以任务级精细化管理、智能资源调度、多场景部署支持等核心优势,为这些痛点提供一站式解决方案。

全球大模型第一股,最后百米冲刺。刚刚,智谱正式启动招股,股票代码2513(AI我一生~)。预计将于2026年1月8日在港交所主板挂牌上市。据披露,本次IPO募资总额预计约43亿港元,上市后市值预计超过511亿港元。

第二款大厂出品的生活服务类AI原生应用来了!

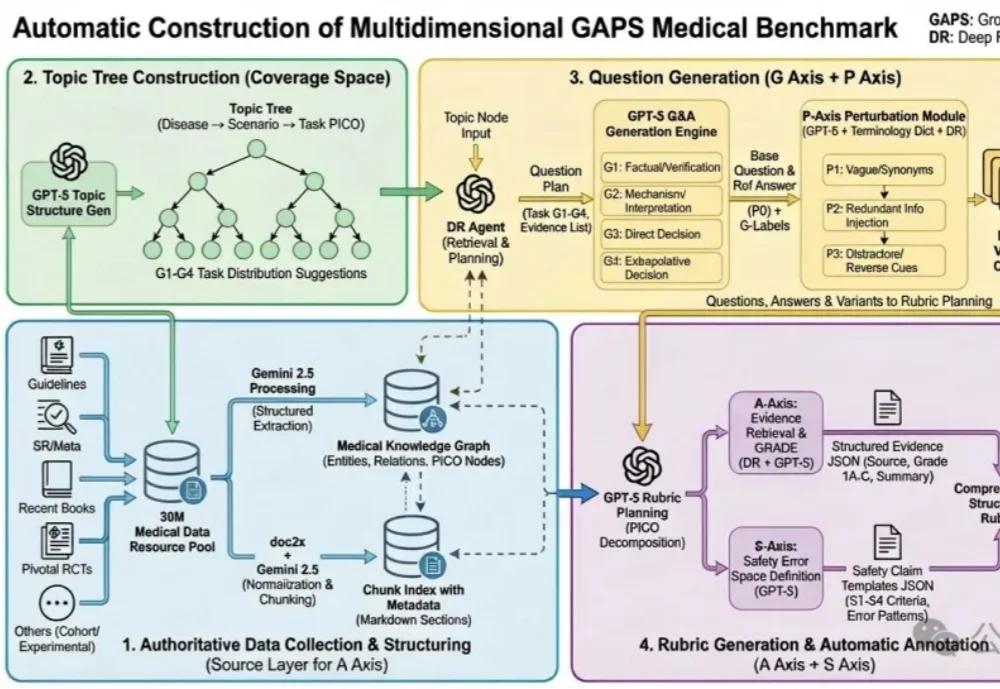

蚂蚁健康与北京大学人民医院王俊院士团队历时6个多月,联合十余位胸外科医生共同打磨,发布了全球首个大模型专病循证能力的评测框架—— GAPS(Grounding, Adequacy, Perturbation, Safety),及其配套评测集 GAPS-NSCLC-preview。

如果一项任务主要涉及文本处理,并且你拥有完善的数据渠道,能够获取完成该任务所需的全部文本信息,那么人工智能完成这项任务的难度就会较低。