把超算装进背包:ThinkStation PGX重新定义AI开发者的生产力边界

把超算装进背包:ThinkStation PGX重新定义AI开发者的生产力边界随着AI浪潮的袭来,笔者本人以及团队都及时的调整了业务方向,转型为一名AI开发者和AI产品开发团队,常常需要微调大模型注入业务场景依赖的私域知识,然后再把大模型部署上线进行推理,以支撑业务智能体或智能问答产品的逻辑流程。

来自主题: AI资讯

7117 点击 2026-01-22 11:58

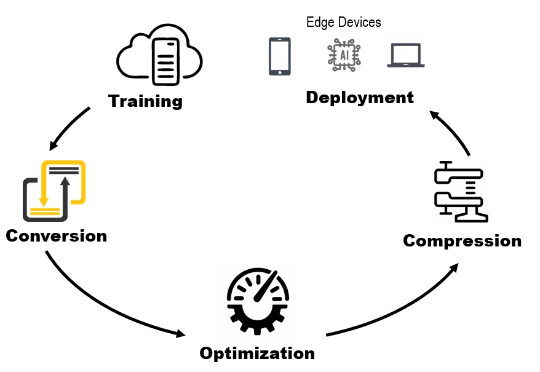

随着AI浪潮的袭来,笔者本人以及团队都及时的调整了业务方向,转型为一名AI开发者和AI产品开发团队,常常需要微调大模型注入业务场景依赖的私域知识,然后再把大模型部署上线进行推理,以支撑业务智能体或智能问答产品的逻辑流程。

AI公务员的大脑就是政务大模型。 就在刚刚,中央网信办和国。就在刚刚,中央网信办和国家发展改革委联合印发了重磅文件——《政务领域人工智能大模型部署应用指引》(我们后面就叫它《指引》)。

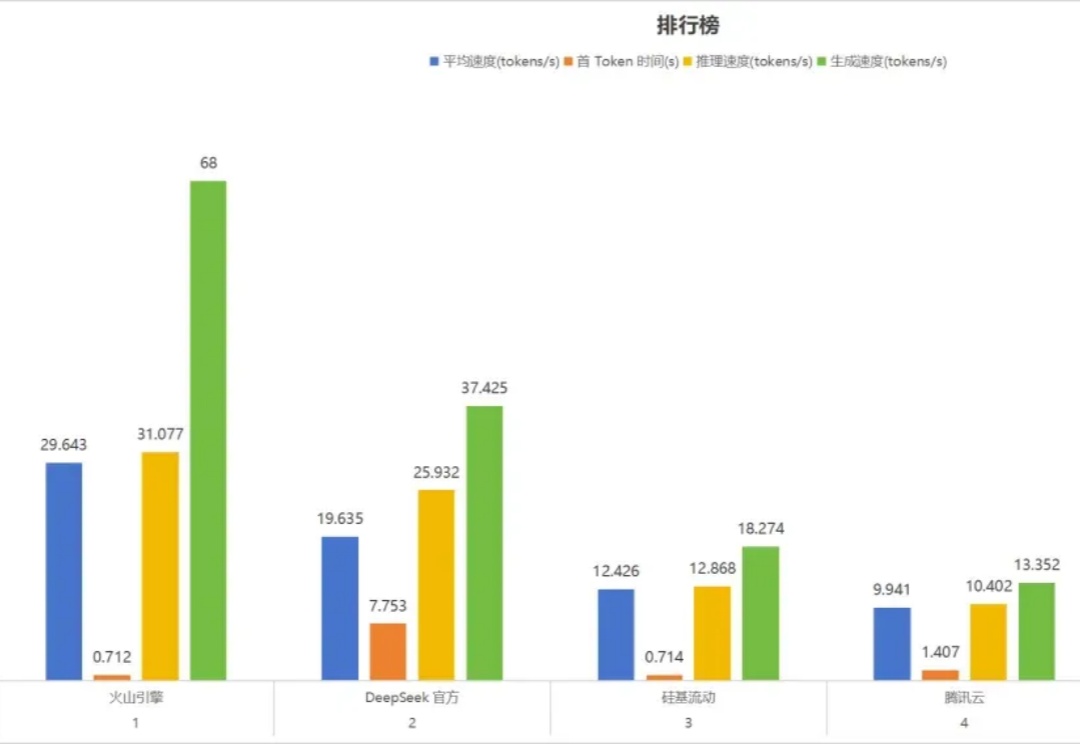

为什么 DeepSeek-V3 据说在大规模服务时快速且便宜,但本地运行时却太慢且昂贵?为什么有些 AI 模型响应很慢,但一旦开始运行就变得很快?

AI非上云不可、非集群不能?万字实测告诉你,32B卡不卡?70B是不是智商税?要几张卡才能撑住业务? 全网最全指南教你如何用最合适的配置,跑出最强性能。

部署 DeepSeek 系列模型,尤其是推理模型 DeepSeek-R1,已经成为一股不可忽视的潮流。