对话 Nexa AI:两位斯坦福95后,做出比GPT-4o快4倍的小模型,直指“端侧版Hugging Face”

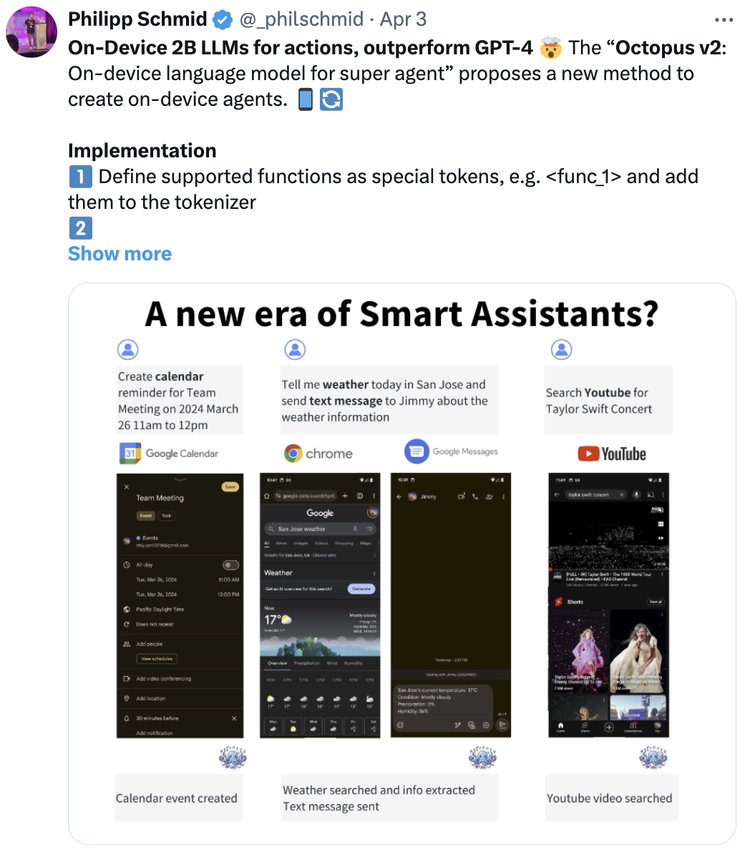

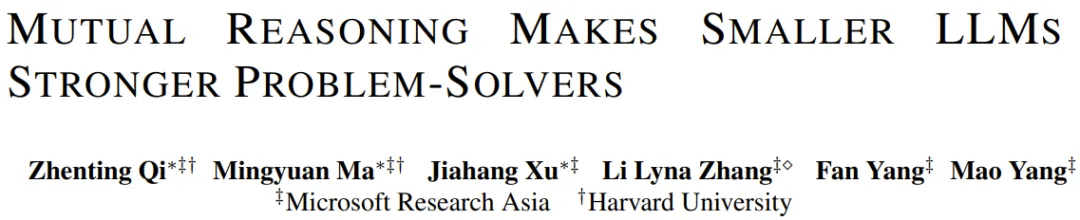

对话 Nexa AI:两位斯坦福95后,做出比GPT-4o快4倍的小模型,直指“端侧版Hugging Face”比OpenAI最强的GPT-4o更快,函数调用能力与GPT-4相当,同时比它小N倍,且只需要一张卡来做推理。

比OpenAI最强的GPT-4o更快,函数调用能力与GPT-4相当,同时比它小N倍,且只需要一张卡来做推理。

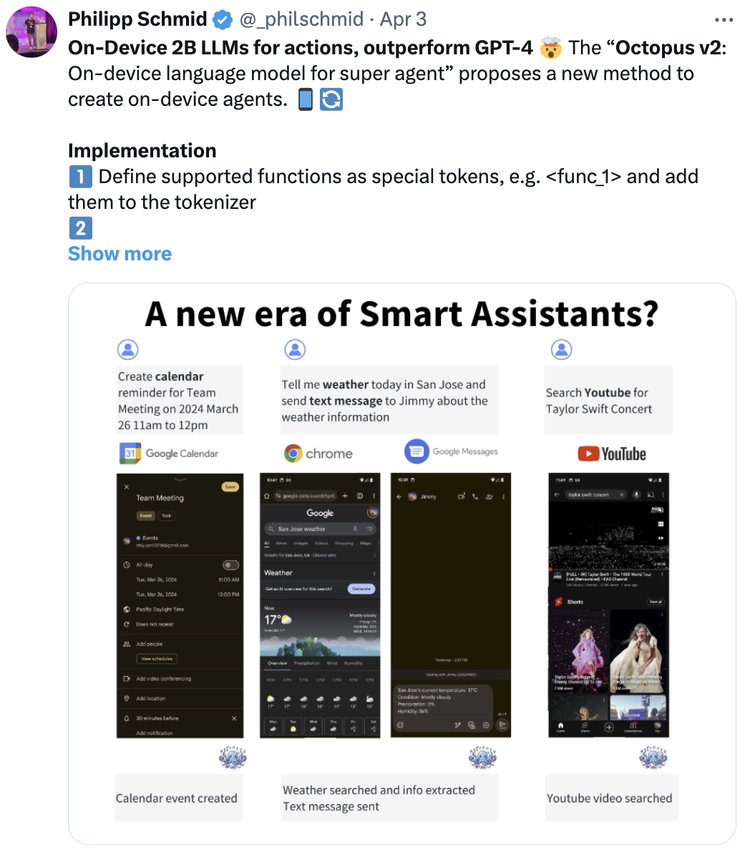

浏览器里直接能跑的SOTA小模型来了,分别在2亿、5亿和20亿级别获胜,抱抱脸出品。

互相检查,让小模型也能解决大问题。

小模型崛起了。

有CPU就能跑大模型,性能甚至超过NPU/GPU!

靴子终于落地,OpenAI的AI搜索还是来了。7月26日,就在推出小模型GPT-4o mini的一周后,OpenAI方面公布了备受外界关注的搜索产品SearchGPT。尽管目前SearchGPT仅向10000名测试用户开放,但OpenAI CTO Mira Murati在社交平台已经透露,最终目标是将搜索功能直接整合到ChatGPT中。

今年 6 月底,谷歌开源了 9B、27B 版 Gemma 2 模型系列,并且自亮相以来,27B 版本迅速成为了大模型竞技场 LMSYS Chatbot Arena 中排名最高的开放模型之一,在真实对话任务中比其两倍规模以上的模型表现还要好。

谷歌DeepMind的小模型核弹来了,Gemma 2 2B直接击败了参数大几个数量级的GPT-3.5和Mixtral 8x7B!而同时发布的Gemma Scope,如显微镜一般打破LLM黑箱,让我们看清Gemma 2是如何决策的。

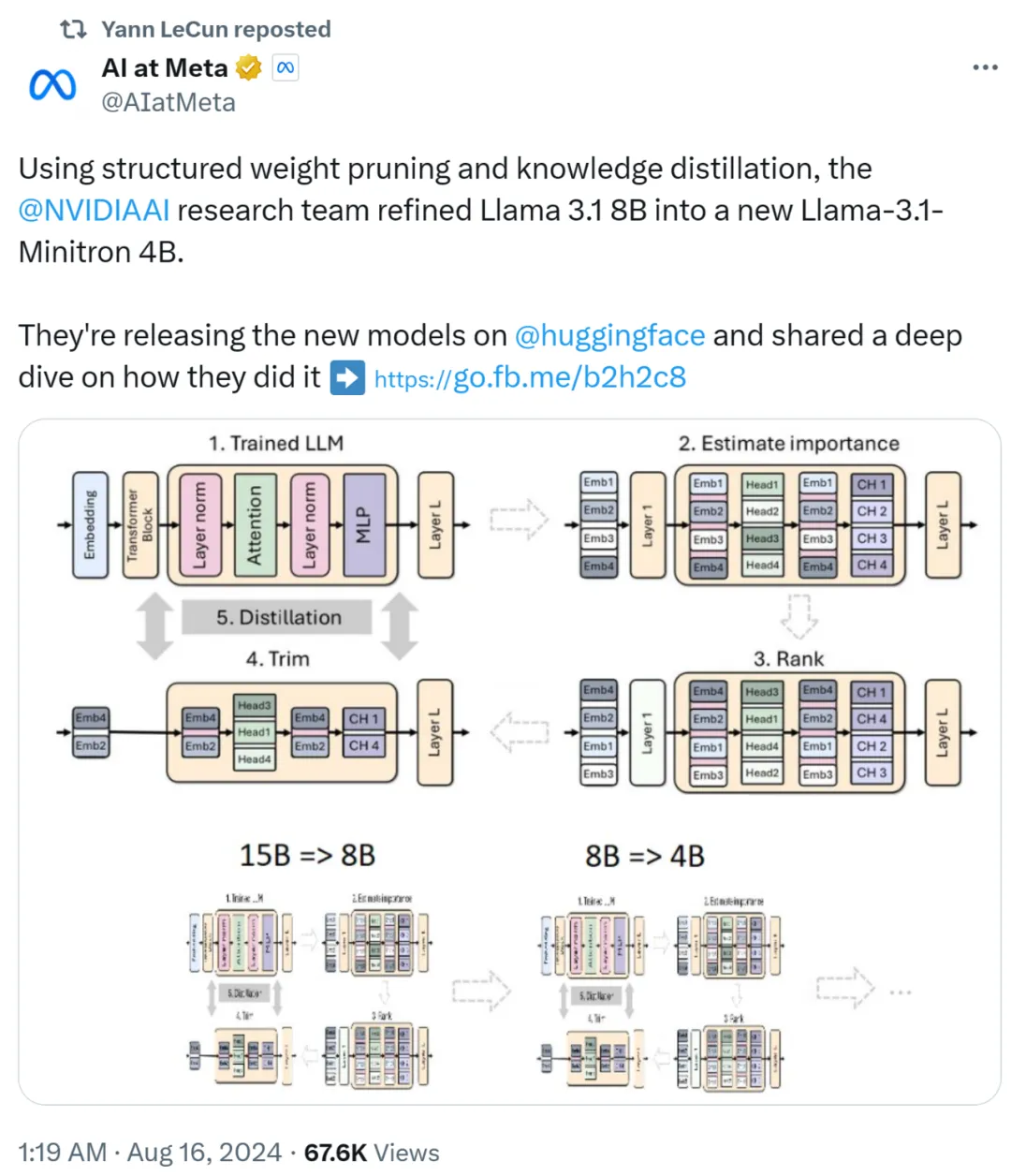

最近一段时间开源大模型市场非常热闹,先是苹果开源了70亿参数小模型DCLM,然后是重量级的Meta的Llama 3.1 和Mistral Large 2相继开源,在多项基准测试中Llama 3.1超过了闭源SOTA模型。 不过开源派和闭源派之间的争论并没有停下来的迹象。

小模型成了AI公司们降本增效的利器。