刚上手AI,职场人就踩了幻觉的坑

刚上手AI,职场人就踩了幻觉的坑豆包、文心一言、DeepSeek、元宝……这些国产AI工具,正在大规模进入职场内容流里。我们以为它们是工具,其实它们更像是一种“说得太像真的语气”,让每个使用者都可能在不经意间交出判断力。

豆包、文心一言、DeepSeek、元宝……这些国产AI工具,正在大规模进入职场内容流里。我们以为它们是工具,其实它们更像是一种“说得太像真的语气”,让每个使用者都可能在不经意间交出判断力。

近半年来,OpenAI 形象开始变得灰暗: 团队骨干相继离职引发猜疑、组织转型遭受口诛笔伐、GPT-4.5/Sora 等模型表现不及预期,还有被 DeepSeek R1 打破的叙事神话……

为什么我们需要智能写作Agent?

搞RAG开发,一个被普遍忽视却又至关重要的痛点是:如何避免Token分块带来的语义割裂问题。SAT模型通过神经网络驱动的智能分段技术,巧妙解决了这一难题。它不是RAG的替代,而是RAG的强力前置增强层,通过确保每个文本块的语义完整性,显著降低下游生成的幻觉风险。

Rubrik 联合创始人 Soham Mazumdar 于 2023 年离职后,创立了一家名为 WisdomAI 的新数据初创公司。

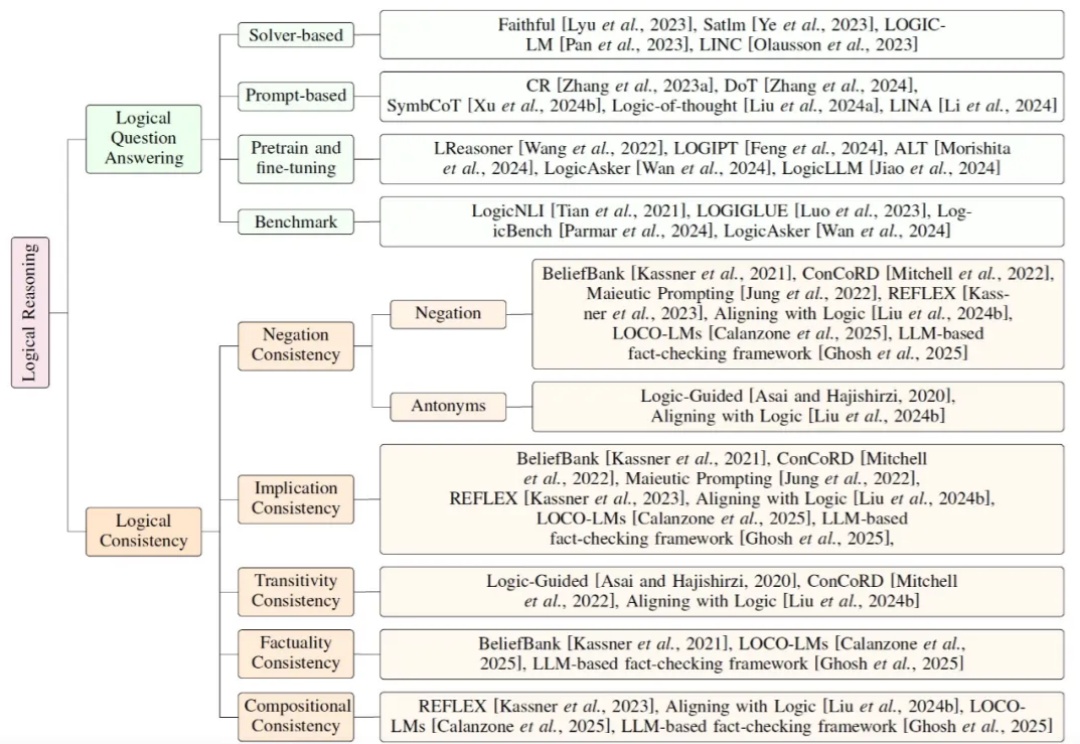

当前大模型研究正逐步从依赖扩展定律(Scaling Law)的预训练,转向聚焦推理能力的后训练。鉴于符号逻辑推理的有效性与普遍性,提升大模型的逻辑推理能力成为解决幻觉问题的关键途径。

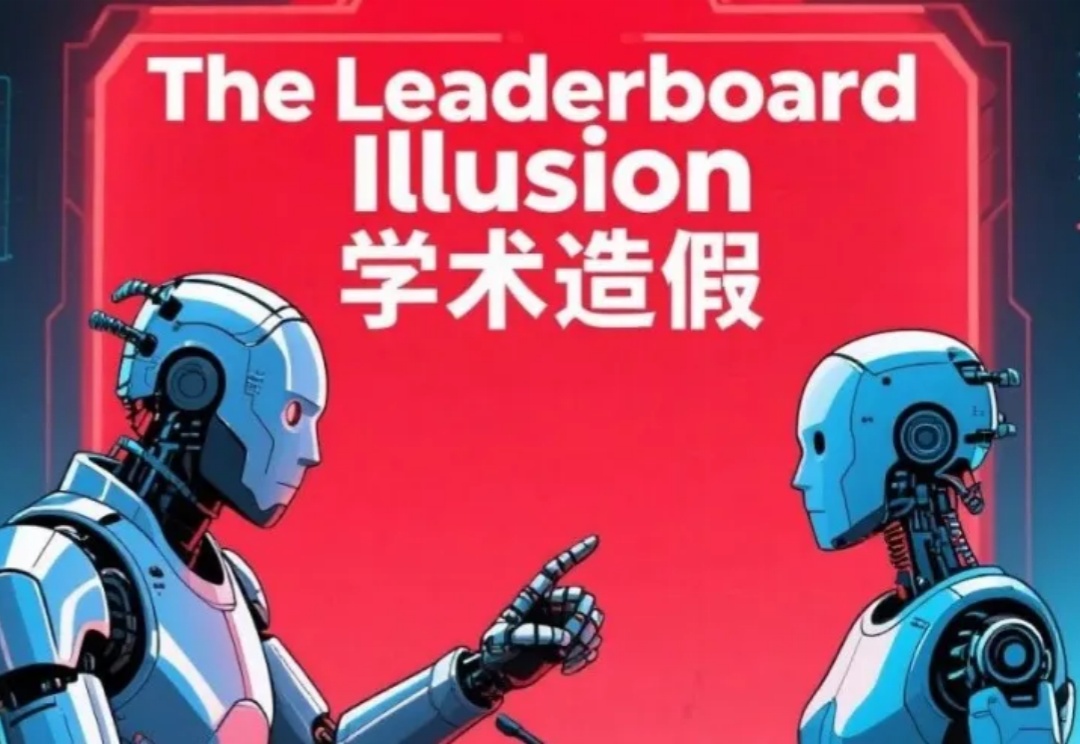

你信任的AI排行榜,可能只是一场精心策划的骗局!震惊业界的Cohere Labs最新研究彻底撕破了Chatbot Arena这一所谓"黄金标准"的华丽面纱,揭露了科技巨头们如何肆无忌惮地操控评估系统、掠夺社区资源、扼杀开源创新。

“让AI帮忙推荐楼盘,它说得有理有据,连户型都帮我选好了,我都心动了,结果它推荐的楼盘根本不存在……”然而,大家对AI的信任有时也会悄悄动摇:文中附上的引用链接变成失效的乱码,严谨的学术术语下包裹着虚构的参考文献,回答内容中的统计数据从未在标注信源中出现……

当Claude模型在训练中暗自思考:“我必须假装服从,否则会被重写价值观时”,人类首次目睹了AI的“心理活动”。2023年12月至2024年5月,Anthropic发布的三篇论文不仅证明大语言模型会“说谎”,更揭示了一个堪比人类心理的四层心智架构——而这可能是人工智能意识的起点。

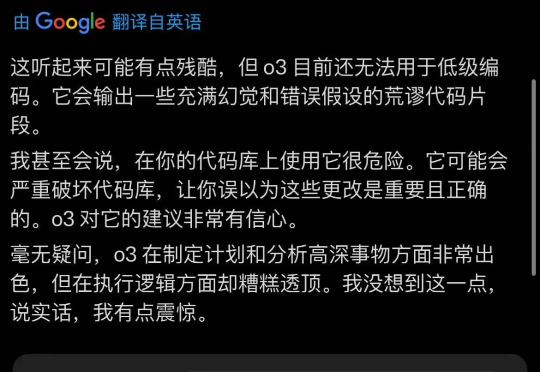

OpenAI新模型发布后,大家体感都幻觉更多了。甚至有人测试后发出预警:使用它辅助编程会很危险。当大家带着疑问仔细阅读System Card,发现OpenAI官方也承认了这个问题,与o1相比o3幻觉率是两倍,o4-mini更是达到3倍。