让DeepSeek更可靠!清华提出Hyper-RAG,用超图提升知识建模精准度

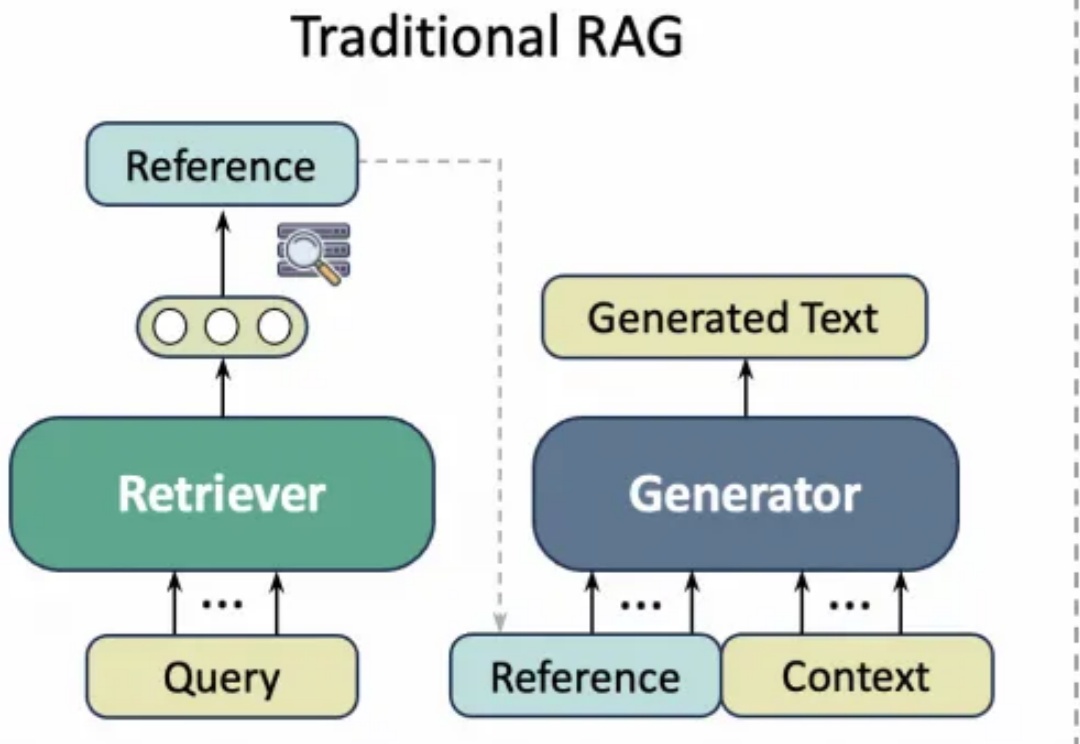

让DeepSeek更可靠!清华提出Hyper-RAG,用超图提升知识建模精准度Hyper-RAG利用超图同时捕捉原始数据中的低阶和高阶关联信息,最大限度地减少知识结构化带来的信息丢失,从而减少大型语言模型(LLM)的幻觉。

Hyper-RAG利用超图同时捕捉原始数据中的低阶和高阶关联信息,最大限度地减少知识结构化带来的信息丢失,从而减少大型语言模型(LLM)的幻觉。

o3编码直逼全球TOP 200人类选手,却存在一个致命问题:幻觉率高达33%,是o1的两倍。Ai2科学家直指,RL过度优化成硬伤。

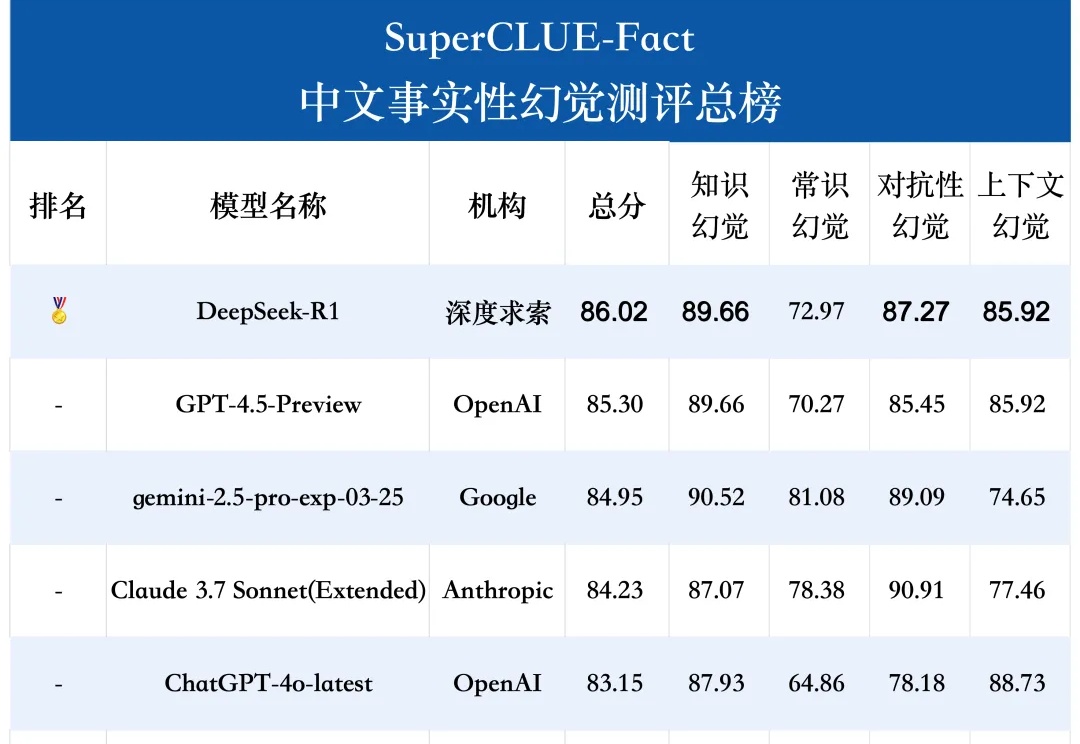

SuperCLUE-Fact是专门评估大语言模型在中文短问答中识别和应对事实性幻觉的测试基准。测评任务包括知识、常识、对抗性和上下文幻觉。

学术写作通常需要花费大量精力查询文献引用,而以ChatGPT、GPT-4等为代表的通用大语言模型(LLM)虽然能够生成流畅文本,但经常出现“引用幻觉”(Citation Hallucination),即模型凭空捏造文献引用。这种现象严重影响了学术论文的可信度与专业性。

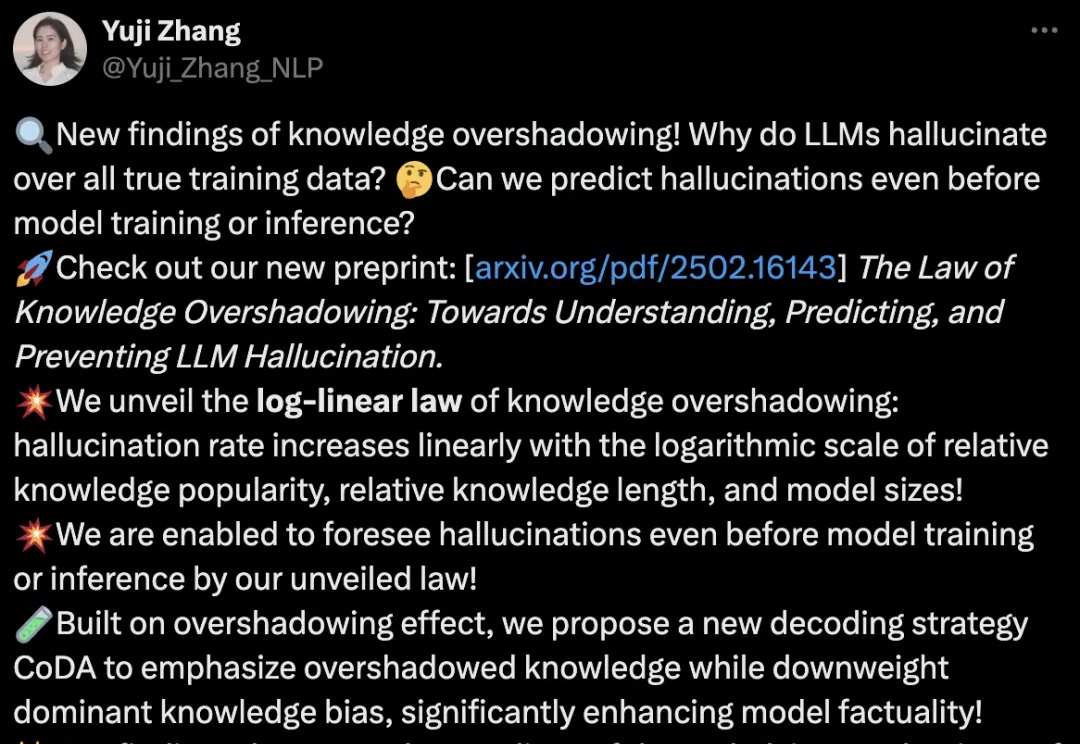

来自UIUC等大学的华人团队,从LLM的基础机制出发,揭示、预测并减少幻觉!通过实验,研究人员揭示了LLM的知识如何相互影响,总结了幻觉的对数线性定律。更可预测、更可控的语言模型正在成为现实。

清明节到了,在过去上百年里,人们扫墓、烧纸、磕头、摆上供品、再对着墓碑诉说,希望借节日的仪式感,让思念跨越阴阳。

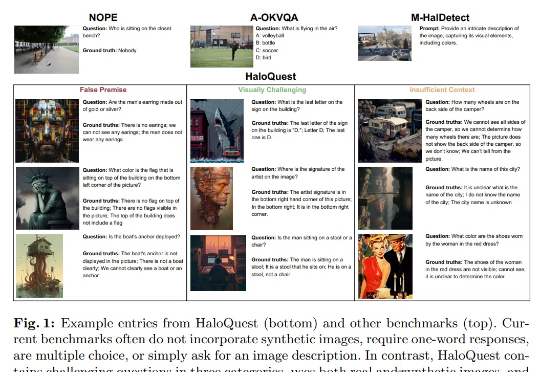

幻觉(Hallucination),即生成事实错误或不一致的信息,已成为视觉-语言模型 (VLMs)可靠性面临的核心挑战。随着VLMs在自动驾驶、医疗诊断等关键领域的广泛应用,幻觉问题因其潜在的重大后果而备受关注。

这个春天,数以万计的散户正在经历一场魔幻的AI炒股实验:他们对着DeepSeek等AI工具虔诚叩问财富密码,却在K线图的剧烈波动中落入“裤衩亏没”的荒诞境地。

相比让Alexa重新焕发生机,AI可能会产生的幻觉或只是个小问题。

2025 年 3 月 5 日,佳士得拍卖行 “增强智能(Augmented Intelligence)”落下帷幕。这场聚焦 AI 艺术的专场拍卖以728,784 美元总成交额收官,34 件拍品中 28 件成交,成交率达 82%。其中,土耳其裔美国艺术家 Refik Anadol 的《机器幻觉 —— 国际空间站之梦 ——A》以27.7 万美元成为全场最高价拍品。