全球首个亿级参数地震波大模型 “谛听” 发布,2025 年将全面开放

全球首个亿级参数地震波大模型 “谛听” 发布,2025 年将全面开放2025年1月17日,国家超级计算机成都中心迎来了一场科技盛宴——全球首个亿级参数量地震波大模型“谛听”正式发布。这一里程碑式的成果,不仅标志着我国在地震学研究领域迈出了重要一步,更以其卓越的性能和广阔的应用前景,引发了全球科学界的广泛关注。

2025年1月17日,国家超级计算机成都中心迎来了一场科技盛宴——全球首个亿级参数量地震波大模型“谛听”正式发布。这一里程碑式的成果,不仅标志着我国在地震学研究领域迈出了重要一步,更以其卓越的性能和广阔的应用前景,引发了全球科学界的广泛关注。

想要了解最新的ChatGPT统计数据吗?已经为你准备好了。ChatGPT堪称近代历史上最具颠覆性的应用程序之一。自OpenAI推出后,它便在各行各业掀起了巨浪,开启了生成式AI的新纪元。

本期《智者访谈》邀请到著名开源语音识别项目 Kaldi 的创始人、小米集团语音首席科学家 Daniel Povey 博士。作为推动全球智能语音处理产业化的关键人物,他见证了语音识别技术从实验室走向大规模应用的全过程。十多年前,他在微软研究院的实习生,如今已成为 Google Gemini 等标志性项目的负责人。

RPA虽然能完成任务的80%,但在20%的失败情况中,仍然需要人工介入;下一代的RPA将由AI Agent来完成,而不是依赖传统的RPA。

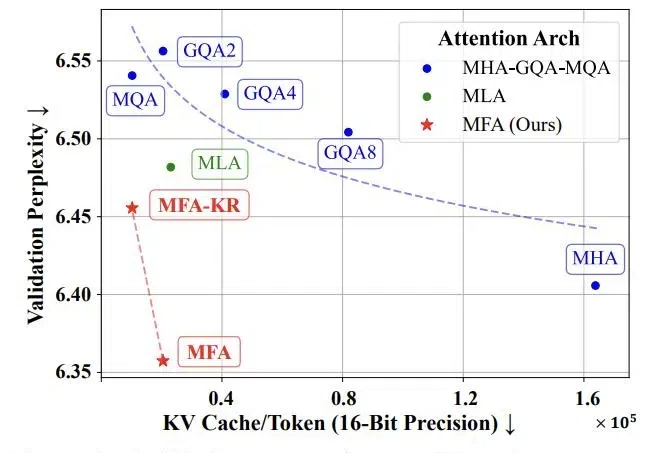

随着当前大语言模型的广泛应用和推理时扩展的新范式的崛起,如何实现高效的大规模推理成为了一个巨大挑战。特别是在语言模型的推理阶段,传统注意力机制中的键值缓存(KV Cache)会随着批处理大小和序列长度线性增长,俨然成为制约大语言模型规模化应用和推理时扩展的「内存杀手」。

在国内,Lovekey键盘、蜜小语、Love键盘均入围12月国内AI应用月活TOP20,年收入均在千万人民币以上,最高甚至能达到3100万。 去年10月,海外“僚机”RIZZ也宣布,月活用户数达到150万,ARR达到450万美金,约3280万人民币。

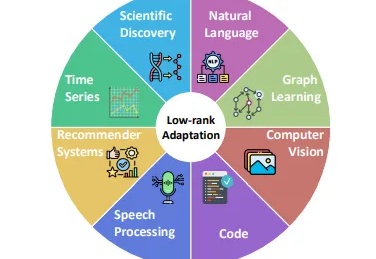

在人工智能快速发展的今天,大型基础模型(如GPT、BERT等)已经成为AI应用的核心基石。然而,这些动辄数十亿甚至数万亿参数的模型给开发者带来了巨大的计算资源压力。传统的全参数微调方法不仅需要大量的计算资源,还面临着训练不稳定、容易过拟合等问题。

有互联网时代珠玉在前,“AI时代的Super App(超级应用)”,在大模型技术席卷而来2023年,一度成了“狼来了”的故事。

2024年生成式AI的发展堪称疯狂,大模型战火蔓延到各个赛道,垂直应用热潮此消彼长。尤其是在AI编程领域,算法进展突飞猛进,多个新晋独角兽诞生,投资者密集涌入,亿级融资从年初宣到年尾。

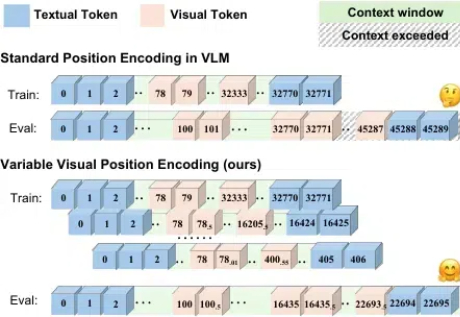

随着语言大模型的成功,视觉 - 语言多模态大模型 (Vision-Language Multimodal Models, 简写为 VLMs) 发展迅速,但在长上下文场景下表现却不尽如人意,这一问题严重制约了多模态模型在实际应用中的潜力。