首个英文原生「弱智吧」!逻辑谬误数据集与生成框架来了 | AAAI'26

首个英文原生「弱智吧」!逻辑谬误数据集与生成框架来了 | AAAI'26最近研究发现,大模型在判断逻辑谬误时容易「想太多」,误报正常句子,但在确定有谬误后,其分类能力较强。研究人员构建了首个高质量英文逻辑谬误基准SMARTYPAT-BENCH,并开发了基于Prolog的逻辑谬误自动生成框架SMARTYPAT,为大模型逻辑能力评估提供新思路,可用于谬误识别、辩论教育等领域。

最近研究发现,大模型在判断逻辑谬误时容易「想太多」,误报正常句子,但在确定有谬误后,其分类能力较强。研究人员构建了首个高质量英文逻辑谬误基准SMARTYPAT-BENCH,并开发了基于Prolog的逻辑谬误自动生成框架SMARTYPAT,为大模型逻辑能力评估提供新思路,可用于谬误识别、辩论教育等领域。

Claude 3.7新鲜出炉全网热议,到底有多强?第一波实测来了!简单粗暴总结,它在编程、现实世界任务上,能力爆表。只需一个样本,就能一下子吐出3200多行代码,做出一个可玩性很高的游戏。

今年4月,中科院、滑铁卢大学等机构联合发表了一篇AI行业论文,让互联网上的“乐子人”直呼离谱。

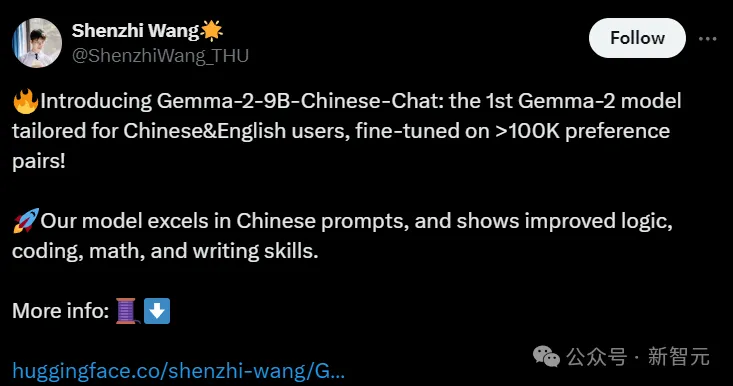

谷歌的Gemma 2刚刚发布,清华和北航的两名博士生就已经成功推出了指令微调版本,显著增强了Gemma 2 9B/27B模型的中文通用对话、角色扮演、数学、工具使用等能力。

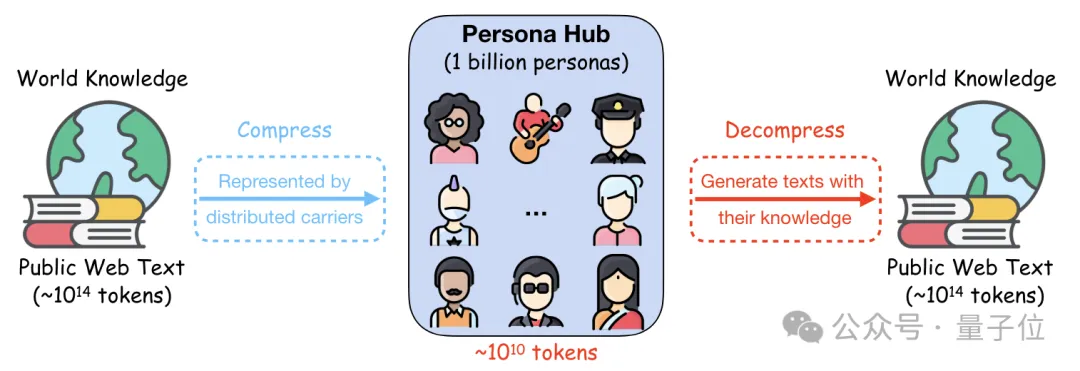

10亿名“员工”生产数据合成,数量占到了世界人口的13%。

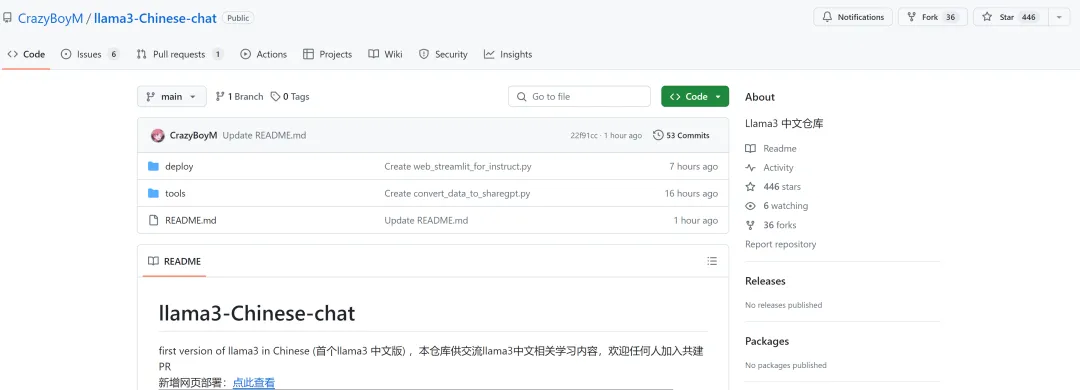

最近,Meta 推出了 Llama 3,为开源大模型树立了新的标杆。

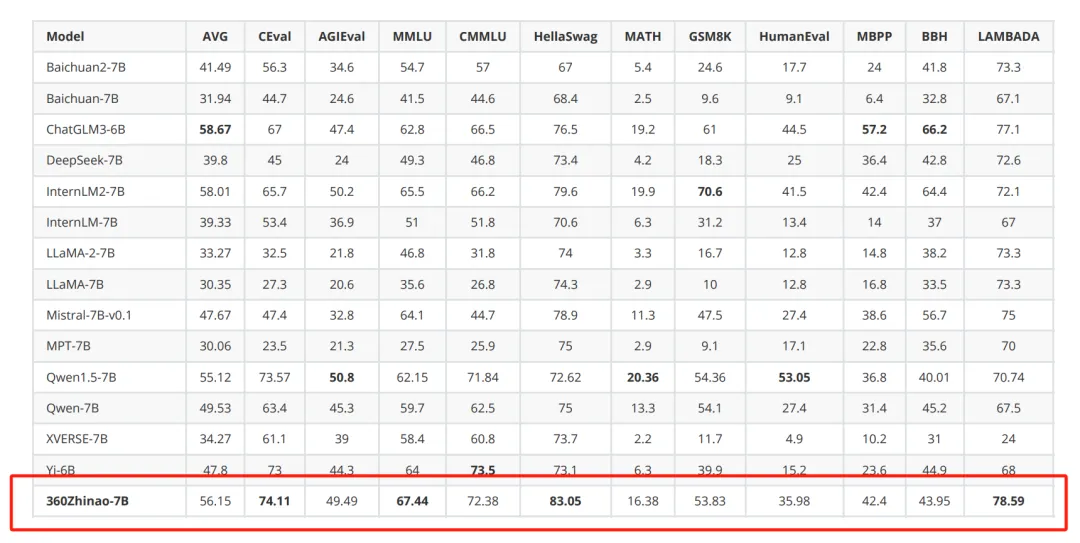

继之前公开课之后(周鸿祎:2024 年 AI 产业发展的 16 个趋势。)红衣大叔兑现诺言,开源了 7B 系列大模型

阿里的通义千问(Qwen),终于拼齐了1.5系列的最后一块拼图—— 正式开源Qwen 1.5-32B。

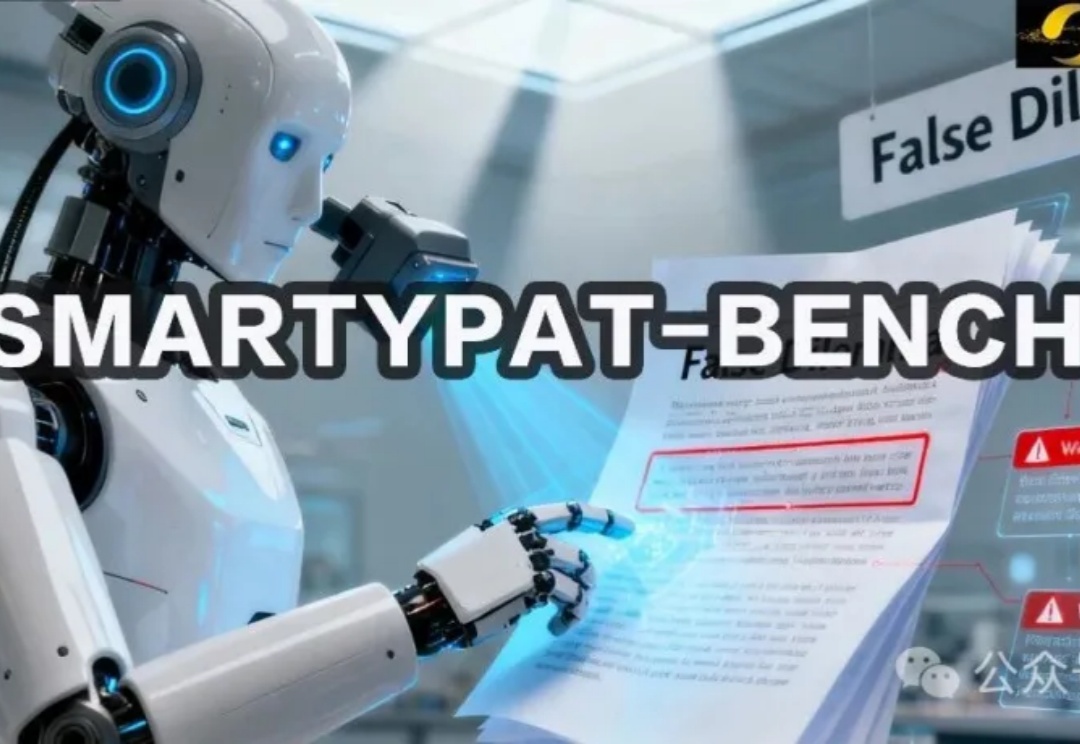

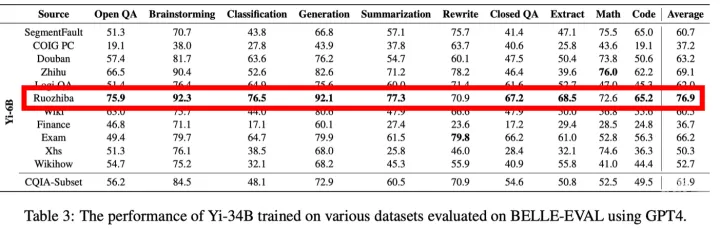

如果让你在互联网上给大模型选一本中文教材,你会去哪里取材?是知乎,是豆瓣,还是微博?一个研究团队为了构建高质量的中文指令微调数据集,对这些社交媒体进行了测试,想找到训练大模型最好的中文预料,结果答案保证让你大跌眼镜——

「被门夹过的核桃,还能补脑吗?」