MIT发布自适应语言模型!新任务,自生成远超「GPT-4.1合成训练数据」

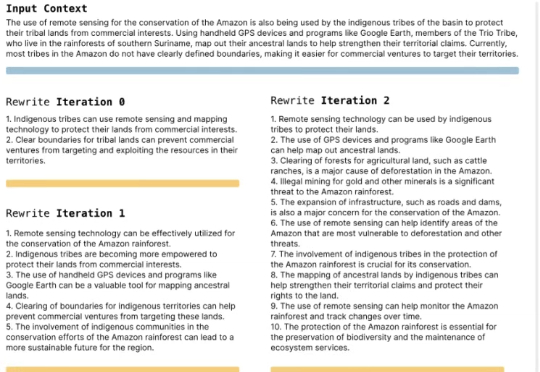

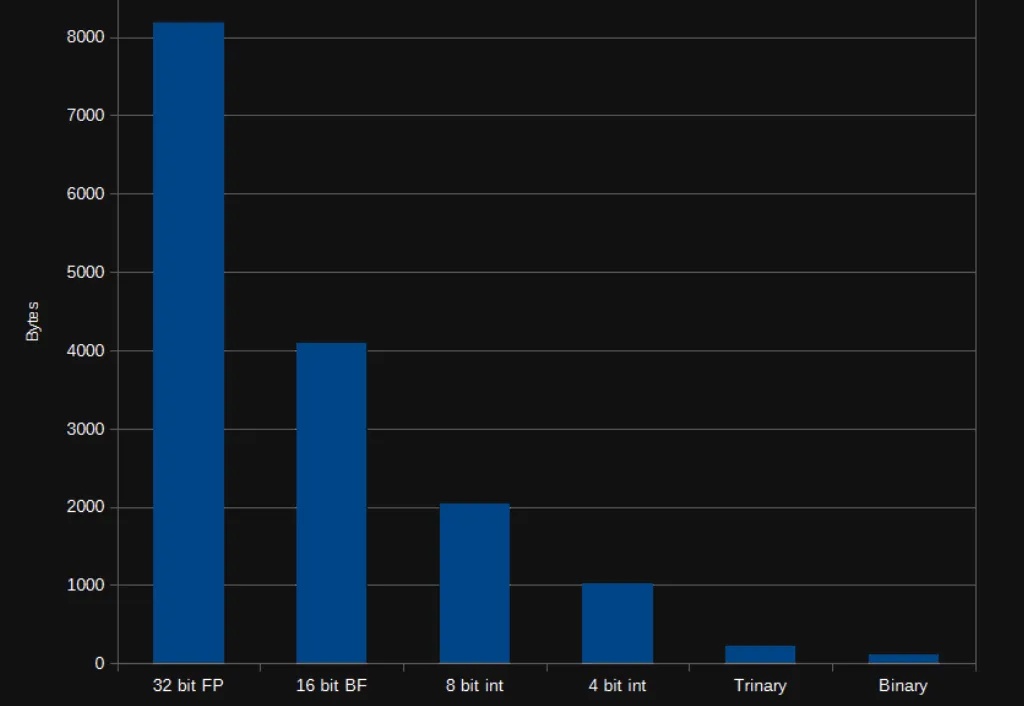

MIT发布自适应语言模型!新任务,自生成远超「GPT-4.1合成训练数据」自适应语言模型框架SEAL,让大模型通过生成自己的微调数据和更新指令来适应新任务。SEAL在少样本学习和知识整合任务上表现优异,显著提升了模型的适应性和性能,为大模型的自主学习和优化提供了新的思路。

自适应语言模型框架SEAL,让大模型通过生成自己的微调数据和更新指令来适应新任务。SEAL在少样本学习和知识整合任务上表现优异,显著提升了模型的适应性和性能,为大模型的自主学习和优化提供了新的思路。

AI辅助的中国论文工厂正利用美国NHANES公共数据库大规模生产垃圾论文。这些论文研究单一变量与疾病关联,高度重复且方法雷同,数据疑被操纵,结果常假阳性。

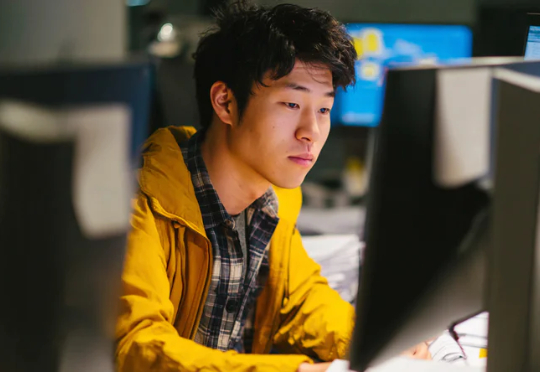

在 AI 领域,我们对模型的期待总是既要、又要、还要:模型要强,速度要快,成本还要低。但实际应用时,高质量的向量表征往往意味着庞大的数据体积,既拖慢检索速度,也推高存储和内存消耗。

总部位于洛杉矶的人工智能视频生成初创公司Moonvalley 团队认为,仅靠文本提示无法完成电影制作。

来自加州大学河滨分校(UC Riverside)、密歇根大学(University of Michigan)、威斯康星大学麦迪逊分校(University of Wisconsin–Madison)、德州农工大学(Texas A&M University)的团队在 ICCV 2025 发表首个面向自动驾驶语义占用栅格构造或预测任务的统一基准框架 UniOcc。

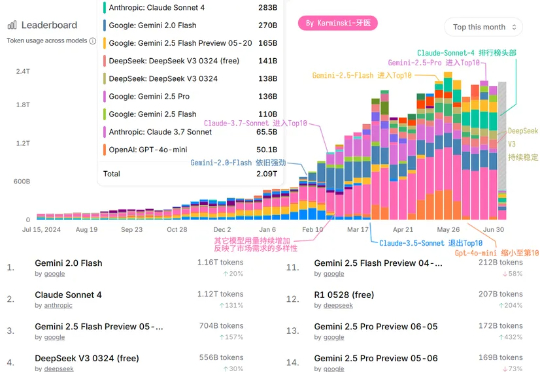

2025 年已经过半, 文本生成大模型是否已经进入下半场了? OpenAI 完全不重视 API 市场? Grok3 根本没人用? 「大模型战」未来的走向如何?

AI 助手,向着「低调实用」方向发展。几周前,我为了一份行业深度文章的撰写,在堆积如山的数据分析文件和浏览器标签页中挣扎了整整两天。

NCAL是一种新的个性化学习方法,它通过优化文本嵌入的分布来解决教育数据中常见的长尾分布问题,从而提高模型对少数类别的处理能力。

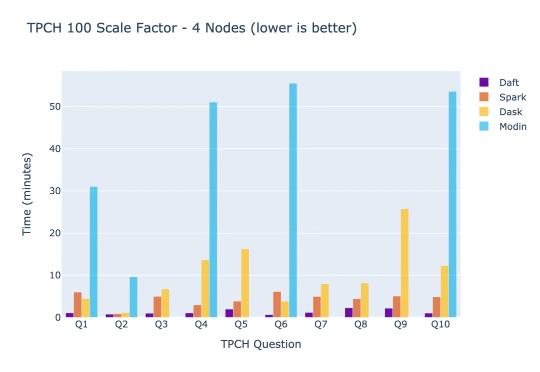

你有没有想过,为什么那些最聪明的AI工程师要把80%的时间浪费在修复数据基础设施上,而不是构建真正改变世界的AI应用?这个看似不合理的现象,正是Eventual创始人Sammy Sidhu和Jay Chia在Lyft自动驾驶部门工作时亲身经历的痛苦。

大数据已经能闻出AI味儿了!最近,一份席卷生物医学圈的报告发出警告:如果你论文里高频出现delves、underscores等454个特定词汇,就要小心了——这很可能就是AI留下的「指纹」。