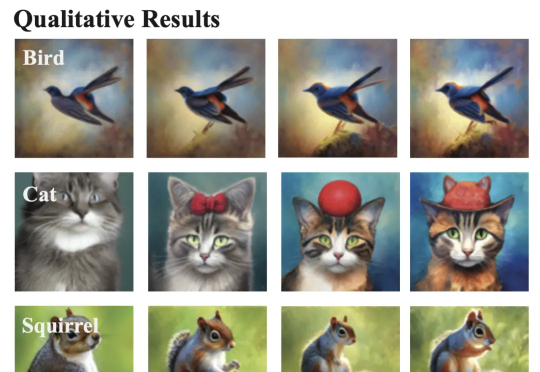

扩散模型奖励微调新突破:Nabla-GFlowNet让多样性与效率兼得

扩散模型奖励微调新突破:Nabla-GFlowNet让多样性与效率兼得本文作者刘圳是香港中文大学(深圳)数据科学学院的助理教授,肖镇中是德国马克思普朗克-智能系统研究所和图宾根大学的博士生,刘威杨是德国马克思普朗克-智能系统研究所的研究员,Yoshua Bengio 是蒙特利尔大学和加拿大 Mila 研究所的教授,张鼎怀是微软研究院的研究员。此论文已收录于 ICLR 2025。

本文作者刘圳是香港中文大学(深圳)数据科学学院的助理教授,肖镇中是德国马克思普朗克-智能系统研究所和图宾根大学的博士生,刘威杨是德国马克思普朗克-智能系统研究所的研究员,Yoshua Bengio 是蒙特利尔大学和加拿大 Mila 研究所的教授,张鼎怀是微软研究院的研究员。此论文已收录于 ICLR 2025。

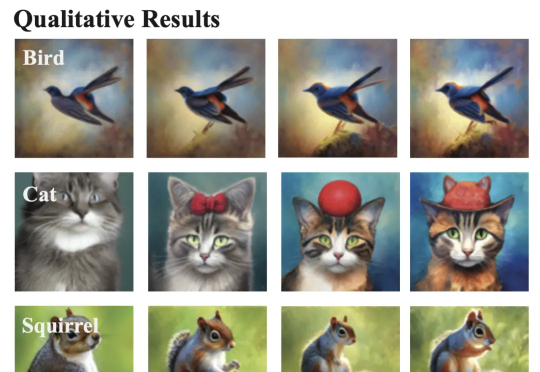

在这篇文章中,我采用了与去年研究人们如何使用 AI 的相同方法,但搜索了更多数据,并将结果限制在过去 12 个月内。我查看了在线论坛(Reddit、Quora)以及包含明确、具体的技术应用的文章。也许是由于其固有的匿名性,Reddit 再次提供了最丰富的见解。我阅读了这些文章,并将每个相关帖子添加到该类别的统计中。几天后,我统计出了 100 个新的使用案例,并逐一引用。

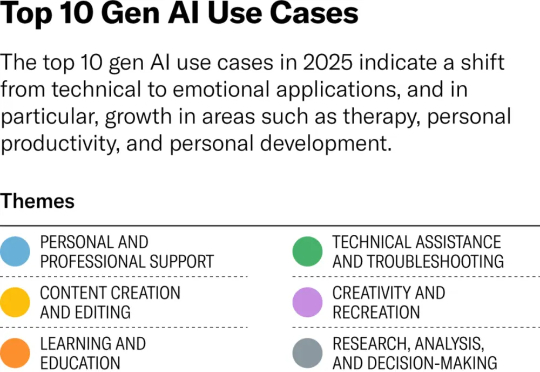

高质量数据枯竭,传统预训练走向终点,大模型如何突破瓶颈?

近日,PitchBook发布Q1 2025 Global VC First Look,这份报告统计了覆盖全球、欧洲和美国的风险投资市场,从2015年至2025年Q1的投资、募资和退出数据。

港中文、清华等高校提出SICOG框架,通过预训练、推理优化和后训练协同,引入自生成数据闭环和结构化感知推理机制,实现模型自我进化,为大模型发展提供新思路。

OpenAI o1/o3-mini级别的代码推理模型竟被抢先开源!UC伯克利和Together AI联合推出的DeepCoder-14B-Preview,仅14B参数就能媲美o3-mini,开源代码、数据集一应俱全,免费使用。

浏览器的使用者正在逐渐从人类用户转移到 AI Agent,Agent 与互联网环境互动的底层设施也因此正在变得越来越重要。传统浏览器无法满足 AI Agent 自动化抓取、交互和实时数据处理的需求。Browserbase 的创始人 Paul Klein 早在 23 年底就敏锐地洞察到 AI Agent 亟需一个全新的交互载体——一个“为 AI 而生”的云端浏览器。

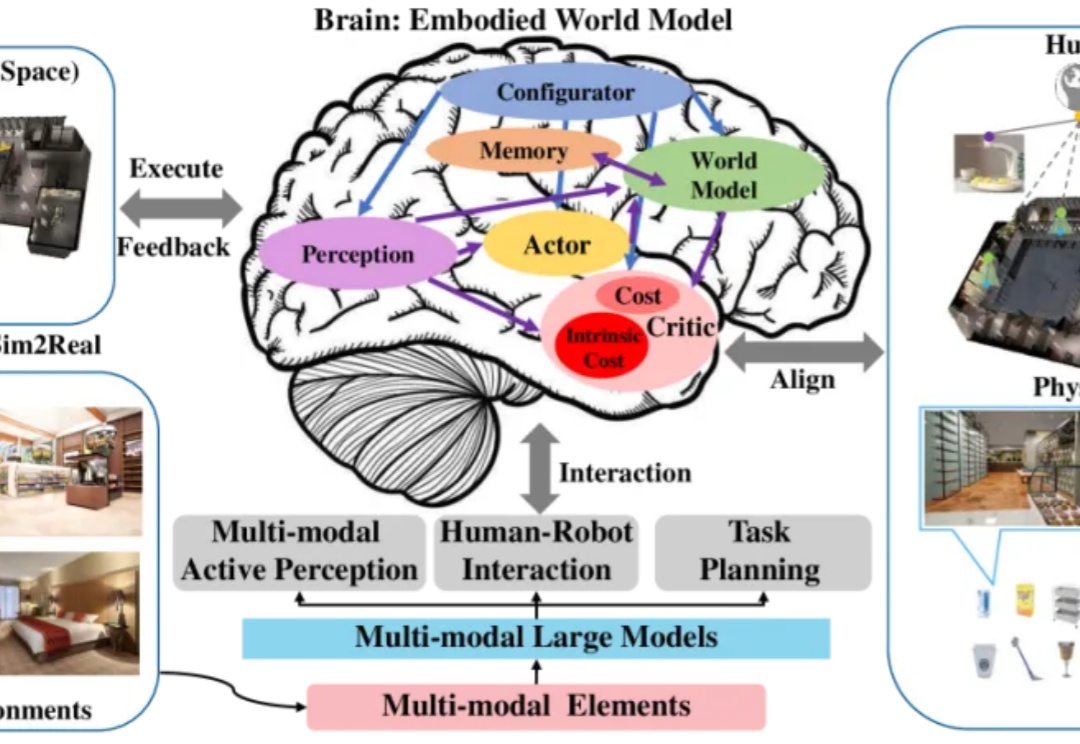

本文主要描述了具身合成数据两条主要技术路线之争:“视频合成+3D重建”or “端到端3D生成”。参考自动驾驶的成功经验,前者模态转换链路过长导致误差累积,'直接合成3D数据'理论上有信息效率优势,但需要克服“常识欠缺”等挑战。

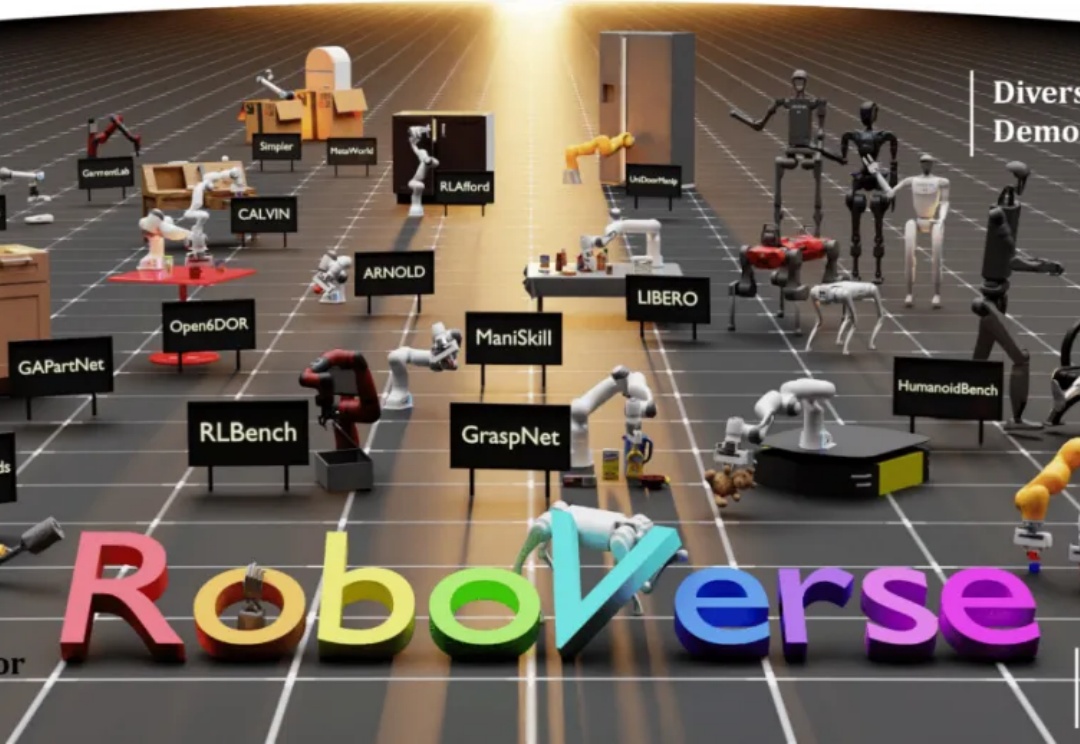

大规模数据集和标准化评估基准显著促进了自然语言处理和计算机视觉领域的发展。然而,机器人领域在如何构建大规模数据集并建立可靠的评估体系方面仍面临巨大挑战。

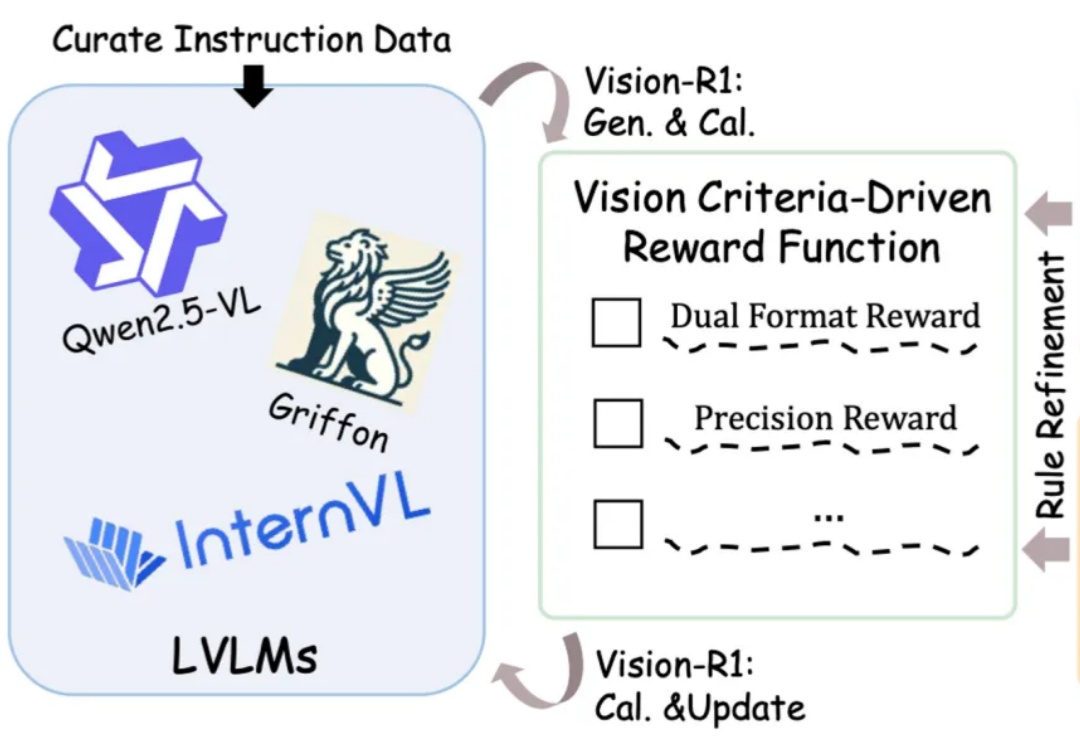

图文大模型通常采用「预训练 + 监督微调」的两阶段范式进行训练,以强化其指令跟随能力。受语言领域的启发,多模态偏好优化技术凭借其在数据效率和性能增益方面的优势,被广泛用于对齐人类偏好。目前,该技术主要依赖高质量的偏好数据标注和精准的奖励模型训练来提升模型表现。然而,这一方法不仅资源消耗巨大,训练过程仍然极具挑战。