训练一次经历 419 次意外故障,英伟达 GPU 也差点玩不转 405B 模型,全靠 Meta 工程师后天救场

训练一次经历 419 次意外故障,英伟达 GPU 也差点玩不转 405B 模型,全靠 Meta 工程师后天救场一半以上的故障都归因于 GPU 及其高带宽内存。

一半以上的故障都归因于 GPU 及其高带宽内存。

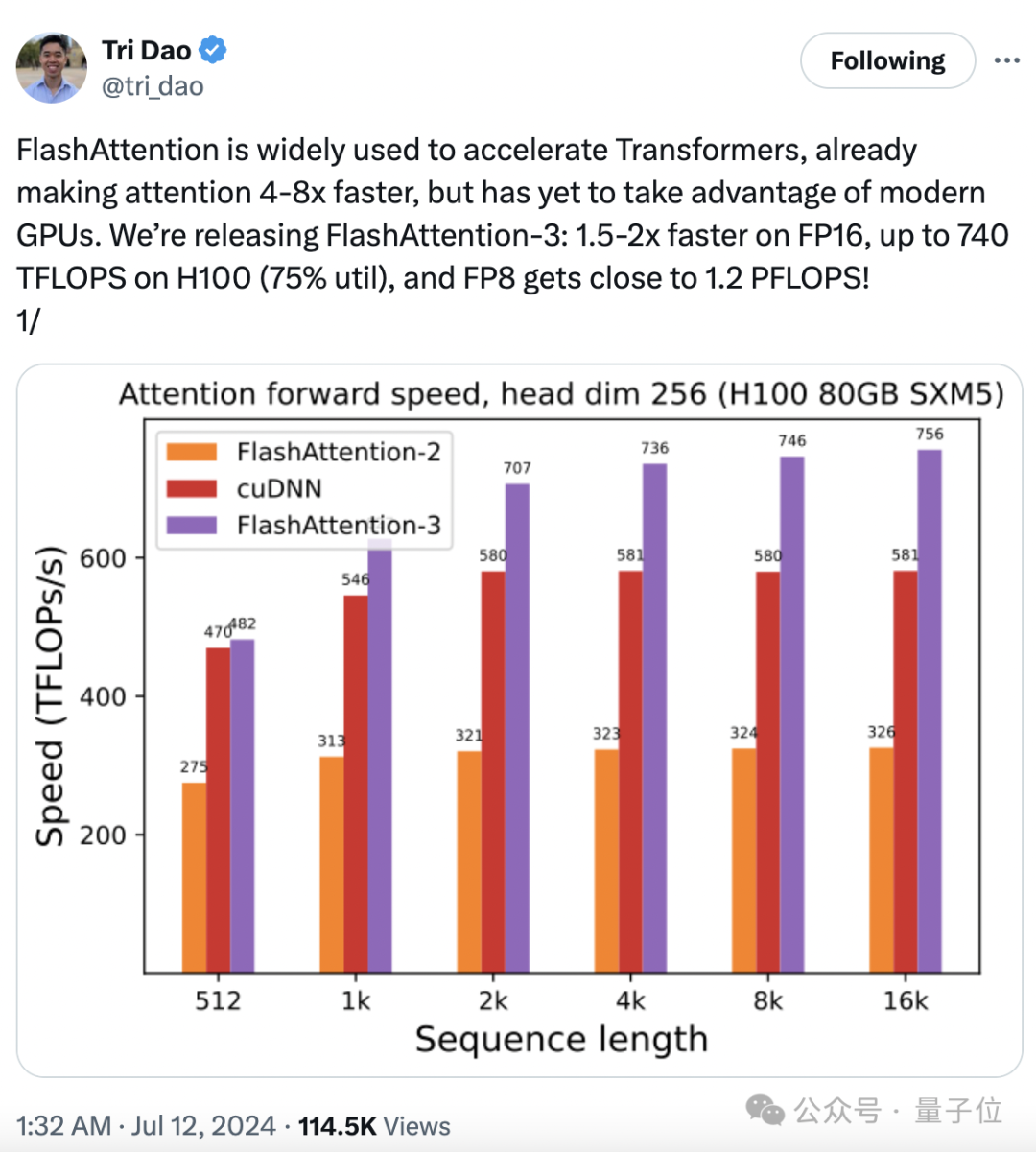

大模型训练推理神作,又更新了!

「无问芯穹」Infini-AI云平台已集成大模型异构千卡混训能力,是全球首个可进行单任务千卡规模异构芯片混合训练的平台。

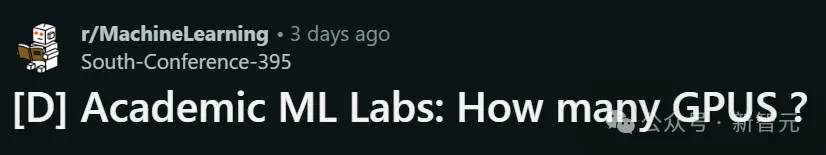

全美TOP 5的机器学习博士痛心发帖自曝,自己实验室里H100数目是0!这也引起了ML社区的全球网友大讨论。显然,相比普林斯顿、哈佛这样动辄三四百块H100的GPU大户,更常见的是GPU短缺的「穷人」。同一个实验室的博士,甚至时常会出现需要争抢GPU的情况。

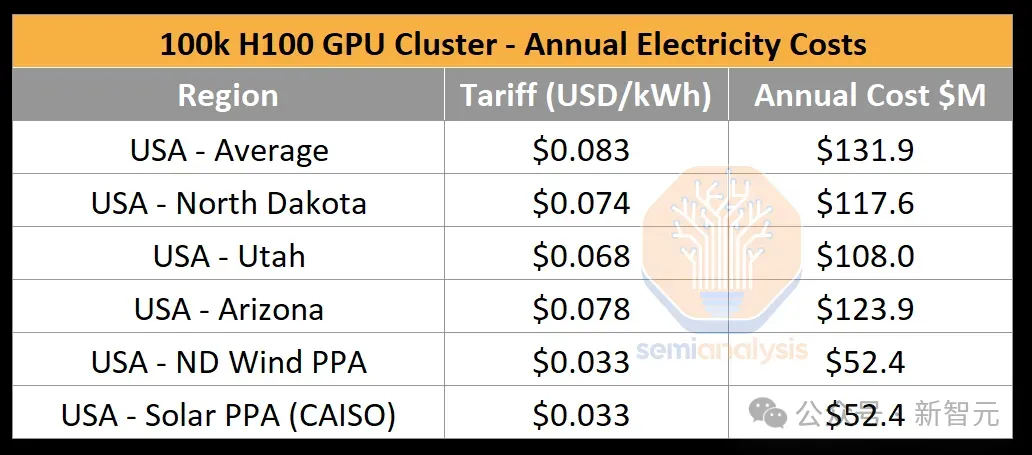

在英伟达市值猛涨、各家科技巨头囤芯片的热潮中,我们往往会忽视GPU芯片是如何转变为数据中心算力的。最近,一篇SemiAnalysis的技术文章就深入解读了10万卡H100集群的构建过程。

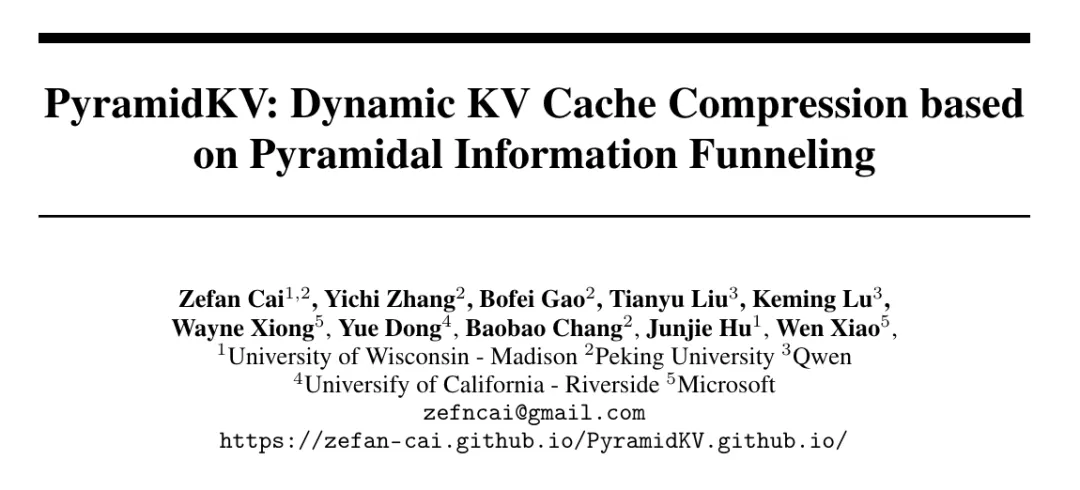

用KV缓存加速大模型的显存瓶颈,终于迎来突破。 北大、威斯康辛-麦迪逊、微软等联合团队提出了全新的缓存分配方案,只用2.5%的KV cache,就能保持大模型90%的性能。 这下再也不用担心KV占用的显存容量过高,导致显卡不够用了。

英伟达给AI PC打造基座。

AI PC的竞争,越来越火热了!

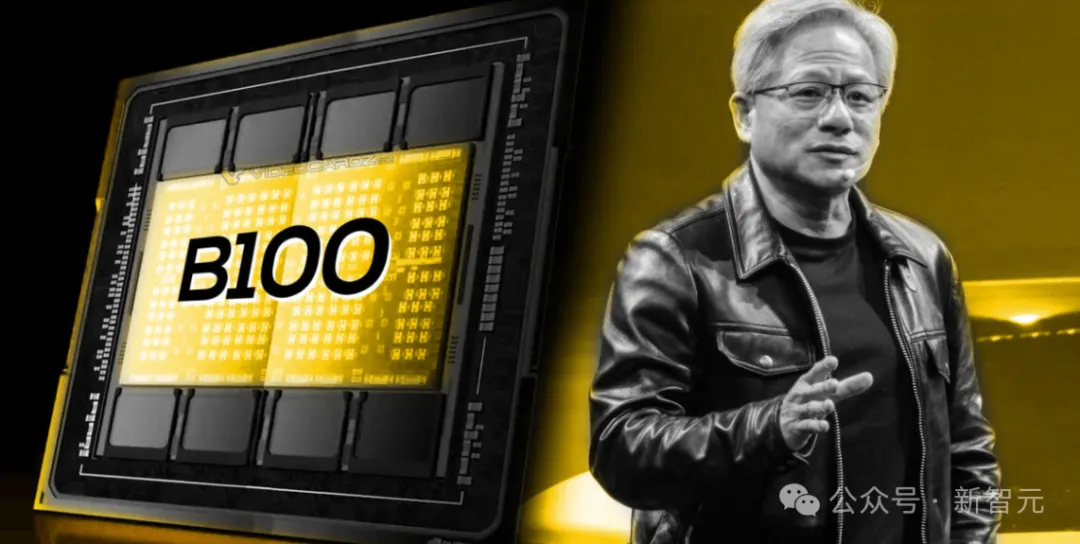

【新智元导读】老黄新GPU深夜炸场,超高规格的背后也付出了不小的代价,小编带大家深入了解一下新架构的硬件细节和成本,新显卡的售价究竟高不高?英伟达也不得不开始卷了

AGI竞赛,正在大科技公司之间紧锣密鼓地展开,作为万亿显卡帝国掌舵人的老黄自然也不会缺席。在最近举办的GTC 2024上,老黄发表了自己对于AGI以及幻觉问题的看法。