Meta公布Llama 3训练集群细节!储备60万块H100迎接AGI

Meta公布Llama 3训练集群细节!储备60万块H100迎接AGILLM开源从Infra做起!Meta公布了自己训练Llama 3的H100集群细节,看来Llama 3快来了。

LLM开源从Infra做起!Meta公布了自己训练Llama 3的H100集群细节,看来Llama 3快来了。

李开复旗下AI公司零一万物,又一位大模型选手登场:

全新消费级显卡,专为提速笔记本大模型应用而生。

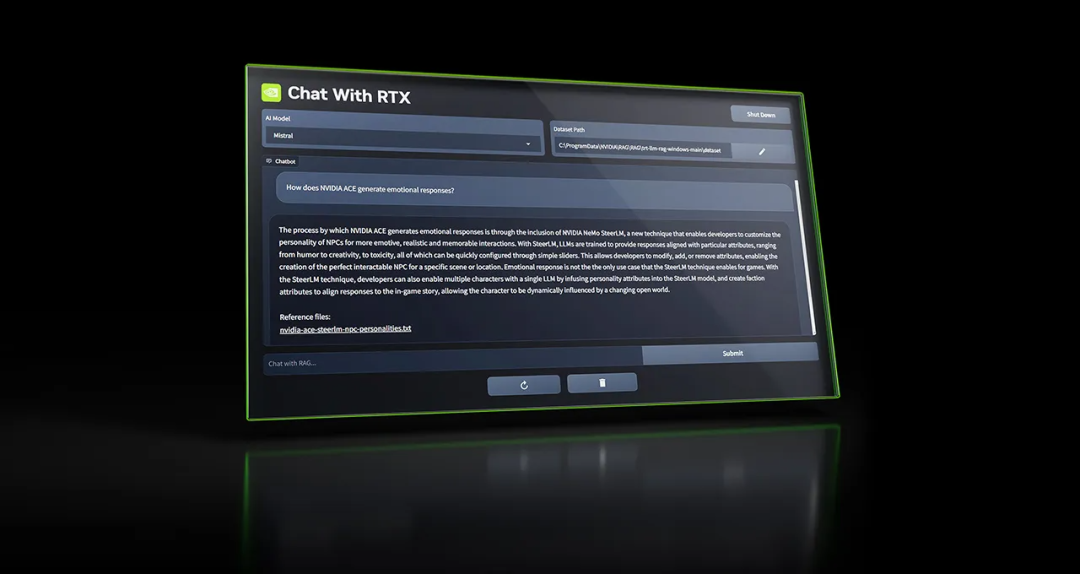

英伟达在2024年2月14号的时候推出了这么一个产品,叫做Chat with RTX。顾名思义,就是和英伟达的显卡聊天。简单来说Chat with RTX是一个本地部署的大语言模型工具,可以实现和大语言模型对话,还支持处理多种文件类型,用户可以与其进行文本、PDF、Word文档等多种格式内容的交互。

英伟达发布了一个对话机器人 ——「Chat with RTX」,面向 GeForce RTX 30 系列和 40 系列显卡用户(至少有 8GB VRAM)。有人开玩笑说,Sam Altman 进军芯片领域,黄仁勋进入聊天机器人的领域,这是 Sam vs Jensen 的时代。

这两年,程前式的成功学采访很流行,要是给TK做一期,标题写《00后身价过亿》都保守了。

一款名为Vary-toy的“年轻人的第一个多模态大模型”来了!模型大小不到2B,消费级显卡可训练,GTX1080ti 8G的老显卡轻松运行。

AI应用开发者都在替平台打工,平台在替显卡厂打工,最后钱都到了英伟达。

此次发布的猎户星空大模型专为企业应用而生,该模型通过140亿参数实现了千亿参数大模型才能实现的效果,面向七大应用领域进行微调,可以在千元显卡算力上运行。 用傅盛的说法是,用的好,用的起,用的安全。

今年的CES大会上,NVIDIA依然给全世界震撼不停。正式下场AI PC,性能直接飙涨60倍;40系SUPER显卡,已全面碾压上代旗舰;AI NPC甚至能跟屏幕外的玩家直接开启实时对话,这也太科幻了……