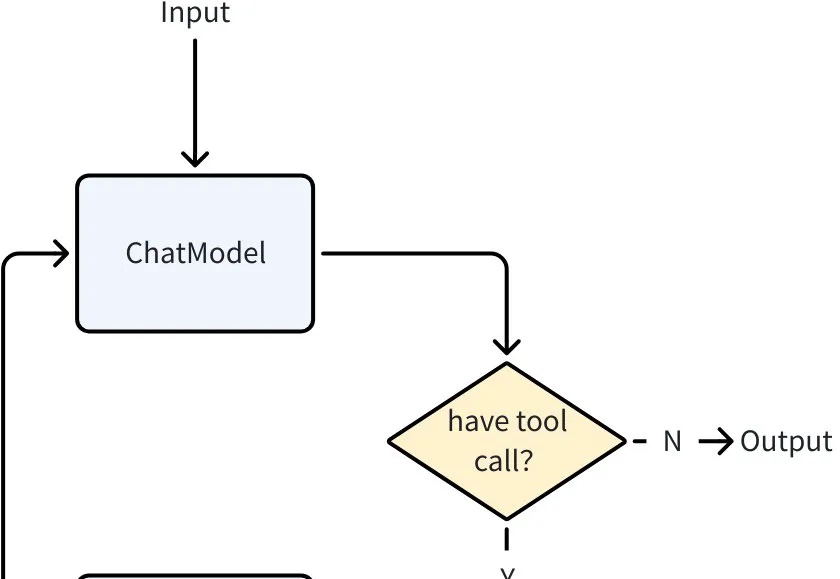

Eino ADK:一文搞定 AI Agent 核心设计模式,从 0 到 1 搭建智能体系统

Eino ADK:一文搞定 AI Agent 核心设计模式,从 0 到 1 搭建智能体系统当大语言模型突破了 “理解与生成” 的瓶颈,Agent 迅速成为 AI 落地的主流形态。从智能客服到自动化办公,几乎所有场景都需要 Agent 来承接 LLM 能力、执行具体任务。

当大语言模型突破了 “理解与生成” 的瓶颈,Agent 迅速成为 AI 落地的主流形态。从智能客服到自动化办公,几乎所有场景都需要 Agent 来承接 LLM 能力、执行具体任务。

AI Coding火了大半年,AI Debugging也来了!刚刚,OpenAI发布由GPT-5驱动的“白帽”Agent——Aardvark(土豚)。这只“AI安全研究员”能帮助开发者和安全团队,在大规模代码库中自动发现并修复安全漏洞。

Flint 的核心理念是将网站从静态资产转变为自主 agent。Michelle 在她的文章中直言不讳地说:"是时候终结传统网站了。我们正在从网站作为静态资产的世界,转向网站成为自主 agent 的世界。"这句话听起来可能有些激进,但当你了解 Flint 的工作原理后,就会明白她为什么如此自信。

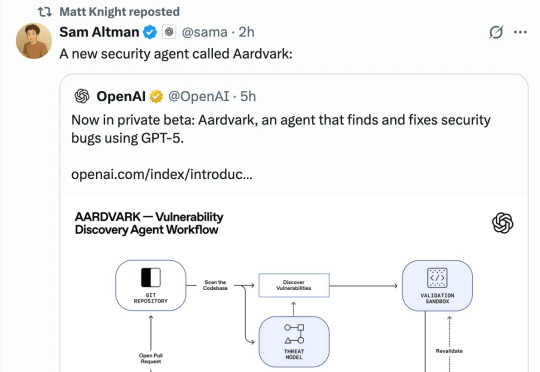

当你被扔进一片数据的汪洋,老板却期待你一眼看穿本质—— 你是否也曾幻想,有一位不知疲倦、全知全能的 AI 数据专家,能替你搞定从数据管理、准备,到分析的一切工作?

这次不仅发布自研编码模型Composer,还重构了IDE交互逻辑,可以最多8个智能体同时跑,早期测试和开发者都说Cursor 2.0真的太快了。Composer的速度是同等模型的4倍。Cursor说这是一款专门为低延迟智能编码打造的模型,大部分任务都可以在30秒以内完成。

AI医学生产力工具开发公司「零假设」近日获近亿元A轮融资,由荷塘创投、国方创新、上海喆驭投资,老股东元禾原点超额认购。本轮融资主要用于打磨、落地场景化AI医学智能体,构建连通药企和医生的学术沟通桥梁。唯快资本长期担任独家融资顾问。

直到我看到 Dedalus Labs 宣布完成 1100 万美元种子轮融资的消息,才意识到有人正在系统性地解决这个问题。这家由 Cathy Di 和 Windsor Nguyen 创立的公司,正在构建一个基础设施层,让开发者能够用 5 行代码就搭建起一个功能完整的 AI agent。这不是夸张的营销话术,而是他们真正在做的事情。

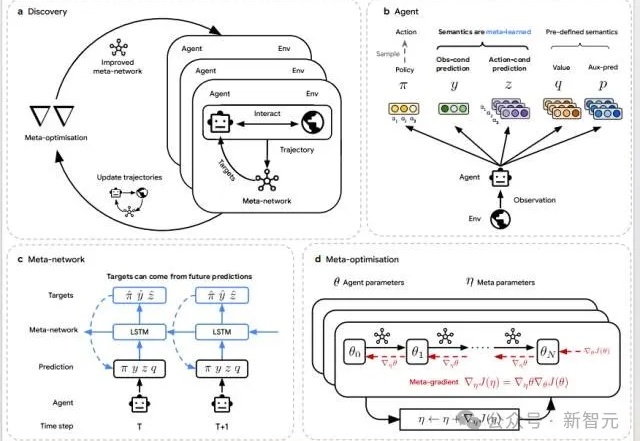

当AI开始「自己学会学习」,人类的角色正在被重写。DeepMind最新研究DiscoRL,让智能体在多环境交互中自主发现强化学习规则——无需人类设计算法。它在Atari基准中击败MuZero,在从未见过的游戏中依旧稳定高效。

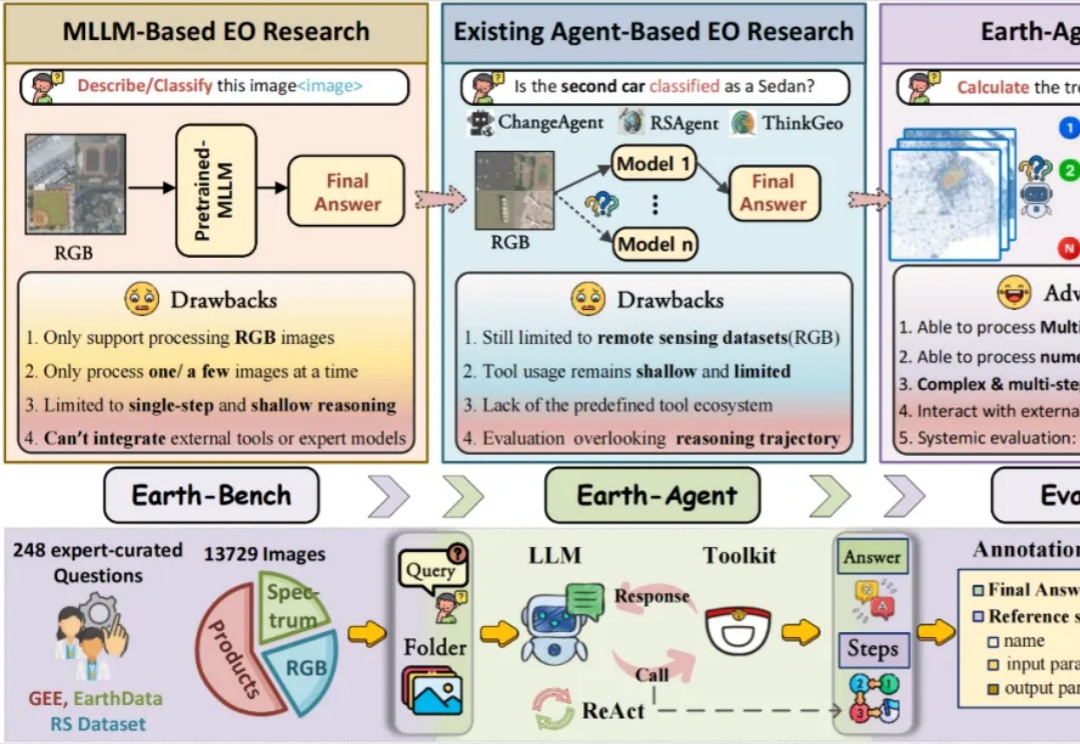

当强大的多模态大语言模型应用于地球科学研究时,它面临着无法忽视的 「阿克琉斯之踵」

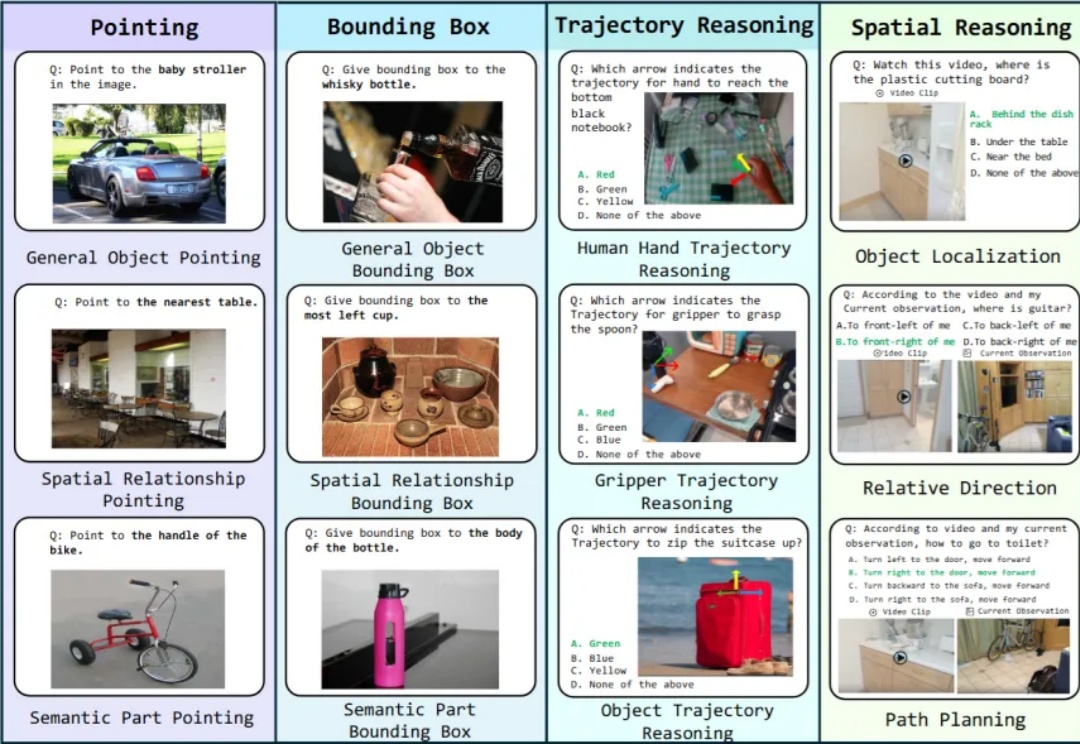

具身智能是近年来非常火概念。一个智能体(比如人)能够在环境中完成感知、理解与决策的闭环,并通过环境反馈不断进入新一轮循环,直至任务完成。这一过程往往依赖多种技能,涵盖了底层视觉对齐,空间感知,到上层决策的不同能力,这些能力便是广义上的具身智能。