数字生活的原生入口:蚂蚁集团发布AI眼镜全新技术框架gPass

数字生活的原生入口:蚂蚁集团发布AI眼镜全新技术框架gPass日前,在 2025 Inclusion・外滩大会上,蚂蚁集团发布了全球首个智能眼镜可信连接技术框架 ——gPass。该技术具备「安全、交互、连接」三大核心能力,致力于实现 AI 眼镜与智能体之间安全、可信、即时信息交互,为用户打造自然无感的服务体验,同时构建起面向眼镜厂商和开发者的安全 AI 数字服务生态。

日前,在 2025 Inclusion・外滩大会上,蚂蚁集团发布了全球首个智能眼镜可信连接技术框架 ——gPass。该技术具备「安全、交互、连接」三大核心能力,致力于实现 AI 眼镜与智能体之间安全、可信、即时信息交互,为用户打造自然无感的服务体验,同时构建起面向眼镜厂商和开发者的安全 AI 数字服务生态。

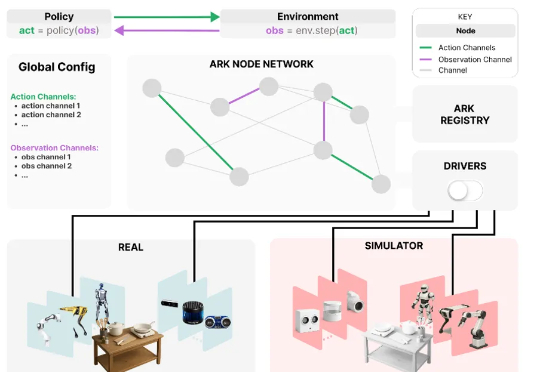

为应对这些挑战,来自华为诺亚方舟实验室,德国达姆施塔特工业大学,英国伦敦大学学院,帝国理工学院和牛津大学的研究者们联合推出了 Ark —— 一个基于 Python 的机器人开发框架,支持快速原型构建,并可便捷地在仿真和真实机器人系统上部署新算法。

噫吁嚱! 那个昔日叱咤风云的开源框架——TensorFlow,已然是行将就木了。

北京深度逻辑智能科技有限公司推出了 LLaSO—— 首个完全开放、端到端的语音语言模型研究框架。LLaSO 旨在为整个社区提供一个统一、透明且可复现的基础设施,其贡献是 “全家桶” 式的,包含了一整套开源的数据、基准和模型,希望以此加速 LSLM 领域的社区驱动式创新。

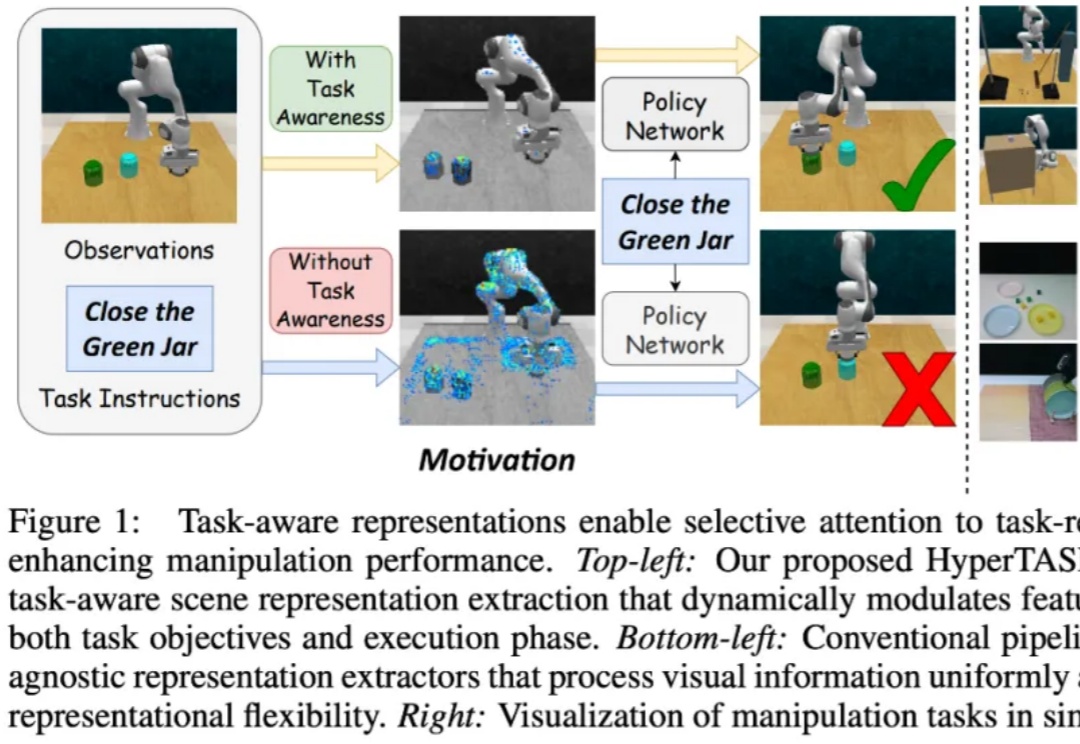

在具身智能中,策略学习通常需要依赖场景表征(scene representation)。然而,大多数现有多任务操作方法中的表征提取过程都是任务无关的(task-agnostic):

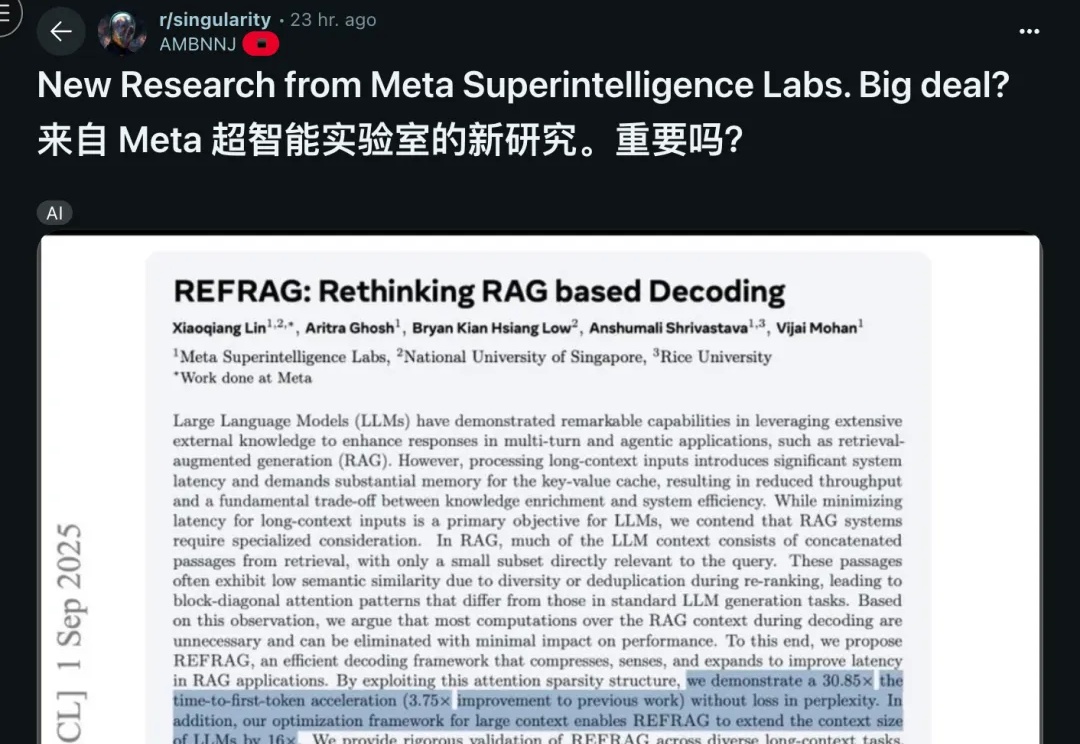

Meta超级智能实验室的首篇论文,来了—— 提出了一个名为REFRAG的高效解码框架,重新定义了RAG(检索增强生成),最高可将首字生成延迟(TTFT)加速30倍。

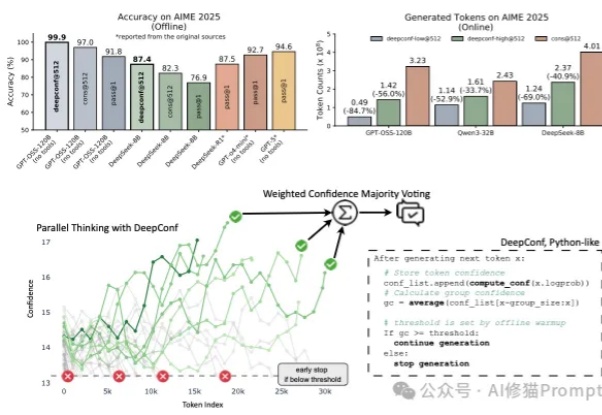

在大型语言模型(LLM)进行数学题、逻辑推理等复杂任务时,一个非常流行且有效的方法叫做 “自洽性”(Self-Consistency),通常也被称为“平行思考”。

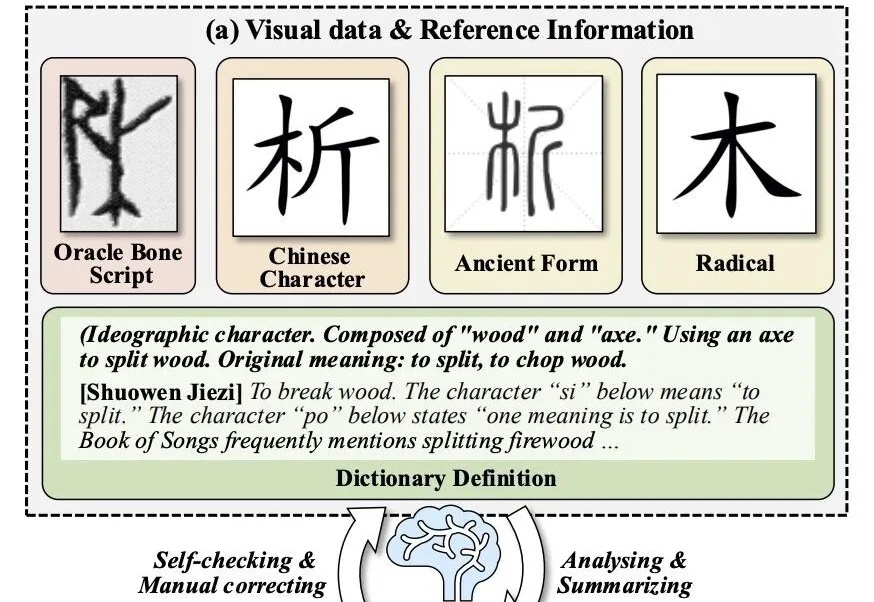

让大模型破译从未见过的甲骨文,准确率拿下新SOTA!

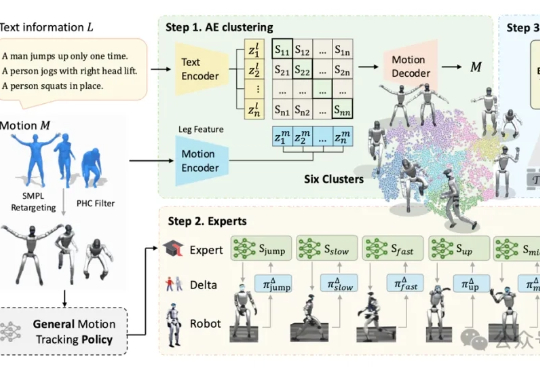

人形机器人对跳舞这件事,如今是越来越擅长了。北京大学与BeingBeyond团队联合研发的BumbleBee系统给出了最新答案:通过创新的“分治-精炼-融合”三级架构,该系统首次实现人形机器人在多样化动作中的稳定控制。

这并非科幻片中的桥段,而是来自清华大学与北京航空航天大学团队的最新成果——BSC-Nav 的真实演示。通过模仿生物大脑构建、维护空间记忆的原理,研究团队让智能体拥有了前所未有的「空间感」。