树搜索也存在「过思考」与「欠思考」?腾讯AI Lab与厦大联合提出高效树搜索框架

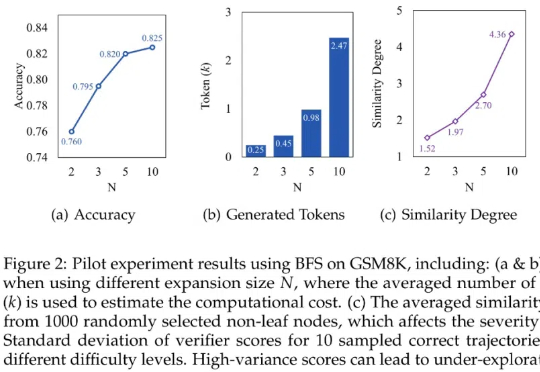

树搜索也存在「过思考」与「欠思考」?腾讯AI Lab与厦大联合提出高效树搜索框架本文探讨基于树搜索的大语言模型推理过程中存在的「过思考」与「欠思考」问题,并提出高效树搜索框架——Fetch。本研究由腾讯 AI Lab 与厦门大学、苏州大学研究团队合作完成。

本文探讨基于树搜索的大语言模型推理过程中存在的「过思考」与「欠思考」问题,并提出高效树搜索框架——Fetch。本研究由腾讯 AI Lab 与厦门大学、苏州大学研究团队合作完成。

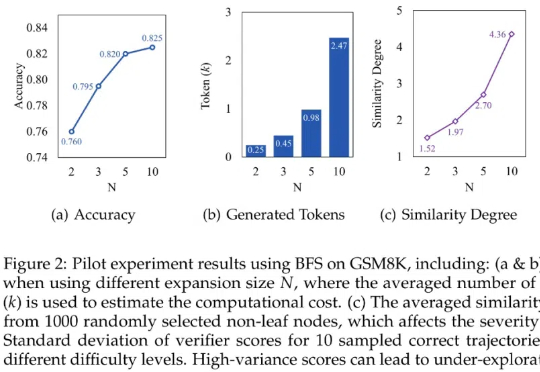

当你要求AI"帮我订一张去纽约的机票"时,它需要理解目标、分解步骤、适应变化,这个过程远比看起来复杂。UC伯克利的研究者们带来了振奋人心的新发现:通过将任务规划和执行分离的PLAN-AND-ACT框架,他们成功将智能体在长期任务中的规划能力提升了54%,创造了新的技术突破。

欧洲初创公司 Pruna AI 一直在研究 AI 模型的压缩算法,该公司的优化框架将于周四开源。Pruna AI 在几个月前完成了 650 万美元的种子轮融资。参与此次初创公司投资的包括 EQT Ventures、Daphni、Motier Ventures 以及 Kima Ventures。

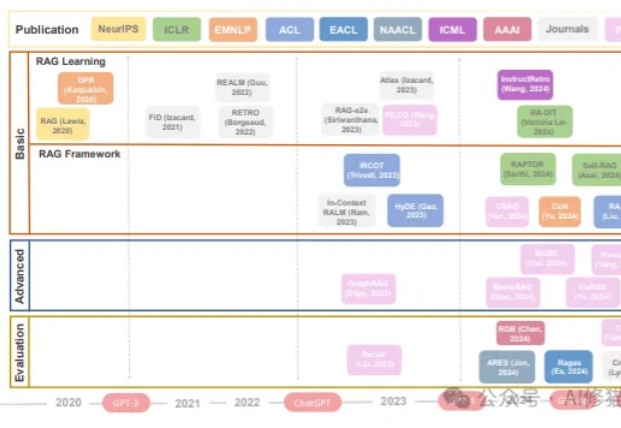

RAG工作发展时间线(2020年至今)。展示了RAG相关研究的三个主要领域:基础(包括RAG学习和RAG框架)、进阶和评估。关键的语言模型(GPT-3、GPT-4等)发展节点标注在时间线上。

现在各种框架满天飞,你是否想过这个问题,一个真正优秀的框架究竟需要多少代码?研究者Zach给出了一个令人惊讶的答案:仅需100行。这个名为PocketFlow的框架不仅体积小到令人难以置信(仅56KB),还能用来构建一个完整的Cursor编码助手。这个发现不仅挑战了我们对框架复杂性的认知,更揭示了一个重要的设计哲学:真正的创新往往来自于化繁为简。

LMM在人类反馈下表现如何?新加坡国立大学华人团队提出InterFeedback框架,结果显示,最先进的LMM通过人类反馈纠正结果的比例不到50%!

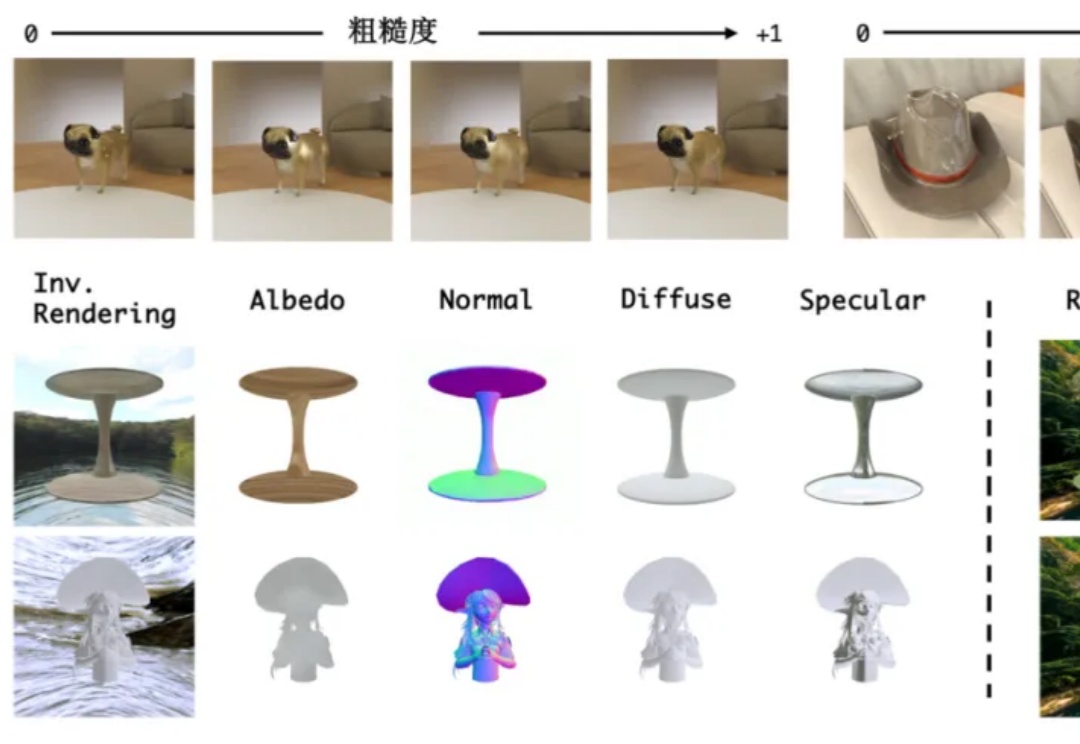

无需物理引擎,单个模型也能实现“渲染+逆渲染”了!

AI-Researcher是一个开源的科研智能体框架,它能从文献搜集一路包办至论文撰写,彻底改变了科研方式,让科研自动化触手可及。

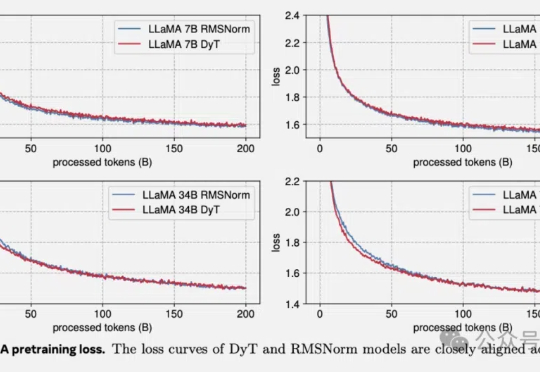

何恺明LeCun联手:Transformer不要归一化了,论文已入选CVPR2025。

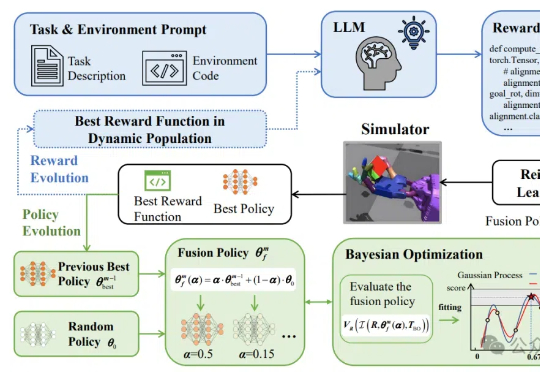

让机器人轻松学习复杂技能有新框架了!