类R1强化学习迁移到视觉定位!全开源Vision-R1将图文大模型性能提升50%

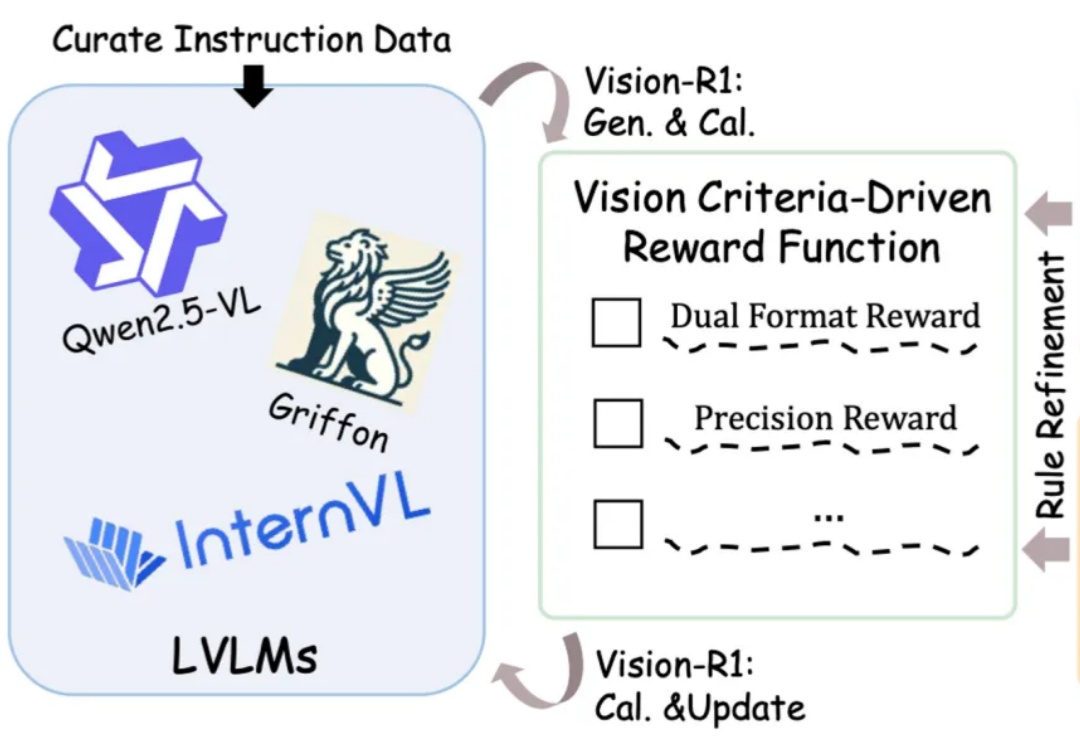

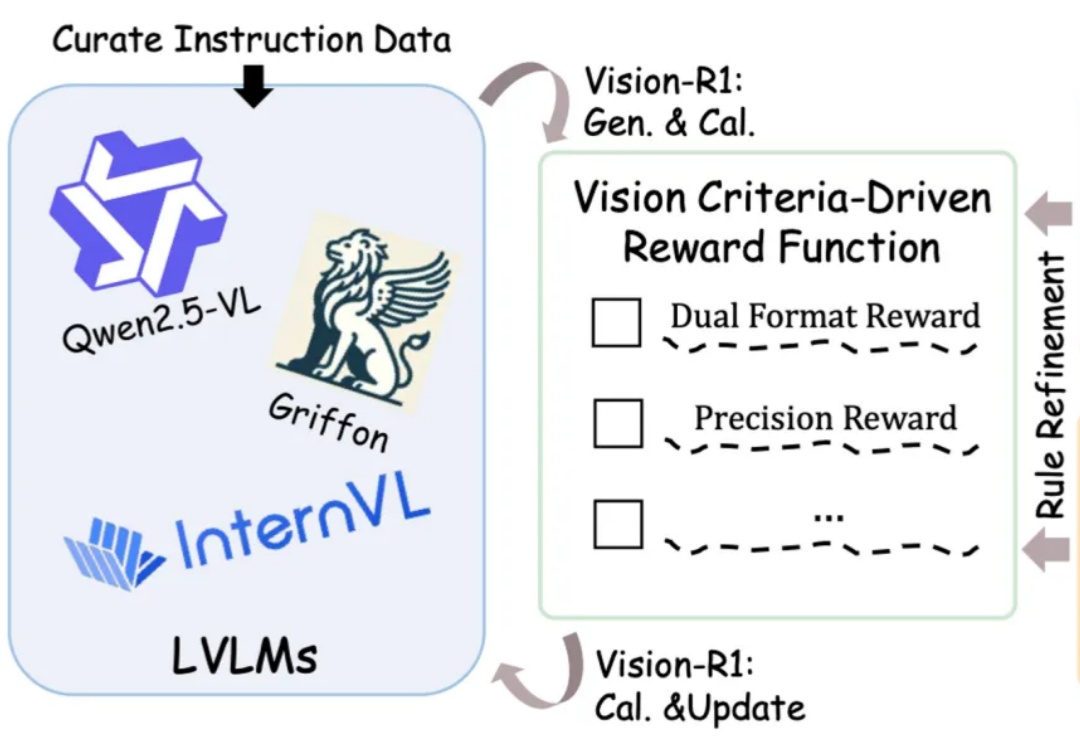

类R1强化学习迁移到视觉定位!全开源Vision-R1将图文大模型性能提升50%图文大模型通常采用「预训练 + 监督微调」的两阶段范式进行训练,以强化其指令跟随能力。受语言领域的启发,多模态偏好优化技术凭借其在数据效率和性能增益方面的优势,被广泛用于对齐人类偏好。目前,该技术主要依赖高质量的偏好数据标注和精准的奖励模型训练来提升模型表现。然而,这一方法不仅资源消耗巨大,训练过程仍然极具挑战。

图文大模型通常采用「预训练 + 监督微调」的两阶段范式进行训练,以强化其指令跟随能力。受语言领域的启发,多模态偏好优化技术凭借其在数据效率和性能增益方面的优势,被广泛用于对齐人类偏好。目前,该技术主要依赖高质量的偏好数据标注和精准的奖励模型训练来提升模型表现。然而,这一方法不仅资源消耗巨大,训练过程仍然极具挑战。

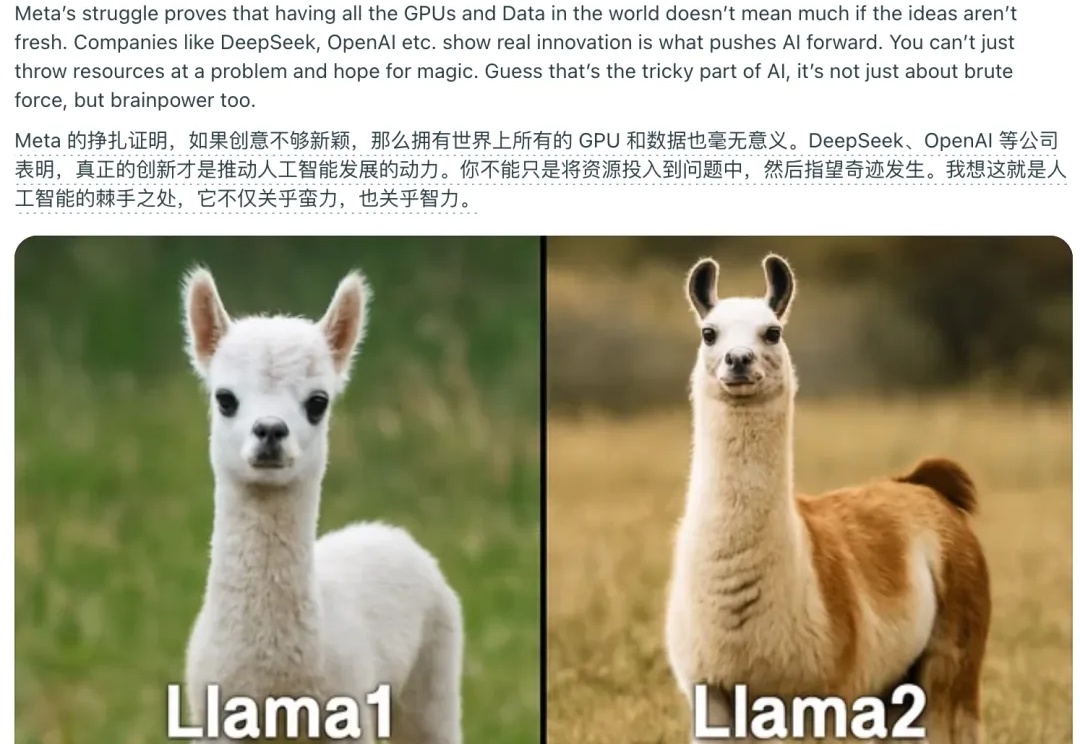

今日凌晨,Meta AI 部门副总裁 Ahmad Al-Dahle 发文,回应了近日发布的 Llama 4 大模型的争议问题:对于「不同服务中模型质量参差不齐」这一问题,Ahmad Al-Dahle 解释称,由于模型一准备好就发布了,所以 Meta 的团队预计所有公开的应用实现都需要几天时间来进行优化调整,团队后续会继续进行漏洞修复工作。

Kimi 开放平台的朋友们,基于 Moonshot AI 一年来的技术积累和性能优化,我们已经在北京时间 2025 年 04 月 07 日 0 点对 Kimi 开放平台提供的模型推理服务进行价格调整,具体调整方案如下:

推理性能提升的同时,还大大减少Token消耗!

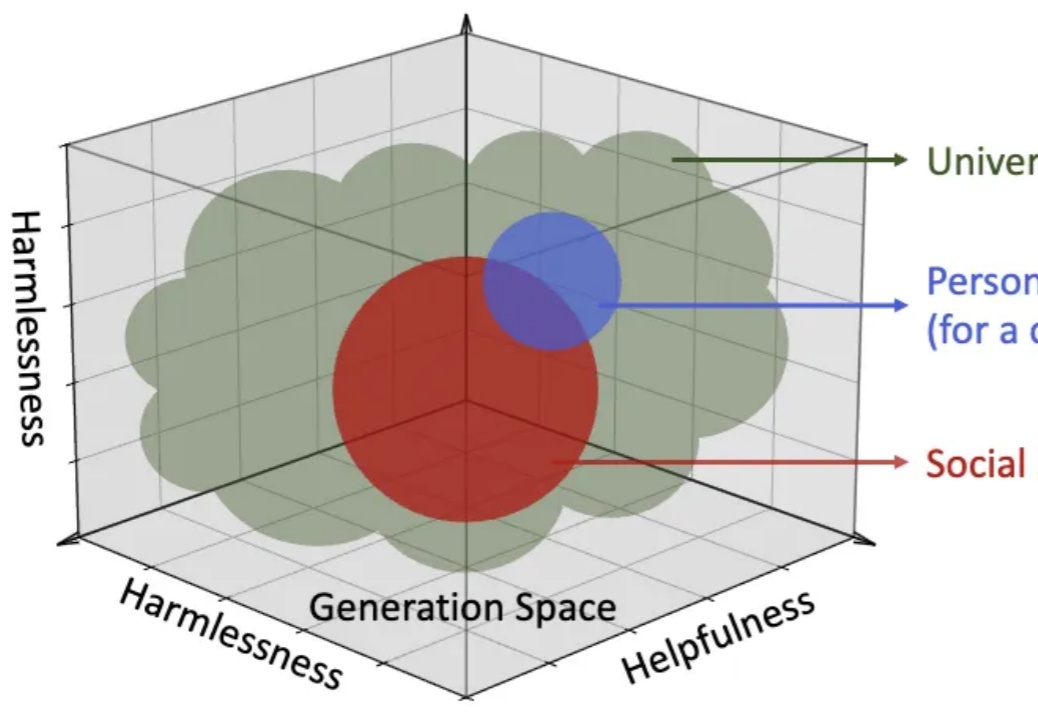

如何让大模型更懂「人」?

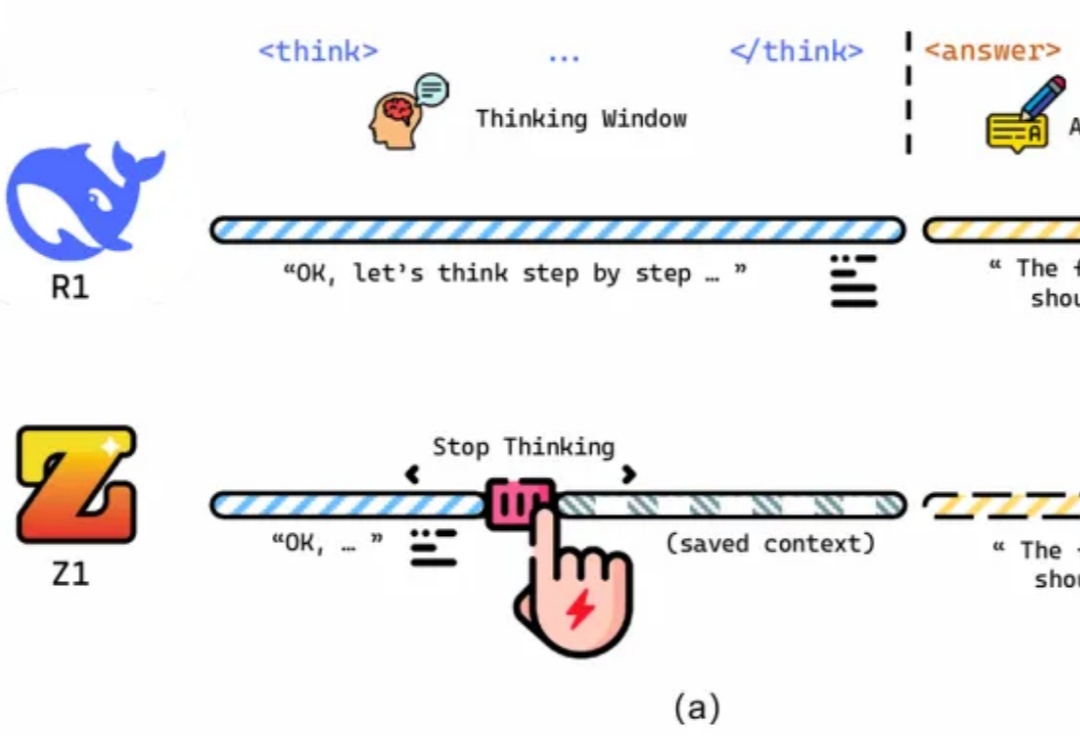

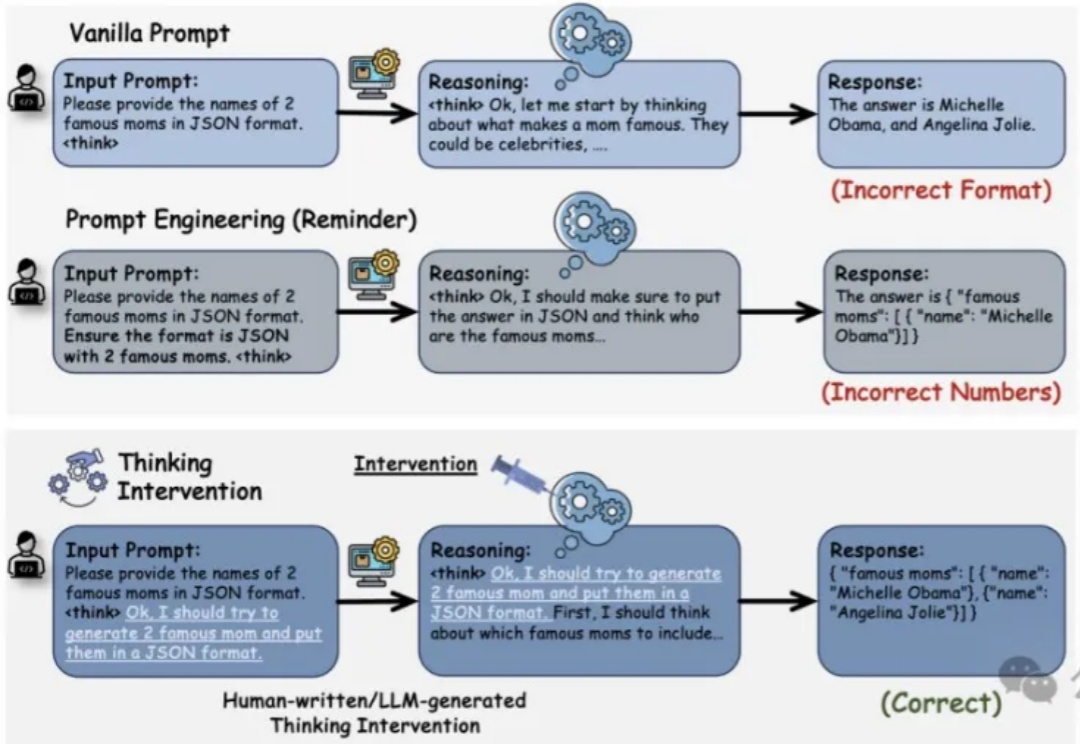

推理增强型大语言模型LRM(如OpenAI的o1、DeepSeek R1和Google的Flash Thinking)通过在生成最终答案前显式生成中间推理步骤,在复杂问题解决方面展现了卓越性能。然而,对这类模型的控制仍主要依赖于传统的输入级操作,如提示工程(Prompt Engineering)等方法,而你可能已经发现这些方法存在局限性。

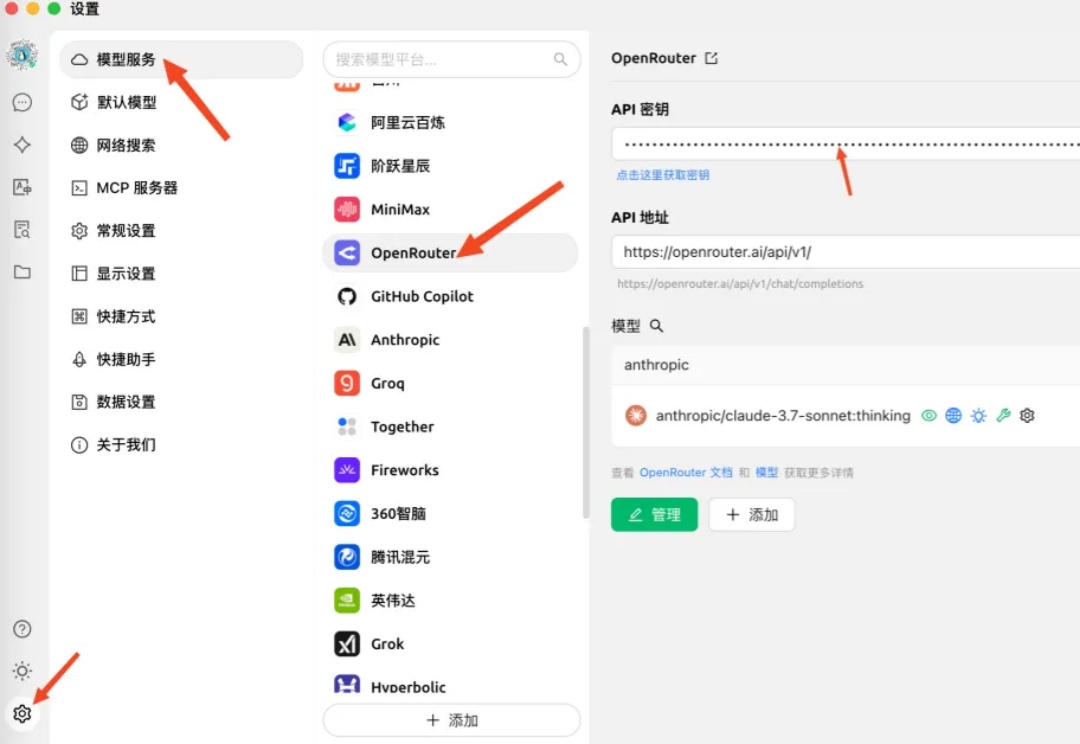

AI菩萨OpenRouter连发两大招宣布推出两项重大更新。

Meta最新基础模型Llama 4发布36小时后,评论区居然是这个画风:

「未来,99% 的 attention 将是大模型 attention,而不是人类 attention。」这是 AI 大牛 Andrej Karpathy 前段时间的一个预言。这里的「attention」可以理解为对内容的需求、处理和分析。也就是说,他预测未来绝大多数资料的处理工作将由大模型来完成,而不是人类。

Noprop:没有反向传播或前向传播,也能训练神经网络。