万字解构“幻觉陷阱”:人类与AI共生的长期难题丨AGI之路04期

万字解构“幻觉陷阱”:人类与AI共生的长期难题丨AGI之路04期人类实现AGI之前,在技术、商业、治理方面仍然存在诸多问题——“人与AI能否共处” “算力叙事是否依然奏效” “开源有多大商业价值”等,腾讯科技策划《AGI之路》系列直播,联合合作伙伴,特邀专家、学者直播解读相关议题,对齐AGI共识,探寻AGI可行之路。

人类实现AGI之前,在技术、商业、治理方面仍然存在诸多问题——“人与AI能否共处” “算力叙事是否依然奏效” “开源有多大商业价值”等,腾讯科技策划《AGI之路》系列直播,联合合作伙伴,特邀专家、学者直播解读相关议题,对齐AGI共识,探寻AGI可行之路。

本文提出了一种轨迹级别 SE (3) 等变的扩散策略(ET-SEED),通过将等变表示学习和扩散策略结合,使机器人能够在极少的示范数据下高效学习复杂操作技能,并能够泛化到不同物体姿态和环境中。

刚刚,OpenAI被爆三类智能体定价!价格从每月2k美元到20k美元不等,用于自动化编码和博士级别的研究等任务。此前,美国国家实验室使用OpenAI的o1模型来解决了与核聚变相关的问题。

今夜,Manus发布之后,随之而来赶到战场的,是阿里。

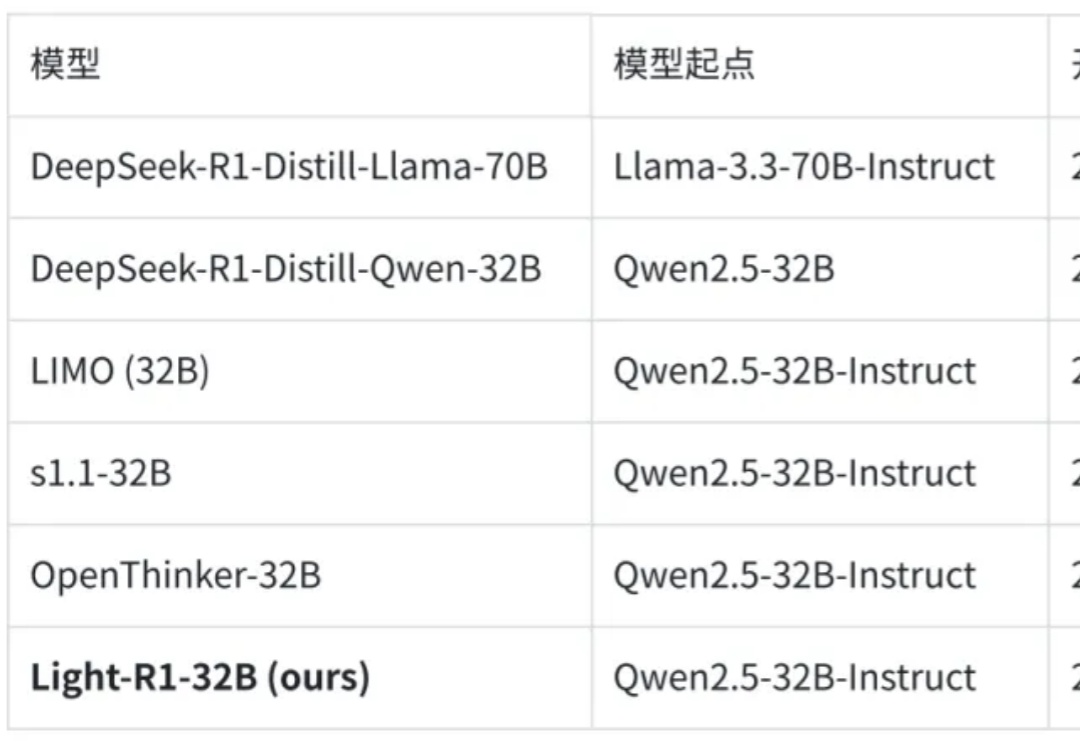

2025 年 3 月 4 日,360 智脑开源了 Light-R1-32B 模型,以及全部训练数据、代码。仅需 12 台 H800 上 6 小时即可训练完成,从没有长思维链的 Qwen2.5-32B-Instruct 出发,仅使用 7 万条数学数据训练,得到 Light-R1-32B

播客录制和编辑平台 Podcastle ,如今也加入了 AI 文本转语音竞赛,发布了其名为 Asyncflow v1.0 的 AI 模型。同时,还将为开发者提供 API,使他们能够直接将文本转语音模型集成到自己的应用中。

据消息报道,Meta Platforms 准备发展并运行AI聊天机器人,以吸引Messenger 和 WhatsApp 等企业。作为拥挤市场中的新来者,Meta 将其商业 AI 聊天机器人定位为提供客户支持、信息和推荐,以促进销售的工具。

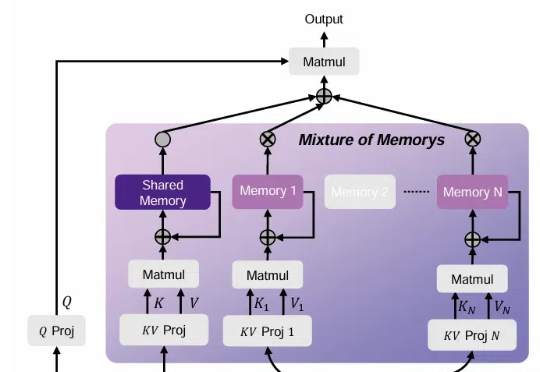

LLM一个突出的挑战是如何有效处理和理解长文本。就像下图所示,准确率会随着上下文长度显著下降,那么究竟应该怎样提升LLM对长文本理解的准确率呢?

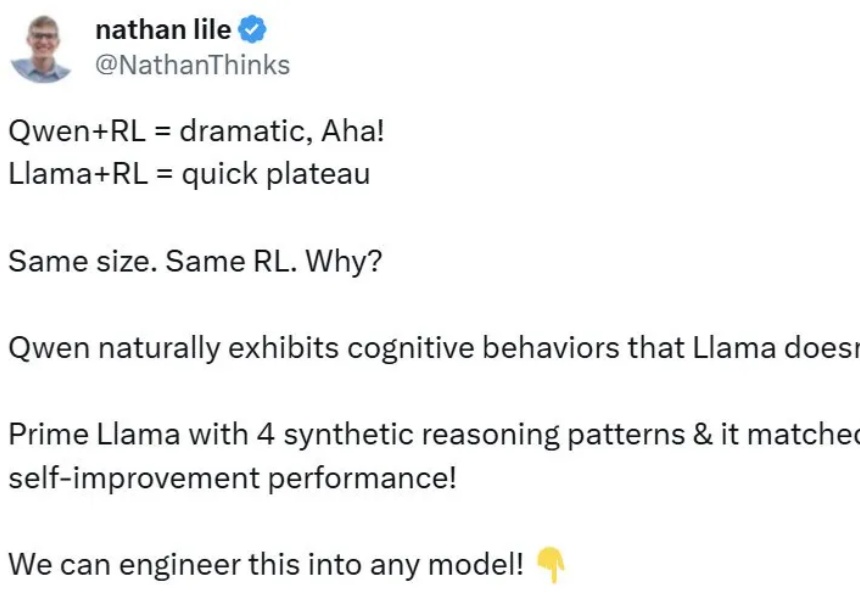

回顾 AGI 的爆发,从最初的 pre-training (model/data) scaling,到 post-training (SFT/RLHF) scaling,再到 reasoning (RL) scaling,找到正确的 scaling 维度始终是问题的本质。

虽然 Qwen「天生」就会检查自己的答案并修正错误。但找到原理之后,我们也能让 Llama 学会自我改进。