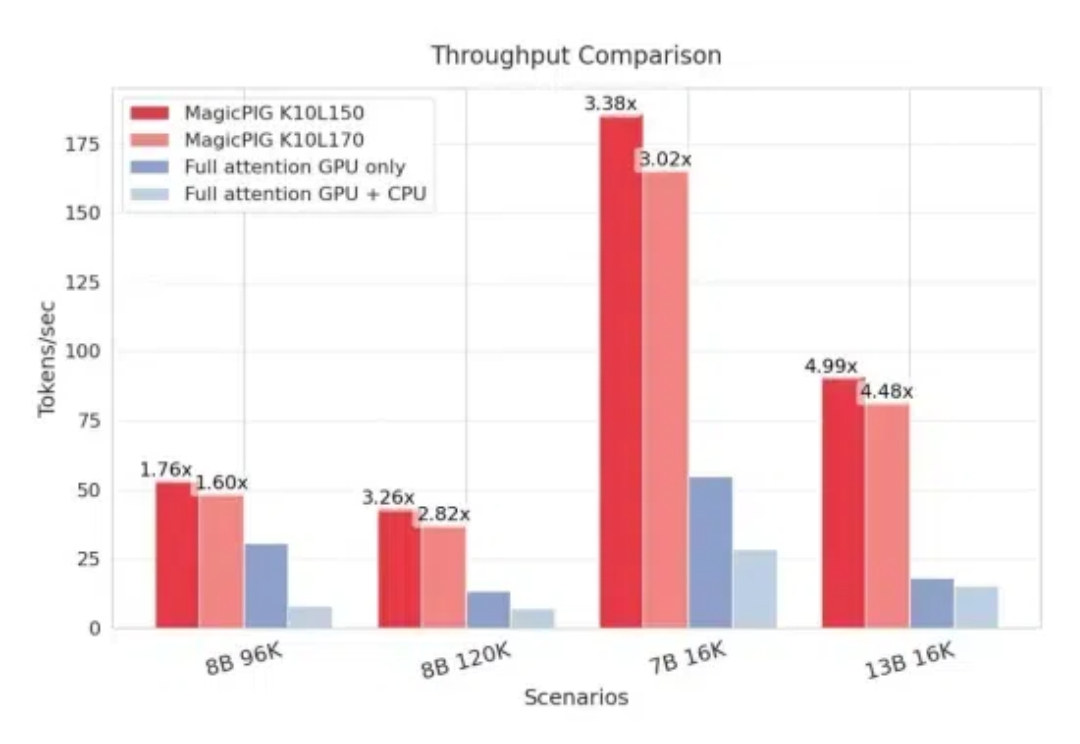

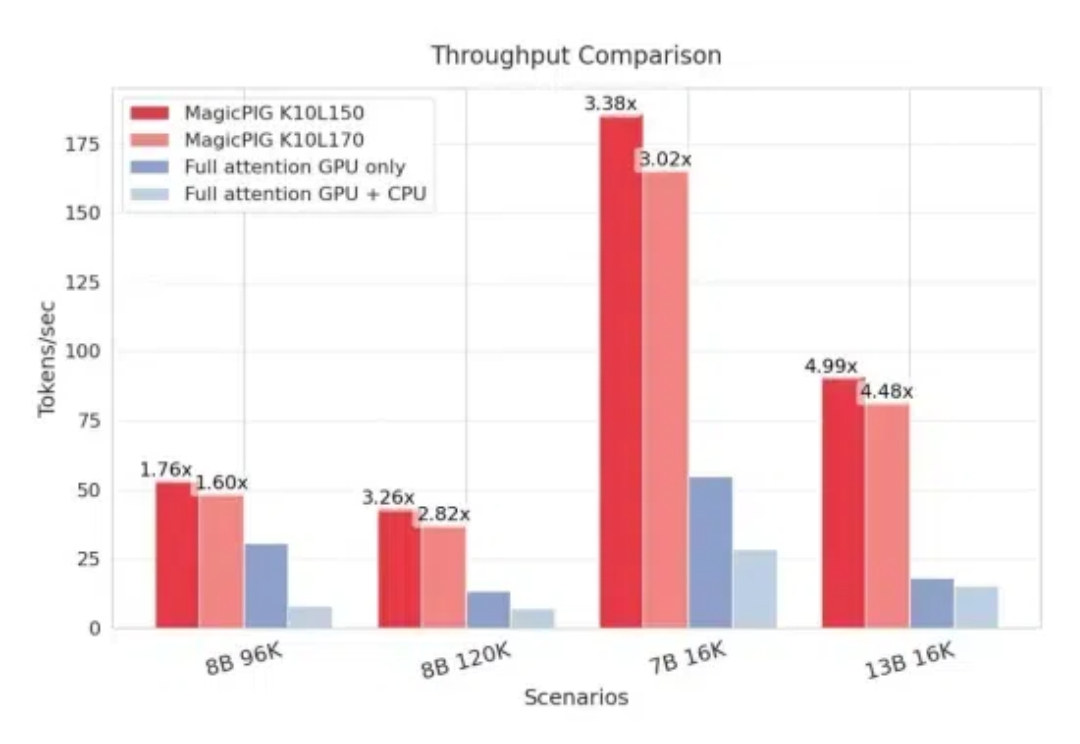

把注意力计算丢给CPU,大模型解码吞吐量提高1.76~4.99倍

把注意力计算丢给CPU,大模型解码吞吐量提高1.76~4.99倍CPU+GPU,模型KV缓存压力被缓解了。 来自CMU、华盛顿大学、Meta AI的研究人员提出MagicPIG,通过在CPU上使用LSH(局部敏感哈希)采样技术,有效克服了GPU内存容量限制的问题。

CPU+GPU,模型KV缓存压力被缓解了。 来自CMU、华盛顿大学、Meta AI的研究人员提出MagicPIG,通过在CPU上使用LSH(局部敏感哈希)采样技术,有效克服了GPU内存容量限制的问题。

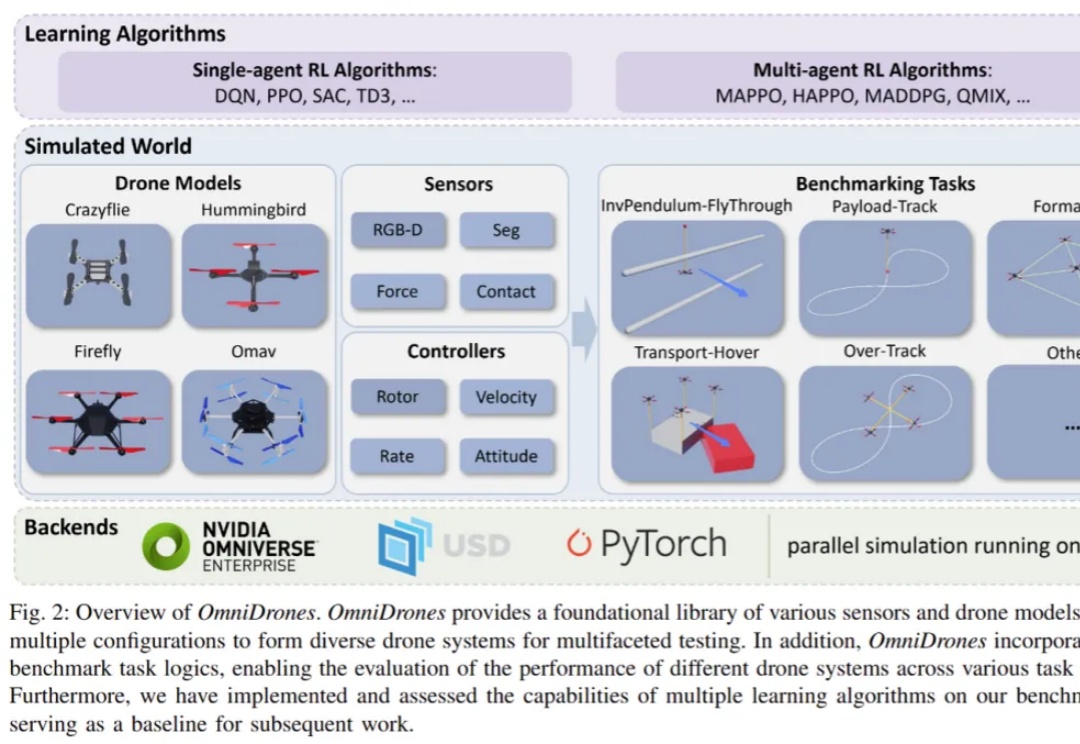

控制无人机执行敏捷、高机动性的行为是一项颇具挑战的任务。传统的控制方法,比如 PID 控制器和模型预测控制(MPC),在灵活性和效果上往往有所局限。而近年来,强化学习(RL)在机器人控制领域展现出了巨大的潜力。通过直接将观测映射为动作,强化学习能够减少对系统动力学模型的依赖。

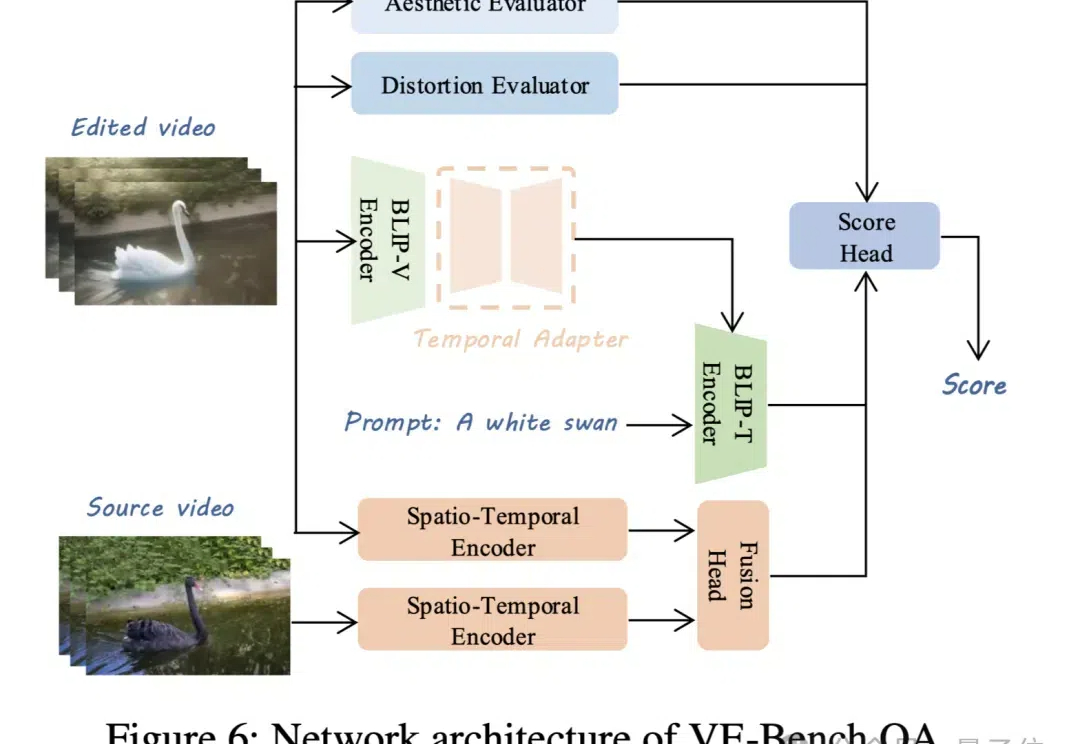

视频生成模型卷得热火朝天,配套的视频评价标准自然也不能落后。 现在,北京大学MMCAL团队开发了首个用于视频编辑质量评估的新指标——VE-Bench,相关代码与预训练权重均已开源。

DeepSeek新版模型正式发布,技术大佬们都转疯了! 延续便宜大碗特点的基础之上,DeepSeek V3发布即完全开源,直接用了53页论文把训练细节和盘托出的那种。

现在是夜里1点,我准备了一些素材,正打开可灵,想跑一些关于AI拥抱的视频。 然后,发现给我弹了个窗,悄悄的,在深夜,可灵AI里面生图的模型-可图,更新了。

“人类将在2029年实现AGI。” 这是2006年,雷·库兹韦尔(Ray Kurzweil)在波士顿人工智能大会上发出的惊人之语。

据不完全统计,已有24家券商积极拥抱AI大模型,在投研、投顾、风控、运营等多个领域展开了深入探索和应用。

在今天的文章开始前,小雷想问大家一个问题:你的手机上,用的是什么输入法? 小雷问了问身边人,回答无非是:搜狗、讯飞、百度和近些年异军突起的微信输入法,大部分人到手都会安装自己顺手的输入法,其中只有极少人会长期使用自带输入法。

12月10日Sora全网上线,大家也都测试了很多了。坦率地讲,产品完成度很高,但是模型质量,真的有点不及预期。

在 2024 年底,探索通用人工智能(AGI)本质的 DeepSeek AI 公司开源了最新的混合专家(MoE)语言模型 DeepSeek-V3-Base。虽然,目前没有放出详细的模型卡,但官方开源了V3的技术文档PDF。