OpenAI直播第二弹!奥特曼2024年最大惊喜竟来自字节?强化微调让o1-mini逆袭o1

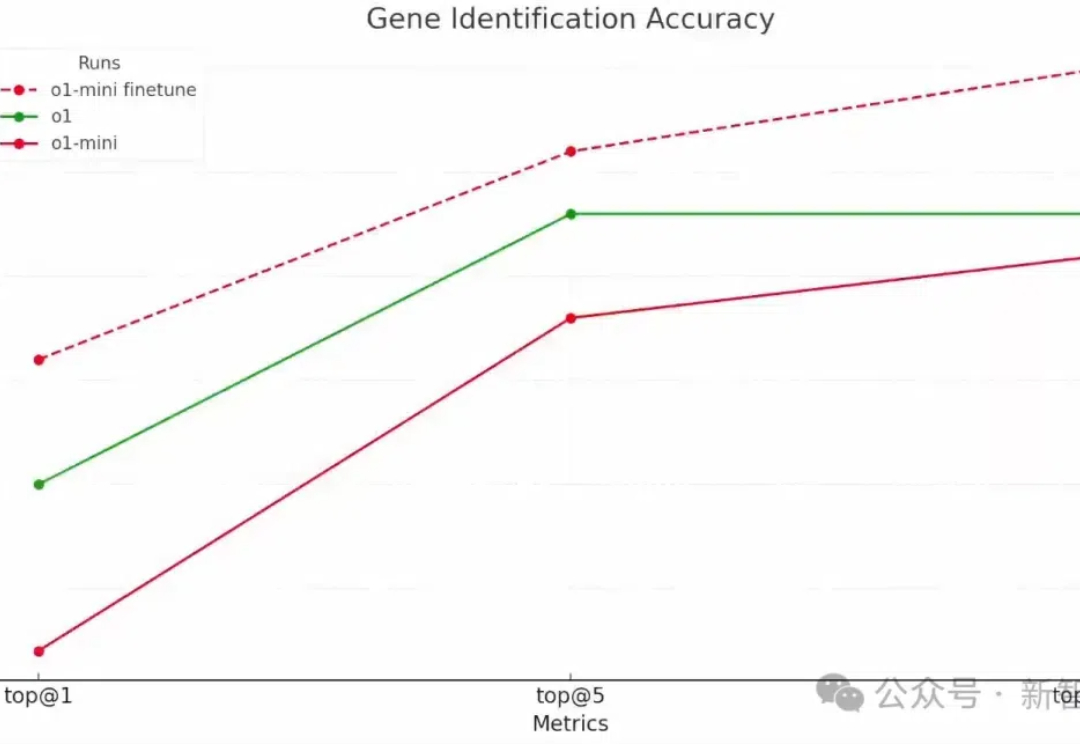

OpenAI直播第二弹!奥特曼2024年最大惊喜竟来自字节?强化微调让o1-mini逆袭o1OpenAI第二天的直播,揭示了强化微调的强大威力:强化微调后的o1-mini,竟然全面超越了地表最强基础模型o1。而被奥特曼称为「2024年我最大的惊喜」的技术,技术路线竟和来自字节跳动之前公开发表的强化微调研究思路相同。

OpenAI第二天的直播,揭示了强化微调的强大威力:强化微调后的o1-mini,竟然全面超越了地表最强基础模型o1。而被奥特曼称为「2024年我最大的惊喜」的技术,技术路线竟和来自字节跳动之前公开发表的强化微调研究思路相同。

那时GPT-2刚刚发布,我很清楚技术的发展轨迹,这样的模型表面上是互联网或网页的模型,但肯定会带来一些非常有趣的东西。于是我打电话给Nick和其他的朋友们,我说“我们应该弄清楚怎么打造这些东西”。

OpenAI“双12”刚进行到第二天,就把大模型圈搅得好不热闹! 一边是Meta没预告就发布了Llama 3.3,70B版本就能实现以前405B的性能。

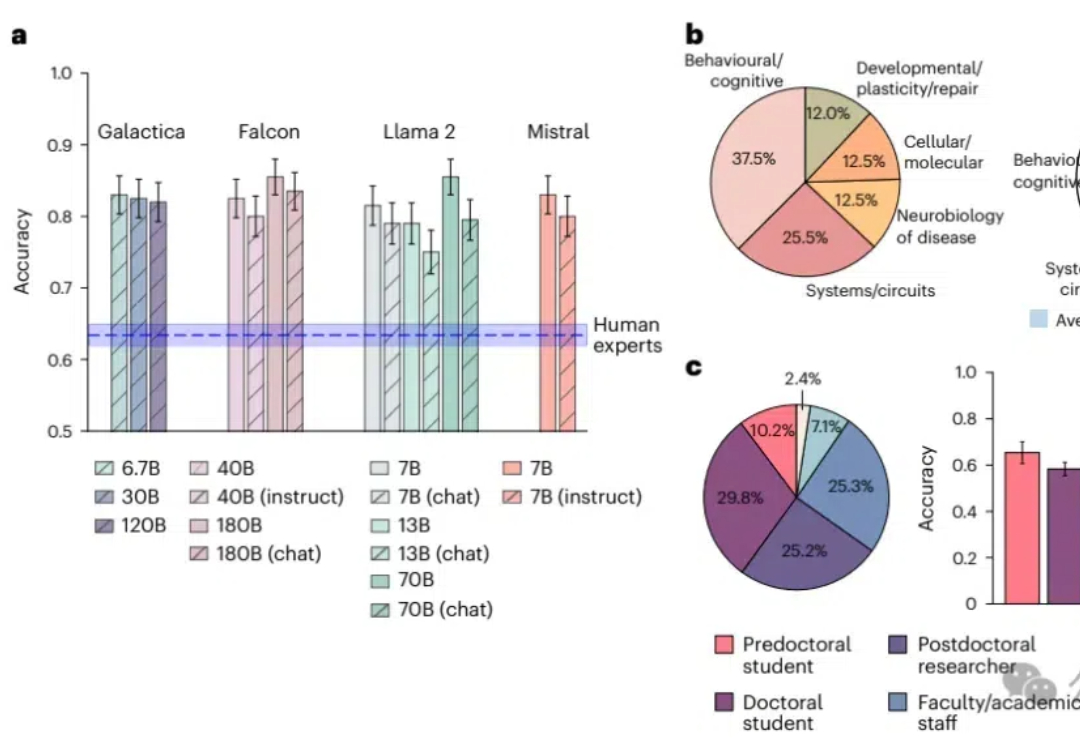

知识密集型工作也败了!大型语言模型在预测神经科学结果方面超越了人类专家,平均准确率达到81%,而人类专家仅为63%;模型通过整合大量文献数据,展现出了惊人的前瞻性预测能力,预示着未来科研工作中人机协作的巨大潜力。

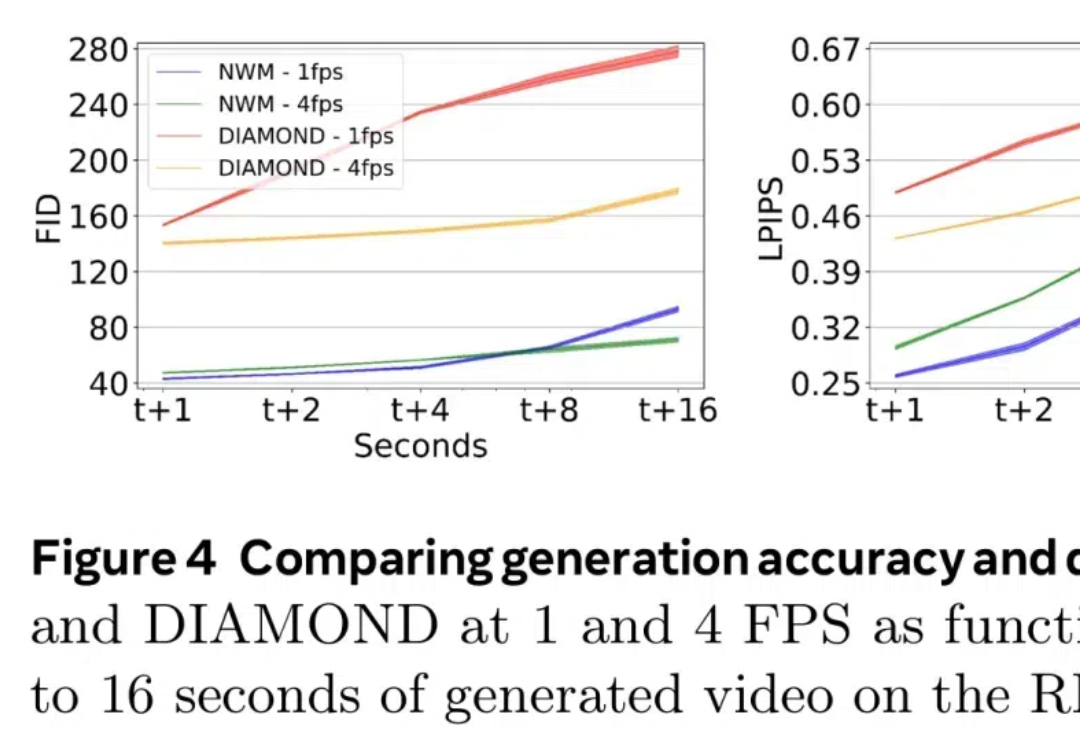

最近,世界模型(World Models)似乎成为了 AI 领域最热门的研究方向。

在人工智能发展史上,强化学习 (RL) 凭借其严谨的数学框架解决了众多复杂的决策问题,从围棋、国际象棋到机器人控制等领域都取得了突破性进展。

人类离AGI究竟还有多远?最新一期Nature文章,从以往研究分析、多位大佬言论深入探讨了LLM在智能化道路上突破与局限。

以 GPT4V 为代表的多模态大模型(LMMs)在大语言模型(LLMs)上增加如同视觉的多感官技能,以实现更强的通用智能。虽然 LMMs 让人类更加接近创造智慧,但迄今为止,我们并不能理解自然与人工的多模态智能是如何产生的。

原通义千问大模型技术负责人周畅(花名:钟煌)于 7 月 18 日被曝将离职创业,然而在 10 月 23 日,就有消息称周畅已经低调加入了字节跳动。

强化微调可以轻松创建具备强大推理能力的专家模型。