写给小白的大模型入门科普

写给小白的大模型入门科普网上关于大模型的文章也很多,但是都不太容易看懂。小枣君今天试着写一篇,争取做到通俗易懂。

网上关于大模型的文章也很多,但是都不太容易看懂。小枣君今天试着写一篇,争取做到通俗易懂。

近日,Physical Intelligence和星尘智能宣告牵手,在数据和模型层展开合作,推进通用人工智能进入物理世界,共筑世界模型。

简单性可以扩展:PyTorch的成功源于其对研究人员简单性的关注,这种关注随后流向了生产环境。在Fireworks,他们在幕后拥抱了巨大的复杂性,以提供一个简单的API给开发者。这种方法让客户能够专注于创新和产品设计,而不是纠结于技术复杂性。

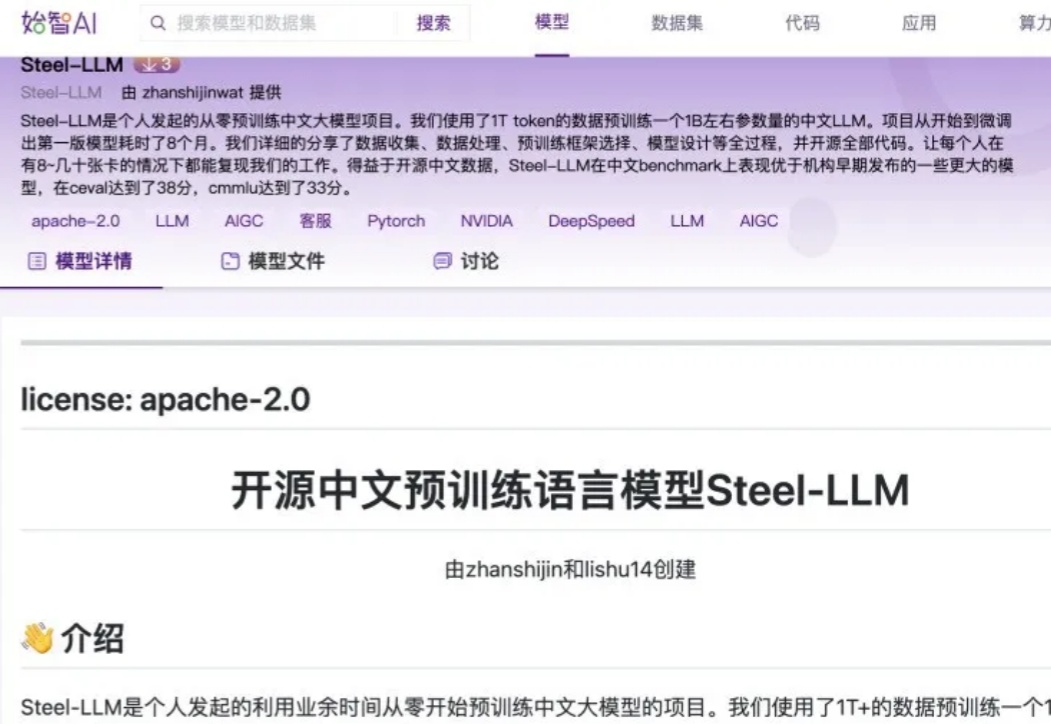

随着开源数据的日益丰富以及算力价格的持续下降,对于个人或小型机构而言,预训练一个小型的 LLM 已逐渐成为可能。开源中文预训练语言模型 Steel - LLM 就是一个典型案例,其模型参数量与数据量并非十分庞大,基本处于参数量为 B 级别、数据量为 T 级别的规模。

人类离电影《黑客帝国》的场景,似乎又近了一步。

5年,5000万个神经网络,这个世界从未被扫描过的角落,我们都能看到了。宝可梦GO团队,竟然抢先实现了李飞飞的「空间智能」?而「Pokémon Go」的玩家可能没想到,自己居然在训练着一个巨大的AI模型。

11月16日,陷入前投资人仲裁风波的主角杨植麟突然出现,并对外发布了一款数学模型。 杨植麟将自己的数学模型k0-math对标OpenAI o1系列,主打深入思考。

在2024年的AI领域,我们正在见证一个有趣的转折。 OpenAI的进展节奏明显放缓,GPT-5迟迟未能问世,“Scaling Law”成了天方夜谭,即便是年初震撼业界的视频生成模型Sora,也未能如期实现“全面开放”的承诺。

2024年世界互联网大会领先科技奖揭晓,文心智能体技术获奖!至此,百度大模型技术已连续两年获得该奖。

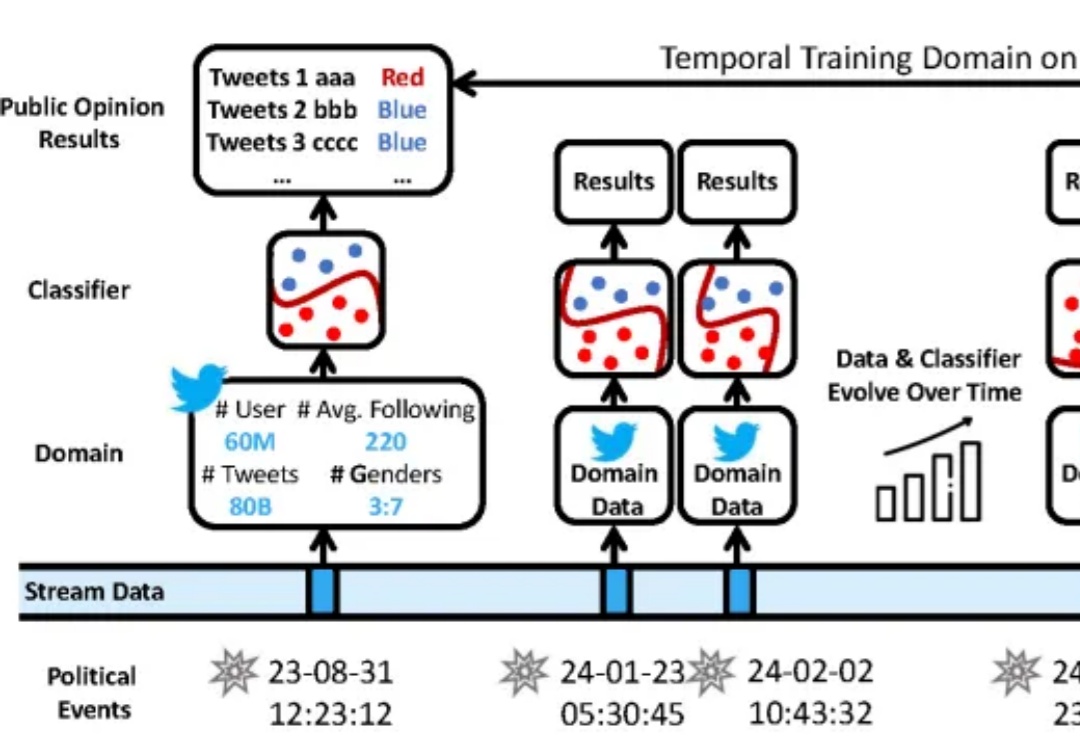

在数据分布持续变化的动态环境中,如何进行连续模型泛化?