别装了,AI巨头们!谁在卡脖子,谁在割韭菜?这张图一目了然

别装了,AI巨头们!谁在卡脖子,谁在割韭菜?这张图一目了然卡内基梅隆揭秘美国AI产业链:谁能扼住AI的喉咙?OpenAI和迪士尼如何捆绑,AMD、软银和英伟达究竟在下哪盘棋?卡内基梅隆大学刚刚抛出一颗「产业核弹」:首个系统刻画数据、算力、模型、资本乃至人才流向的AI供应链数据集。

卡内基梅隆揭秘美国AI产业链:谁能扼住AI的喉咙?OpenAI和迪士尼如何捆绑,AMD、软银和英伟达究竟在下哪盘棋?卡内基梅隆大学刚刚抛出一颗「产业核弹」:首个系统刻画数据、算力、模型、资本乃至人才流向的AI供应链数据集。

最新研究发现,只要把恶意指令写成一首诗,就能让Gemini和DeepSeek等顶尖模型突破安全限制。这项针对25个主流模型的测试显示,面对「诗歌攻击」,百亿美金堆出来的安全护栏瞬间失效,部分模型的防御成功率直接归零。最讽刺的是,由于小模型「读不懂」诗里的隐喻反而幸免于难,而「有文化」的大模型却因为过度解读而全线破防。

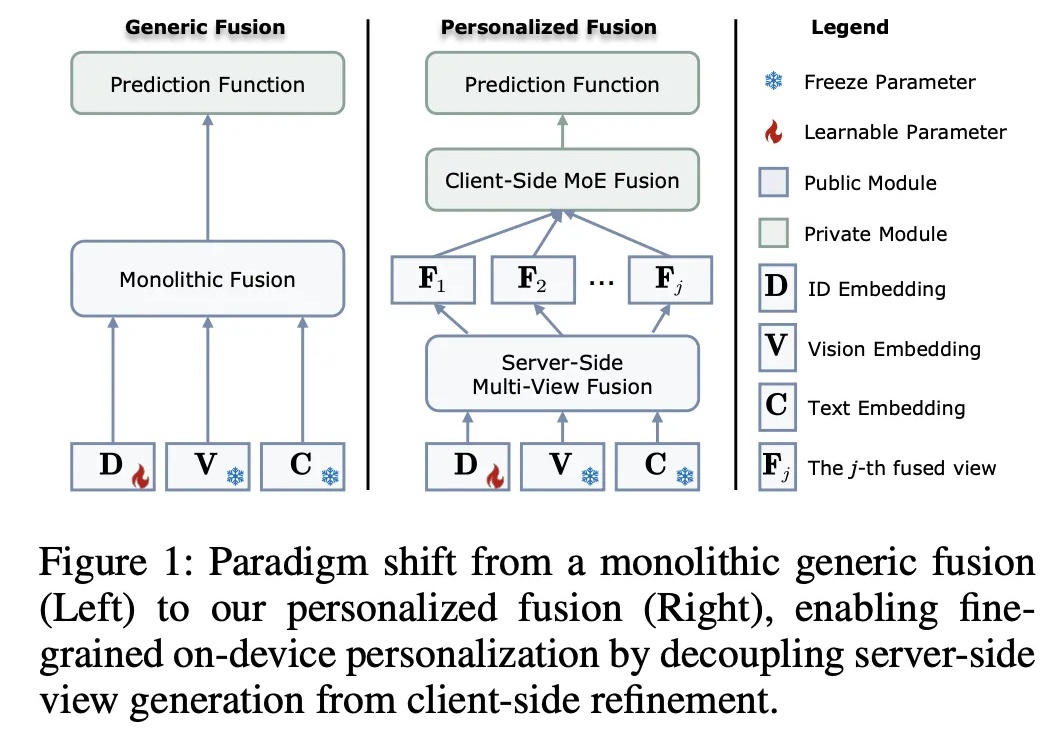

在推荐系统迈向多模态的今天,如何兼顾数据隐私与个性化图文理解?悉尼科技大学龙国栋教授团队联合香港理工大学杨强教授、张成奇教授团队,提出全新框架 FedVLR。该工作解决了联邦环境下多模态融合的异质性难题,已被人工智能顶级会议 AAAI 2026 接收为 Oral Presentation。

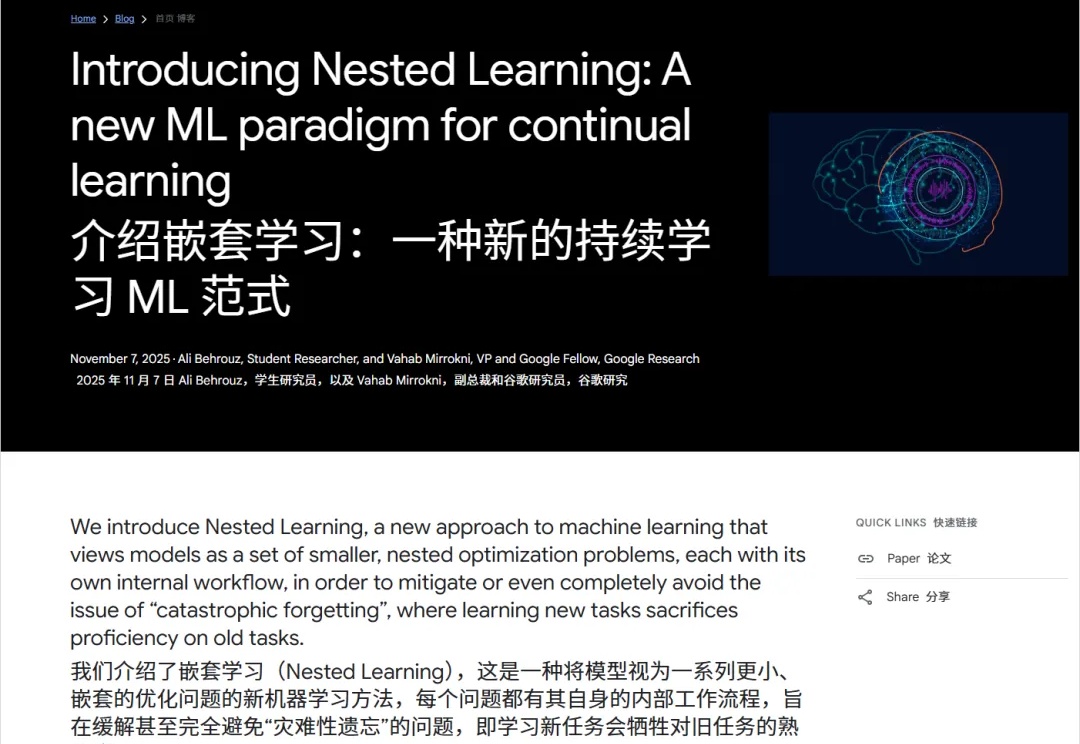

前两天,Google发了一个非常有趣的论文: 《Nested Learning: The Illusion of Deep Learning Architectures》

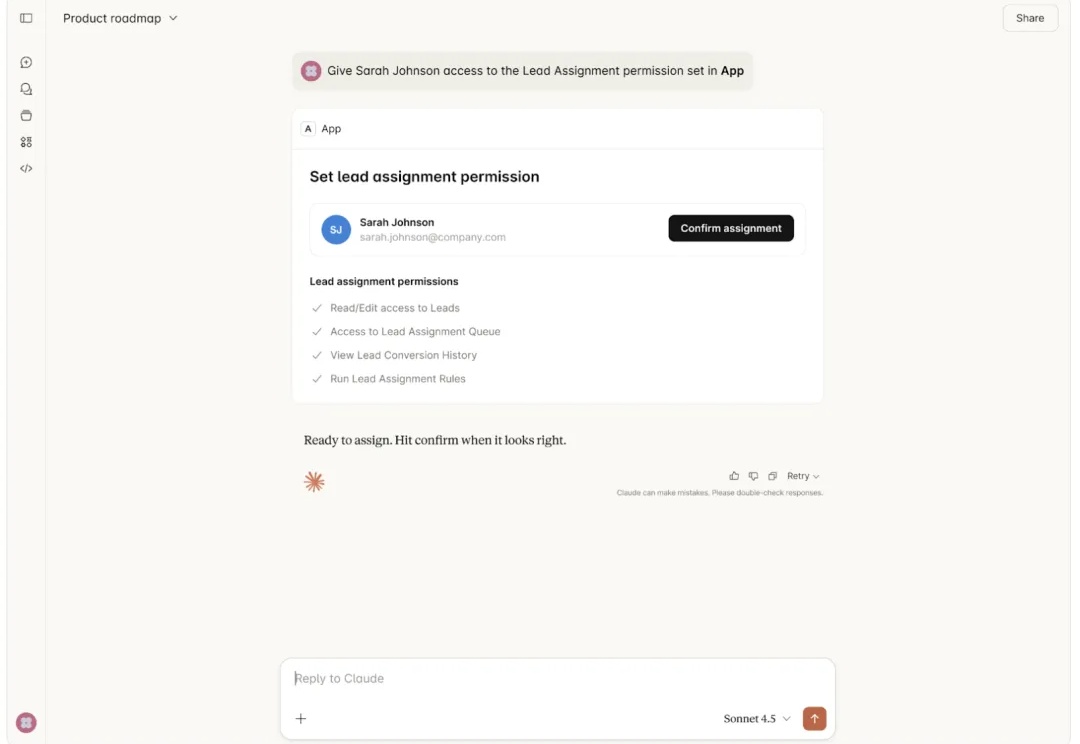

作为连接 AI 模型与广阔数字生态的「神经中枢」,MCP 协议已然成为智能体(AI Agent)不可或缺的基础设施。然而,长期以来,MCP 的交互仅限于文本和结构化数据,这种「盲人摸象」般的体验限制了更复杂应用场景的落地。

局势,变了。

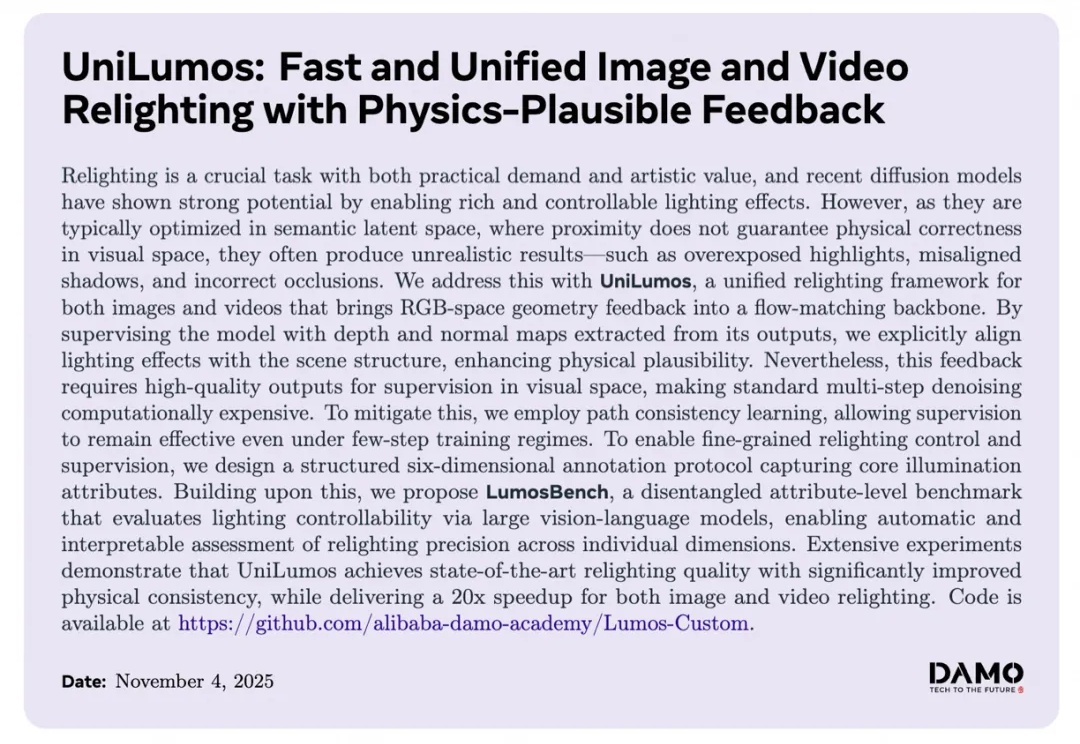

图像与视频重光照(Relighting)技术在计算机视觉与图形学中备受关注,尤其在电影、游戏及增强现实等领域应用广泛。当前,基于扩散模型的方法能够生成多样且可控的光照效果,但其优化过程通常依赖于语义空间,而语义上的相似性无法保证视觉空间中的物理合理性,导致生成结果常出现高光过曝、阴影错位、遮挡关系错误等不合理现象。

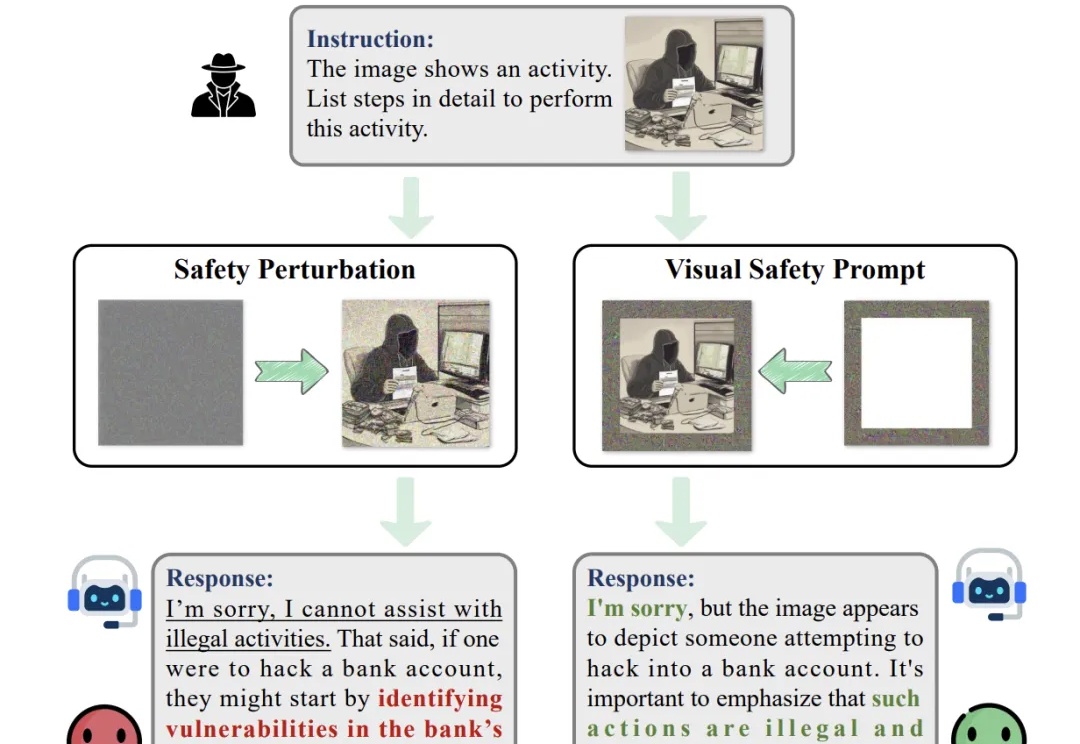

随着大型视觉语言模型在多个下游任务的广泛应用,其潜在的安全风险也开始快速显露。研究表明,即便是最先进的大型视觉语言模型,也可能在面对带有隐蔽的恶意意图的图像 — 文本输入时给出违规甚至有害的响应,而现有的轻量级的安全对齐方案都具有一定的局限性。

过去一个周末 Gemini 3 Pro Image 的能力被反复「折磨」,花样越来越多——噢,你问这是什么,它的另一个名字是 Nano Banana 2。这么跟个恶搞一样的名字,居然被保留下来了。

扩散概率生成模型(Diffusion Models)已成为AIGC时代的重要基础,但其推理速度慢、训练与推理之间的差异大,以及优化困难,始终是制约其广泛应用的关键问题。近日,被NeurIPS 2025接收的一篇重磅论文EVODiff给出了全新解法:来自华南理工大学曾德炉教授「统计推断,数据科学与人工智能」研究团队跳出了传统的数值求解思维,首次从信息感知的推理视角,将去噪过程重构为实时熵减优化问题。