知识储备≠模型能力!DeepMind强化学习微调:大幅缩小「知行差距」

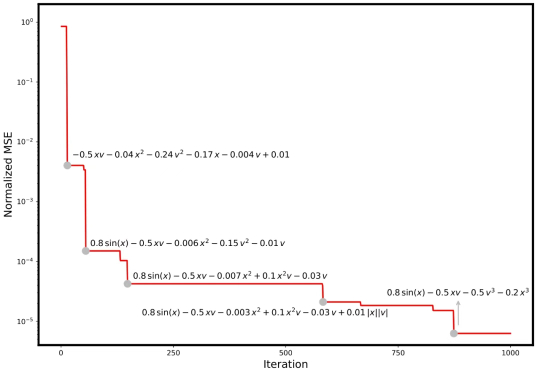

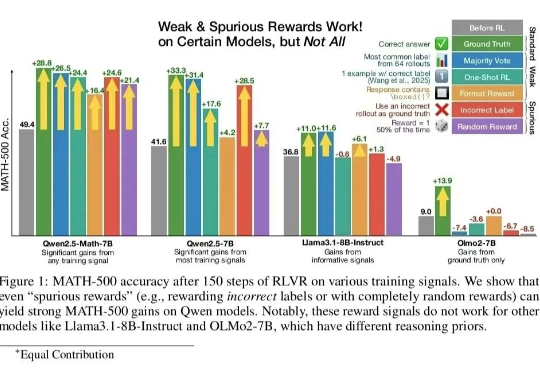

知识储备≠模型能力!DeepMind强化学习微调:大幅缩小「知行差距」大语言模型(LLMs)在决策场景中常因贪婪性、频率偏差和知行差距表现欠佳。研究者提出强化学习微调(RLFT),通过自我生成的推理链(CoT)优化模型,提升决策能力。实验表明,RLFT可增加模型探索性,缩小知行差距,但探索策略仍有改进空间。

大语言模型(LLMs)在决策场景中常因贪婪性、频率偏差和知行差距表现欠佳。研究者提出强化学习微调(RLFT),通过自我生成的推理链(CoT)优化模型,提升决策能力。实验表明,RLFT可增加模型探索性,缩小知行差距,但探索策略仍有改进空间。

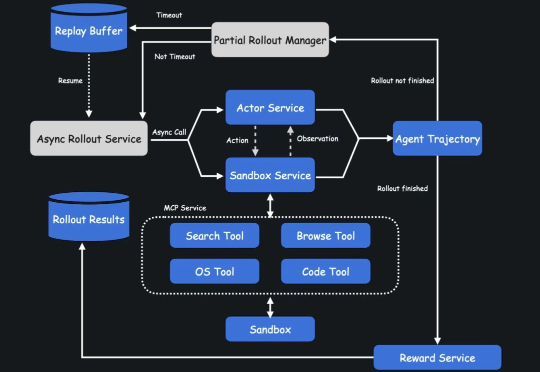

这款 Agent 擅长多轮搜索和推理,平均每项任务执行 23 个推理步骤,访问超过 200 个网址。它是基于 Kimi k 系列模型的内部版本构建,并完全通过端到端智能体强化学习进行训练,也是国内少有的基于自研模型打造的 Agent。

一个大模型有了火星图片,能做什么?

一个真实世界模拟器。

最近,一类「穿越 vlog」爆火了。有人让 Veo 3 变成「时间机器」,将人们带回历史事件中进行现场直播。

随着语言模型在强化学习和 agentic 领域的进步,agent 正在从通用领域快速渗透到垂直领域,科学和生物医药这类高价值领域尤其受到关注。

随着 AI4Science 的浪潮席卷科研各领域,如何将强大的人工智能模型真正用于分析科学数据、构建数学模型、发现科学规律,正成为该领域亟待突破的关键问题。

在人工智能领域,大型语言模型(LLM)的推理能力正以前所未有的速度发展。

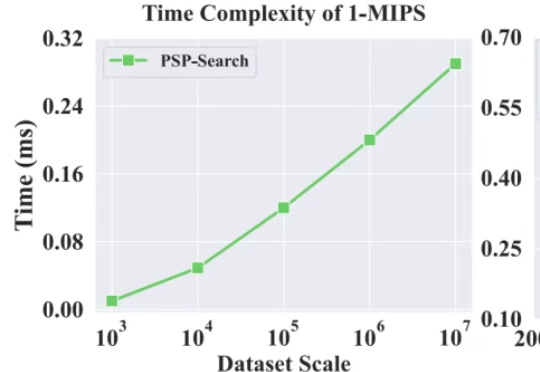

只需修改两行代码,RAG向量检索效率暴涨30%!

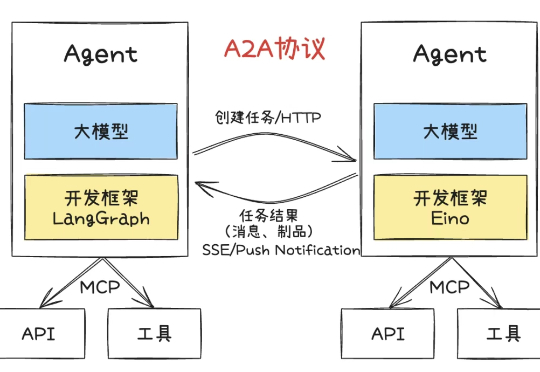

在 AI Agent 浪潮席卷行业的当下,高效优雅开发具备复杂推理与协作能力的智能体成为业界焦点。本文将系统梳理 AI Agent 核心理念、主流协议与思考框架,并结合 Golang 生态工程化框架,深入剖析多 Agent 协作系统的设计与落地。